RAGチャットボットからコードアシスタント、複雑なエージェントパイプラインなど、トレース、評価、ダッシュボードでより良く、より速く、安価なLLMシステムを構築します。

ウェブサイト•スラックコミュニティ• Twitter •ドキュメント

OPIKは、LLMアプリケーションを評価、テスト、監視するためのオープンソースプラットフォームです。彗星によって建てられました。

OPIKを使用できます。

発達:

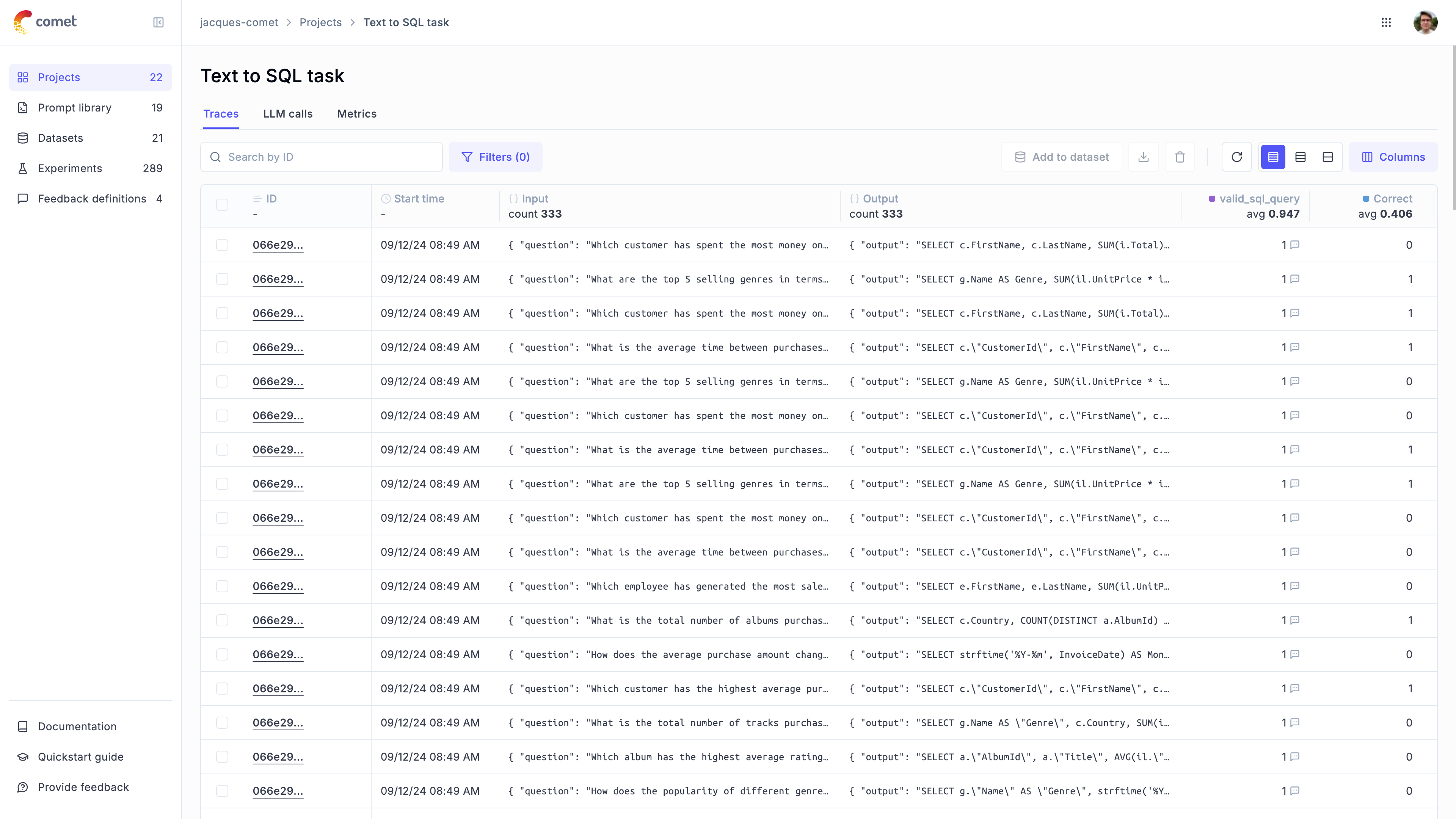

トレース:開発と生産中にすべてのLLMコールとトレースを追跡します(QuickStart、統合

注釈: Python SDKまたはUIを使用して、フィードバックスコアを記録することにより、LLMコールを注釈します。

遊び場::迅速な遊び場でさまざまなプロンプトとモデルを試してみてください

評価:LLMアプリケーションの評価プロセスを自動化します。

データセットと実験:テストケースを保存し、実験を実行します(データセット、LLMアプリケーションを評価)

裁判官メトリックとしてのLLM :幻覚検出、緩和、ぼろきれの評価などの複雑な問題のために、OpikのLLMを裁判官メトリックとして使用します(回答関連、コンテキストの精度

CI/CD統合:Pytest統合を使用してCI/CDパイプラインの一部として評価を実行します

生産監視:

すべての生産トレースを記録します。OPIKは、大量のトレースをサポートするように設計されており、生産アプリケーションを簡単に監視できます。小さな展開でさえ、1日あたり4,000万件以上の痕跡を摂取できます!

ダッシュボードの監視:OPIKダッシュボードで、時間の経過とともにフィードバックスコア、トレースカウント、トークンを確認します。

オンライン評価メトリック:OPIKのオンライン評価メトリックのおかげで、LLMを使用してLLMを使用してすべての生産トレースを簡単に獲得し、生産LLMアプリケーションの問題を特定してください

ヒント

Opikが今日持っていない機能を探している場合は、新しい機能のリクエストを提起してください

OPIKは、完全にオープンソースのローカルインストールとして、またはホストされたソリューションとしてcomet.comを使用しています。 OPIKを始める最も簡単な方法は、Comet.comで無料のCometアカウントを作成することです。

OPIKを自己ホストしたい場合は、リポジトリをクローン化し、Docker Composeを使用してプラットフォームを起動することでそうすることができます。

# Clone the Opik repository

git clone https://github.com/comet-ml/opik.git

# Navigate to the opik/deployment/docker-compose directory

cd opik/deployment/docker-compose

# Start the Opik platform

docker compose up --detach

# You can now visit http://localhost:5173 on your browser!さまざまな展開オプションの詳細については、展開ガイドをご覧ください。

| インストール方法 | docsリンク |

|---|---|

| ローカルインスタンス | |

| Kubernetes |

開始するには、最初にPython SDKをインストールする必要があります。

pip install opik SDKがインストールされたら、 opik configureコマンドを実行して構成できます。

opik configureこれにより、正しいローカルサーバーアドレスを設定することにより、またはAPIキーを設定してクラウドプラットフォームを使用している場合、OPIKをローカルに構成できます。

ヒント

Pythonコードからopik.configure(use_local=True)メソッドを呼び出して、ローカルインストールで実行するようにSDKを構成することもできます。

これで、Python SDKを使用してトレースのロギングを開始する準備ができました。

開始する最も簡単な方法は、統合の1つを使用することです。 OPIKはサポートしています:

| 統合 | 説明 | ドキュメント | colabで試してみてください |

|---|---|---|---|

| Openai | すべてのOpenAI LLM呼び出しのログトレース | ドキュメント | |

| litellm | OpenAI形式を使用してLLMモデルを呼び出します | ドキュメント | |

| ラングチェーン | すべてのLangchain LLM呼び出しのログトレース | ドキュメント | |

| ヘイスタック | すべてのHaystack呼び出しのログトレース | ドキュメント | |

| 人類 | すべての人類LLMコールのログトレース | ドキュメント | |

| 岩盤 | すべてのBedrock LLMコールのログトレース | ドキュメント | |

| クルワイ | すべてのCrewaiコールのログトレース | ドキュメント | |

| deepseek | すべてのDeepSeek LLMコールのログトレース | ドキュメント | |

| dspy | すべてのDSPY実行のログトレース | ドキュメント | |

| ジェミニ | すべてのGemini LLMコールのログトレース | ドキュメント | |

| groq | すべてのGROQ LLM呼び出しのログトレース | ドキュメント | |

| ガードレール | すべてのGuardRailsの検証のログトレース | ドキュメント | |

| ランググラフ | すべてのランググラフ実行のログトレース | ドキュメント | |

| llamaindex | すべてのllamaindex LLMコールのログトレース | ドキュメント | |

| オラマ | すべてのOllama LLMコールのログトレース | ドキュメント | |

| プレフェーゼ | オープンソースの大規模な言語モデルを微調整して提供します | ドキュメント | |

| ラガス | 検索拡張生成(RAG)パイプラインの評価フレームワーク | ドキュメント | |

| ワトソンズ | すべてのwatsonx LLMコールのログトレース | ドキュメント |

ヒント

使用しているフレームワークが上記にリストされていない場合は、お気軽に問題を開いたり、統合のあるPRを提出してください。

上記のフレームワークを使用していない場合は、 track機能デコレータを使用してトレースを記録することもできます。

import opik

opik . configure ( use_local = True ) # Run locally

@ opik . track

def my_llm_function ( user_question : str ) -> str :

# Your LLM code here

return "Hello" ヒント

トラックデコレーターは、当社の統合のいずれかと組み合わせて使用でき、ネストされた関数呼び出しを追跡するためにも使用できます。

Python Opik SDKには、LLMアプリケーションを評価するのに役立つ裁判官メトリックとして多くのLLMが含まれています。 Metricsドキュメントで詳細をご覧ください。

それらを使用するには、関連するメトリックをインポートし、 score関数を使用するだけです。

from opik . evaluation . metrics import Hallucination

metric = Hallucination ()

score = metric . score (

input = "What is the capital of France?" ,

output = "Paris" ,

context = [ "France is a country in Europe." ]

)

print ( score )Opikには、多くの事前に構築されたヒューリスティックメトリックと、独自の作成能力も含まれています。 Metricsドキュメントで詳細をご覧ください。

OPIKを使用すると、データセットと実験を通じて開発中にLLMアプリケーションを評価できます。

Pytest統合を使用して、CI/CDパイプラインの一部として評価を実行することもできます。

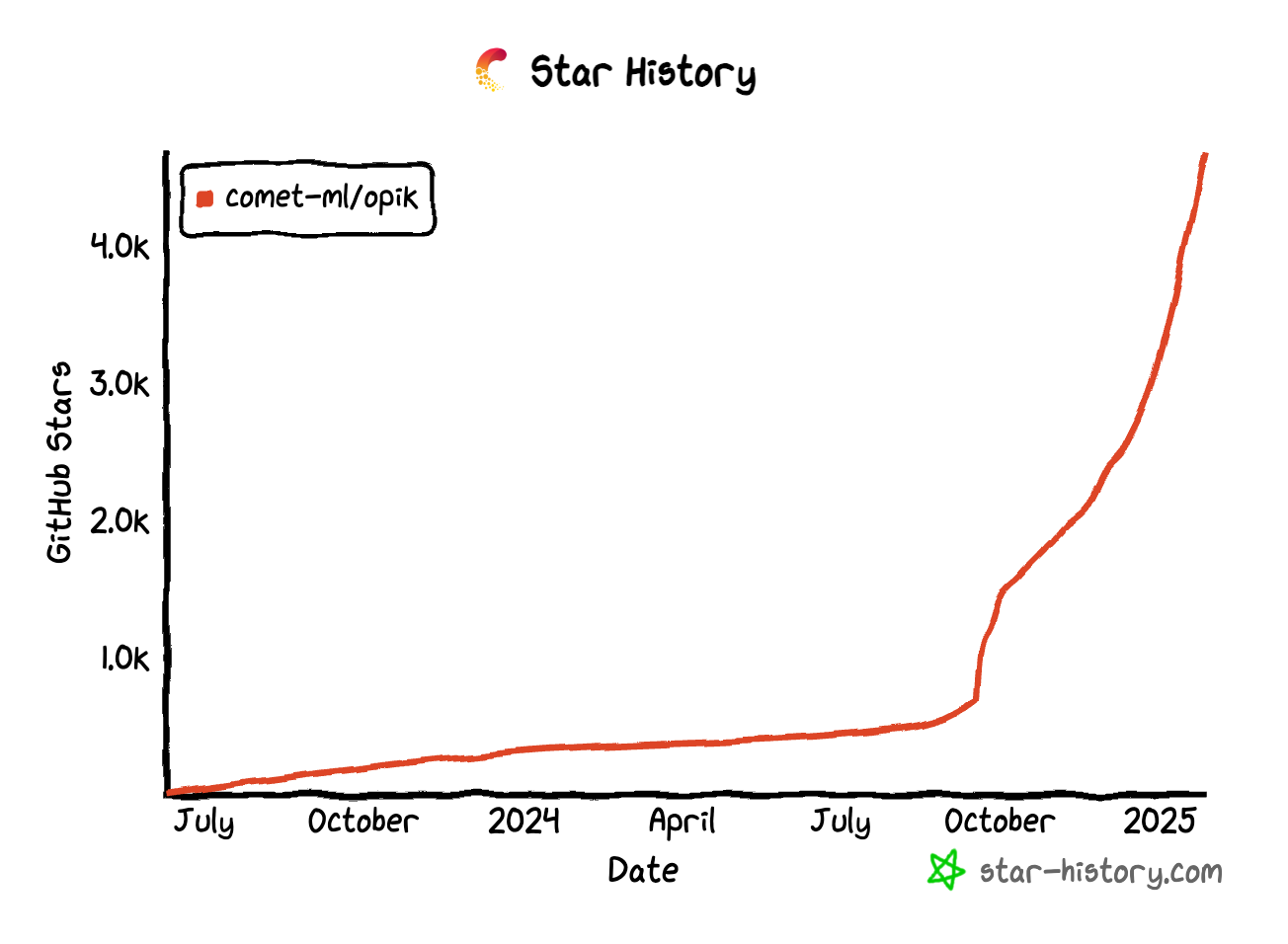

OPIKが便利だと思う場合は、私たちにスターを与えることを検討してください!あなたのサポートは、私たちがコミュニティを成長させ、製品を改善し続けるのに役立ちます。

Opikに貢献する方法はたくさんあります:

OPIKに貢献する方法の詳細については、貢献ガイドラインをご覧ください。