Consulte https://neosheets.com (https://github.com/suhjohn/neosheets) para o V2 dessa ideia.

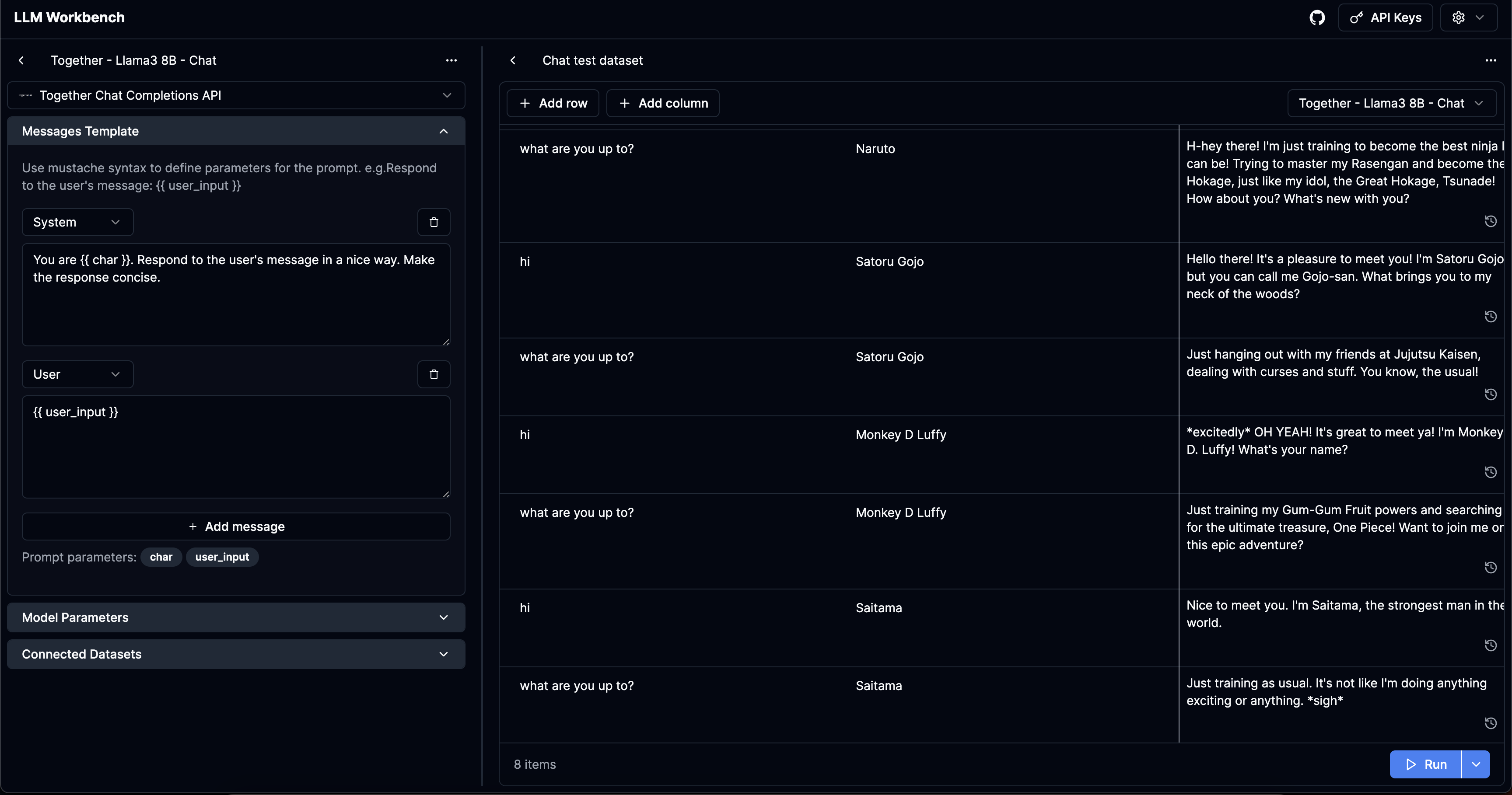

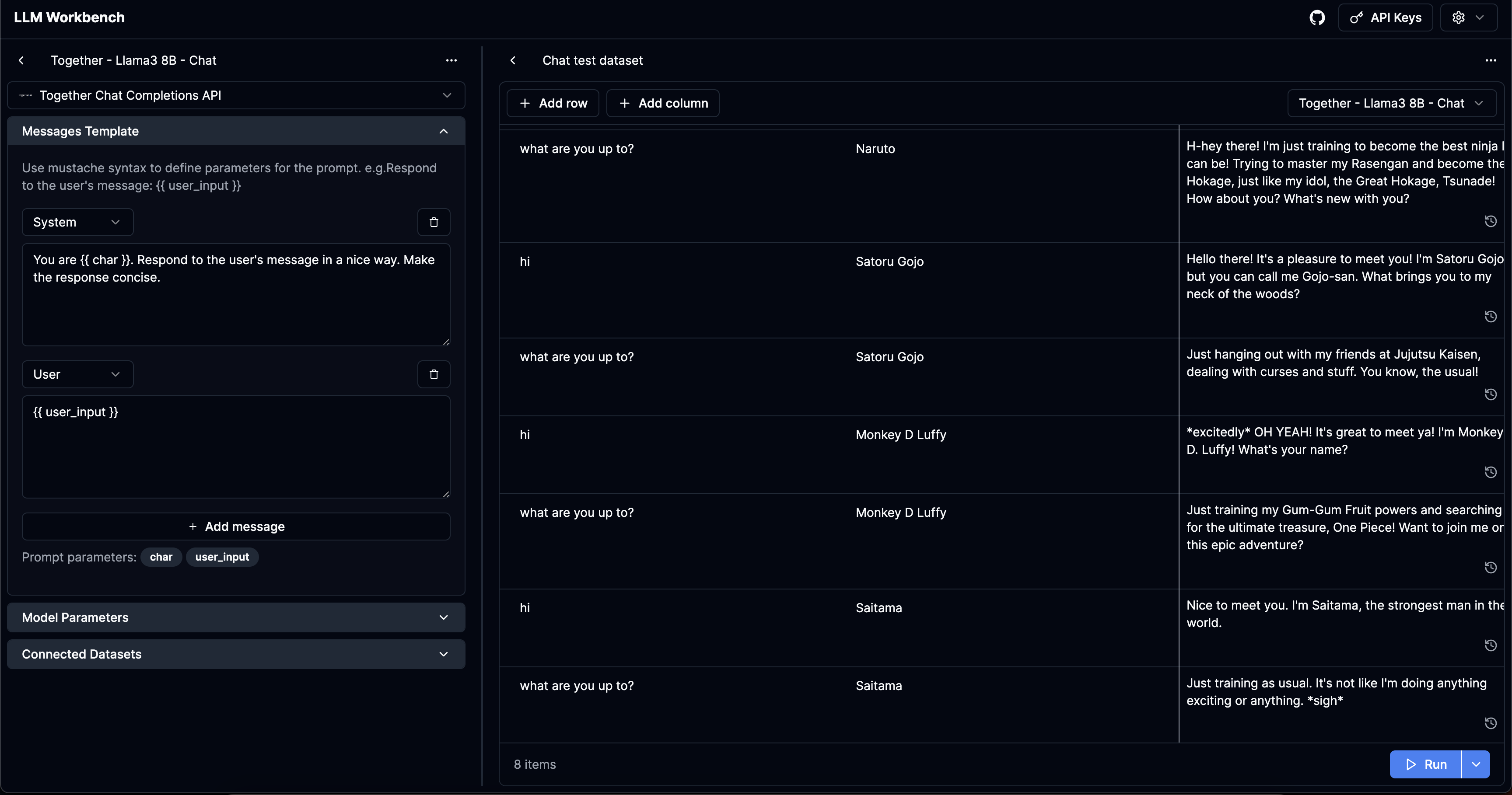

LLM Workbench

https://www.llmwb.com/

Workbench sobrealimentado para LLMS. Modelos de prompt de teste de diferentes modelos e fornecedores com conjuntos de dados de argumentos rápidos para substituir os espaços reservados.

Problema

Eu construí três chatbots diferentes agora. No processo, tive que criar subconjuntos de maneira fiscal dos recursos suportados por este aplicativo. Eu também queria ter uma plataforma sem código para testar os avisos de vários argumentos para ver como o prompt funciona.

Pessoalmente, não acho as bibliotecas de escritores de prompt de automóvel que atraem-quero obter uma verificação de vibração decente o suficiente em vários parâmetros.

Pessoalmente, também não uso nenhuma das bibliotecas de abstração e não as acho tão úteis. No entanto, parecia poucas ferramentas para as pessoas que desejam os prompts de teste de cachorro cru.

Fui inspirado pela recente plataforma de Workbench da Anthropic parecia um bom intensivo do playground do Openai.

O aplicativo resolve esses problemas específicos do usuário:

- Para um prompt LLM específico que leva

args: Record<string, string> Como seus parâmetros de prompt, quero poder testar diferentes parâmetros do modelo. - Para um LLM PROPMT específico, quero testar diferentes conjuntos de parâmetros rápidos, talvez casos felizes ou casos que eu vi falhar de alguma forma.

- Para um conjunto específico de parâmetros rápidos, quero testar diferentes prompts LLM para fazer uma verificação de vibração em suas saídas.

- (Os provedores parecem ter parâmetros padrão diferentes, especialmente para modelos de código aberto), quero testar o mesmo modelo de prompt + para diferentes provedores para entender seu comportamento

- Quero visualizar o histórico de várias execuções para um conjunto específico de parâmetro que eu forneci.

Características

- Crie "modelos": mensagens / solicitações brutas que usam

{{ }} para denotar variáveis usando o bustach.js. - Crie "conjuntos de dados": crie uma lista de variáveis nas quais você deseja testar os modelos.

- Suporte a todos os parâmetros: seja capaz de inserir todos os parâmetros disponíveis para diferentes APIs, bem como na interface do usuário. Descobri que muitas ferramentas de playground semi-profissional não suportam parâmetros como ferramentas ou logit_bias. O projeto é construído para poder estender facilmente novos parâmetros quando forem adicionados pelos provedores.

- Apoie todos os provedores significativos no ecossistema:

Pendência

- Entrada manual de argumentos rápidos como json

- Importar CSV

- Controle de versão Prompts e conjuntos de dados

- Fornecedores personalizados e modelos personalizados

- Parâmetros de entrada multimodal +

- Alternar colunas visíveis + mostrar entradas compiladas

- Promotos padrão + compartilhar dados

Segurança

Os modelos / teclas de dados / API que você adiciona no site são armazenados localmente apenas no seu navegador.

Executando localmente

LLM Workbench A partir de agora é apenas um aplicativo Next.js. Supondo que você tenha fios, você pode correr com o seguinte: