Consulte https://neosheets.com (https://github.com/suhjohn/NeosheEts) para el V2 de esta idea.

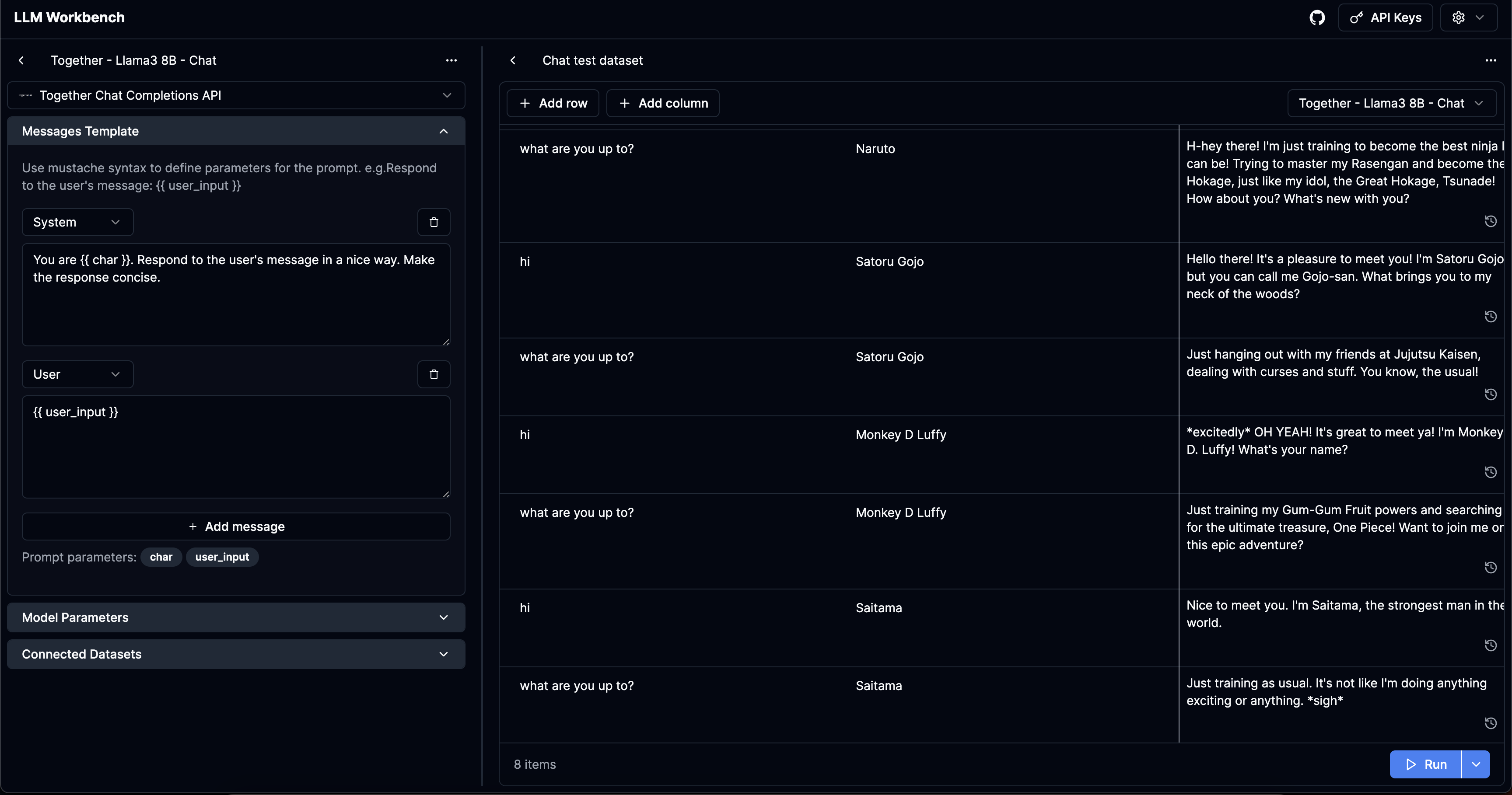

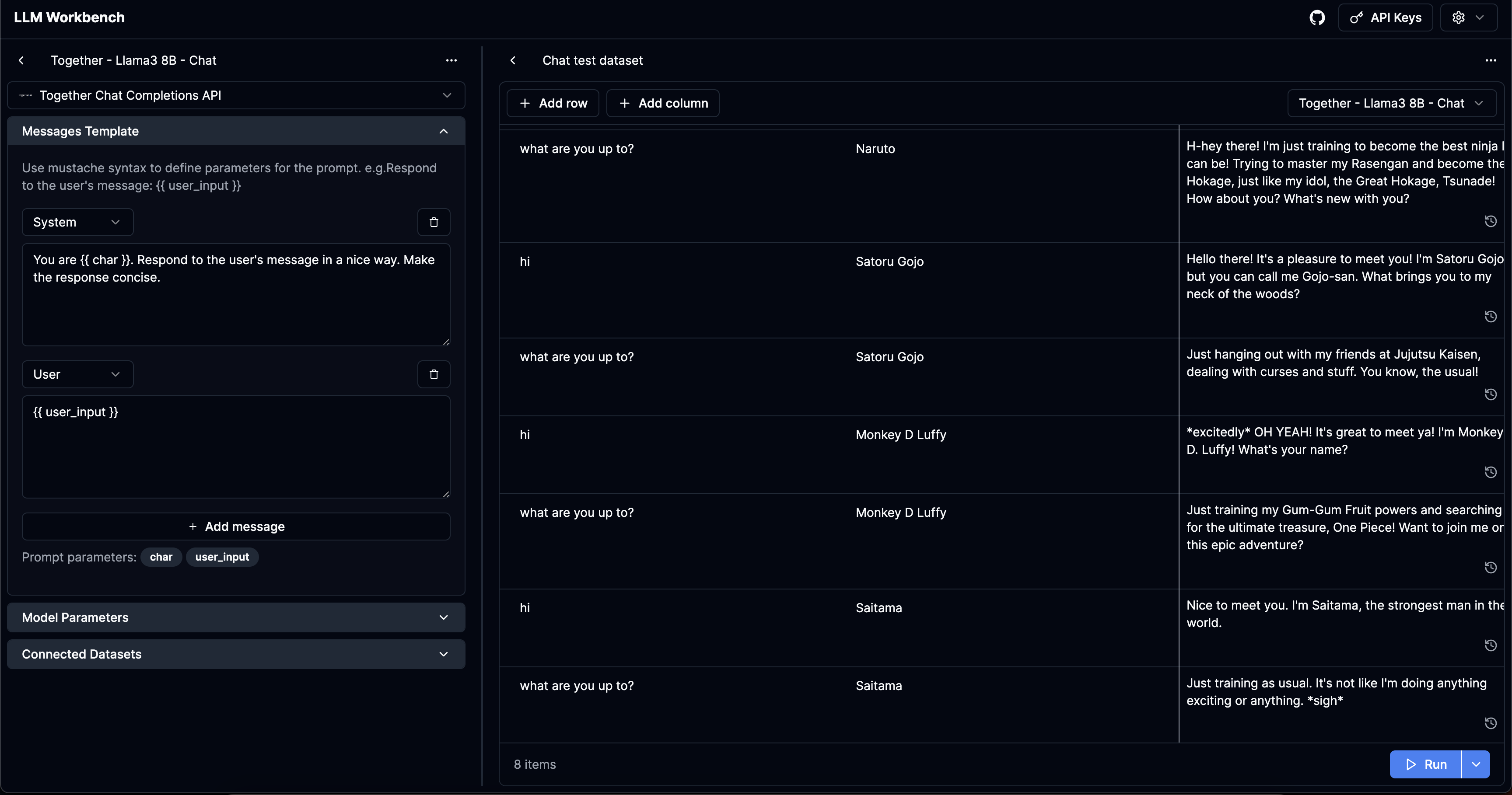

LLM Workbench

https://www.llmwb.com/

Banco de trabajo sobrealimentado para LLM. Probar plantillas de solicitud de diferentes modelos y proveedores con conjuntos de datos de argumentos rápidos para reemplazar a los marcadores de posición.

Problema

He construido tres chatbots de IA diferentes ahora. En el proceso, he tenido que construir subconjuntos de las características compatibles con esta aplicación. También he querido tener una plataforma sin código para probar las indicaciones de varios argumentos para ver cómo funciona el aviso.

Personalmente, no encuentro las bibliotecas de escritura rápida automáticamente tan atractivas: quiero obtener una verificación lo suficientemente decente en una variedad de parámetros.

Personalmente, tampoco uso ninguna de las bibliotecas de abstracción y no las encuentro tan útiles. Sin embargo, parecía pocas herramientas para las personas que desean las indicaciones de prueba en bruto.

Me inspiré en la reciente plataforma de trabajo de trabajo de Anthrope parecía un buen escalón del patio de Openi.

La aplicación resuelve estos problemas específicos del usuario:

- Para un indicador de LLM específico que requiere

args: Record<string, string> como sus parámetros de inmediato, quiero poder probar diferentes parámetros del modelo. - Para un propMT de LLM específico, quiero probar diferentes conjuntos de parámetros rápidos, tal vez un caso feliz o casos que he visto fallan de alguna manera.

- Para un conjunto específico de parámetros rápidos, quiero probar diferentes indicaciones de LLM para verificar sus salidas en sus salidas.

- (Los proveedores parecen tener diferentes parámetros predeterminados, especialmente para los modelos de código abierto) Quiero probar el mismo modelo + modelo para que los diferentes proveedores comprendan su comportamiento

- Quiero ver el historial de múltiples ejecuciones para un conjunto específico de parámetros que he proporcionado.

Características

- Cree "plantillas": mensajes / indicaciones sin procesar que usan

{{ }} para denotar variables usando bigache.js. - Cree "conjuntos de datos": cree una lista de variables en las que desea probar las plantillas.

- Admite todos los parámetros: poder ingresar todos los parámetros disponibles para diferentes API, así como en la interfaz de usuario. Descubrí que muchas herramientas semiprofesionales de juegos no admiten parámetros como herramientas o logit_bias. El proyecto está creado para poder extender fácilmente nuevos parámetros cuando los proveedores los agregan.

- Apoyar a todos los proveedores significativos en el ecosistema:

Hacer

- Entrada manual de argumentos rápidos como JSON

- Importar CSV

- Instalaciones de control de versiones y conjuntos de datos

- Proveedores personalizados y modelos personalizados

- Entrada multimodal + parámetros

- Alternar columnas visibles + Mostrar entradas compiladas

- Indicaciones predeterminadas + compartir datos

Seguridad

Las plantillas / claves de datos / API que agrega en el sitio web solo se almacenan localmente en su navegador.

Ejecutando localmente

LLM Workbench a partir de ahora es solo una aplicación Next.js. Suponiendo que tienes hilo, puedes ejecutar con lo siguiente: