Reportez-vous à https://neoSheets.com (https://github.com/suhjohn/neoSheets) pour le V2 de cette idée.

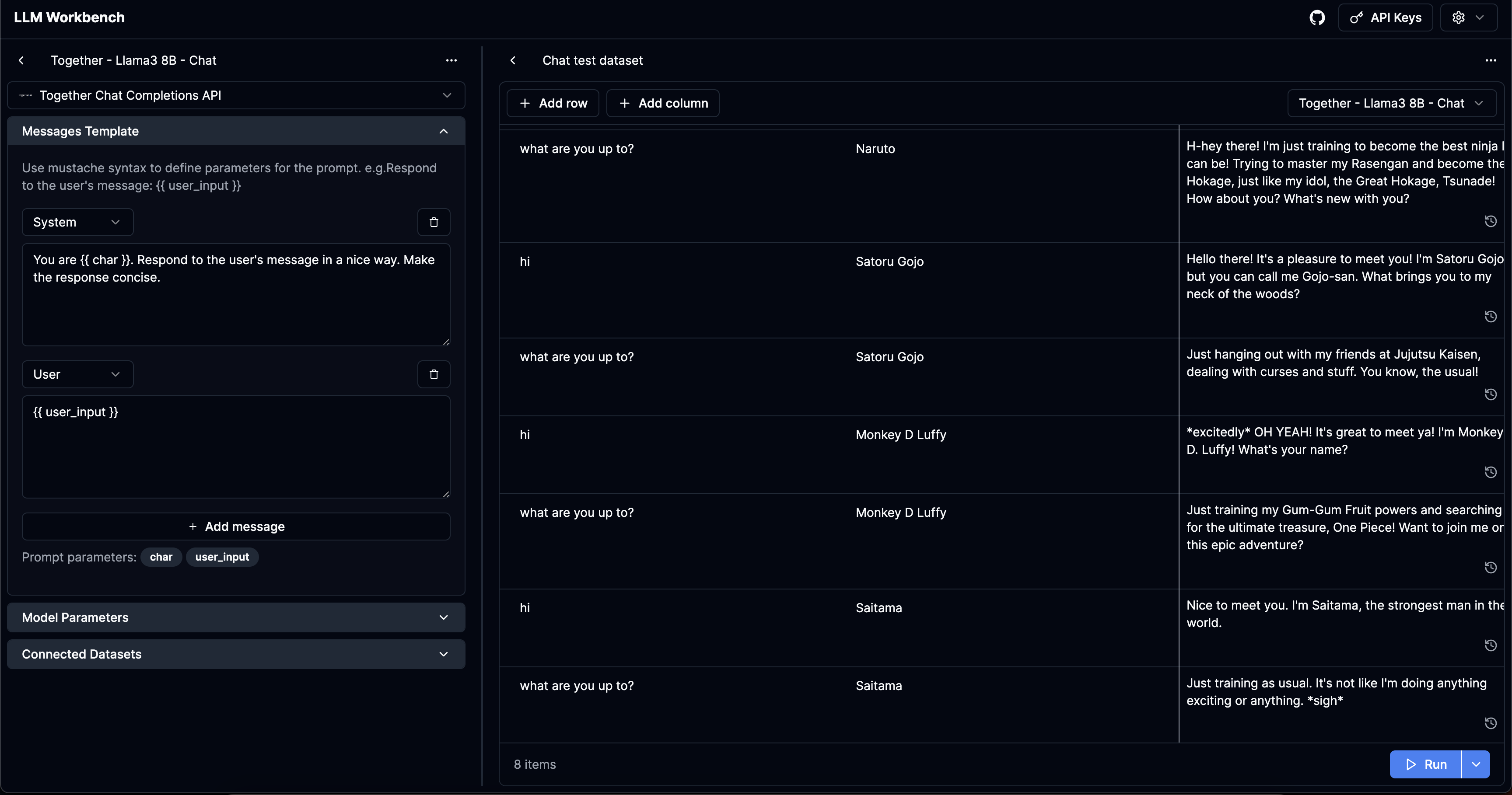

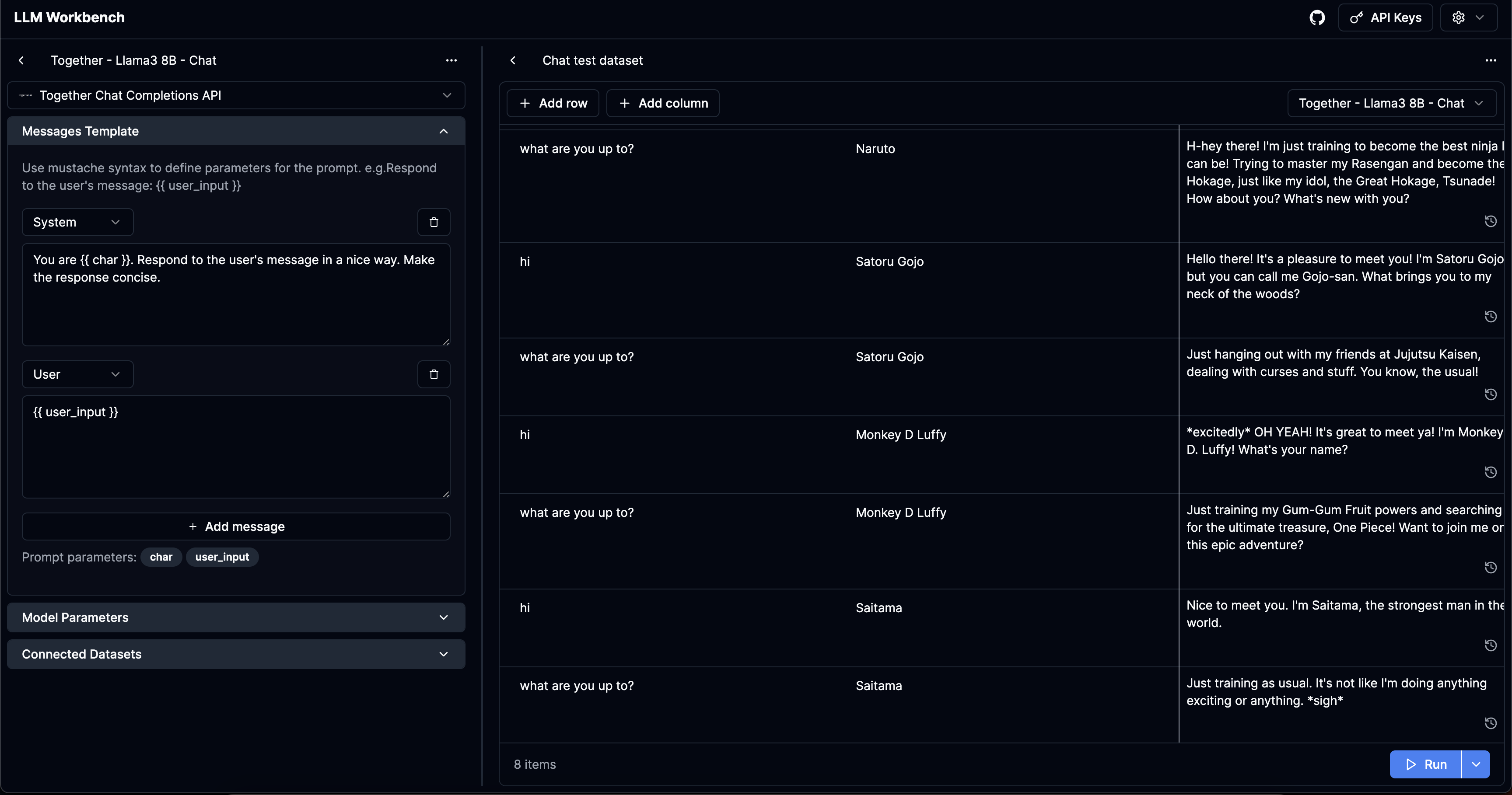

LLM Workbench

https://www.llmwb.com/

Workbench suralimenté pour LLMS. Test des modèles d'invite de différents modèles et fournisseurs avec des ensembles de données d'arguments rapides pour remplacer les espaces réservés.

Problème

J'ai construit trois chatbots AI différents maintenant. Dans le processus, j'ai dû construire des sous-ensembles de façon complets des fonctionnalités prises en charge par cette application. J'ai également voulu avoir une plate-forme sans code pour tester les invites pour divers arguments pour voir comment fonctionne l'invite.

Personnellement, je ne trouve pas les bibliothèques de rédacteurs automobiles automatiques qui attrayantes - je veux obtenir une ambiance assez décente sur une variété de paramètres.

Personnellement, je n'utilise aucune des bibliothèques d'abstraction et je ne les trouve pas aussi utiles. Cependant, il semblait peu d'outillage pour les personnes qui veulent des invites de test de chiens brutes.

J'ai été inspiré par la récente plate-forme de Workbench d'Anthropic semblait être une bonne étape de l'aire de jeux d'Openai.

L'application résout ces problèmes d'utilisateur spécifiques:

- Pour une invite LLM spécifique qui prend

args: Record<string, string> comme paramètres d'invite, je veux pouvoir tester différents paramètres de modèle. - Pour un LLM PropMT spécifique, je souhaite tester différents ensembles de paramètres rapides, peut-être un cas heureux ou des cas que j'ai vus échouer d'une manière ou d'une autre.

- Pour un ensemble spécifique de paramètres d'invite, je souhaite tester différentes invites LLM pour effectuer une vérification d'ambiance sur leurs sorties.

- (Les fournisseurs semblent avoir des paramètres par défaut différents, en particulier pour les modèles open source) Je veux tester le même modèle d'invite + pour que différents fournisseurs comprennent leur comportement

- Je veux afficher l'historique de plusieurs exécutions pour un ensemble spécifique de paramètre que j'ai fourni.

Caractéristiques

- Créer "Modèles": Messages / invites brutes qui utilisent

{{ }} pour indiquer des variables à l'aide de Mustache.js. - Créez des "ensembles de données": créez une liste de variables sur lesquelles vous souhaitez tester les modèles.

- Prise en charge de tous les paramètres: être en mesure de saisir tous les paramètres disponibles pour différentes API ainsi que sur l'interface utilisateur. J'ai trouvé que de nombreux outils de terrain de jeu semi-professionnels ne prennent pas en charge les paramètres comme les outils ou Logit_bias. Le projet est conçu pour pouvoir étendre facilement de nouveaux paramètres lorsqu'ils sont ajoutés par les fournisseurs.

- Soutenez tous les fournisseurs significatifs dans l'écosystème:

Faire

- Entrée manuelle des arguments rapides en tant que JSON

- Importer CSV

- Invites et ensembles de données de contrôle de version

- Provideurs personnalisés et modèles personnalisés

- Entrée multimodale + paramètres

- Basculer les colonnes visibles + afficher les entrées compilées

- Invites par défaut + Données de partage

Sécurité

Les modèles / ensembles de données / touches API que vous ajoutez sur le site Web ne sont stockés que localement sur votre navigateur.

Courir localement

LLM Workbench à partir de maintenant n'est qu'une application Next.js. En supposant que vous avez du fil, vous pouvez courir avec les suivants: