Weitere Informationen finden Sie unter https://neosheets.com (https://github.com/suhjohn/neosheets) für die V2 dieser Idee.

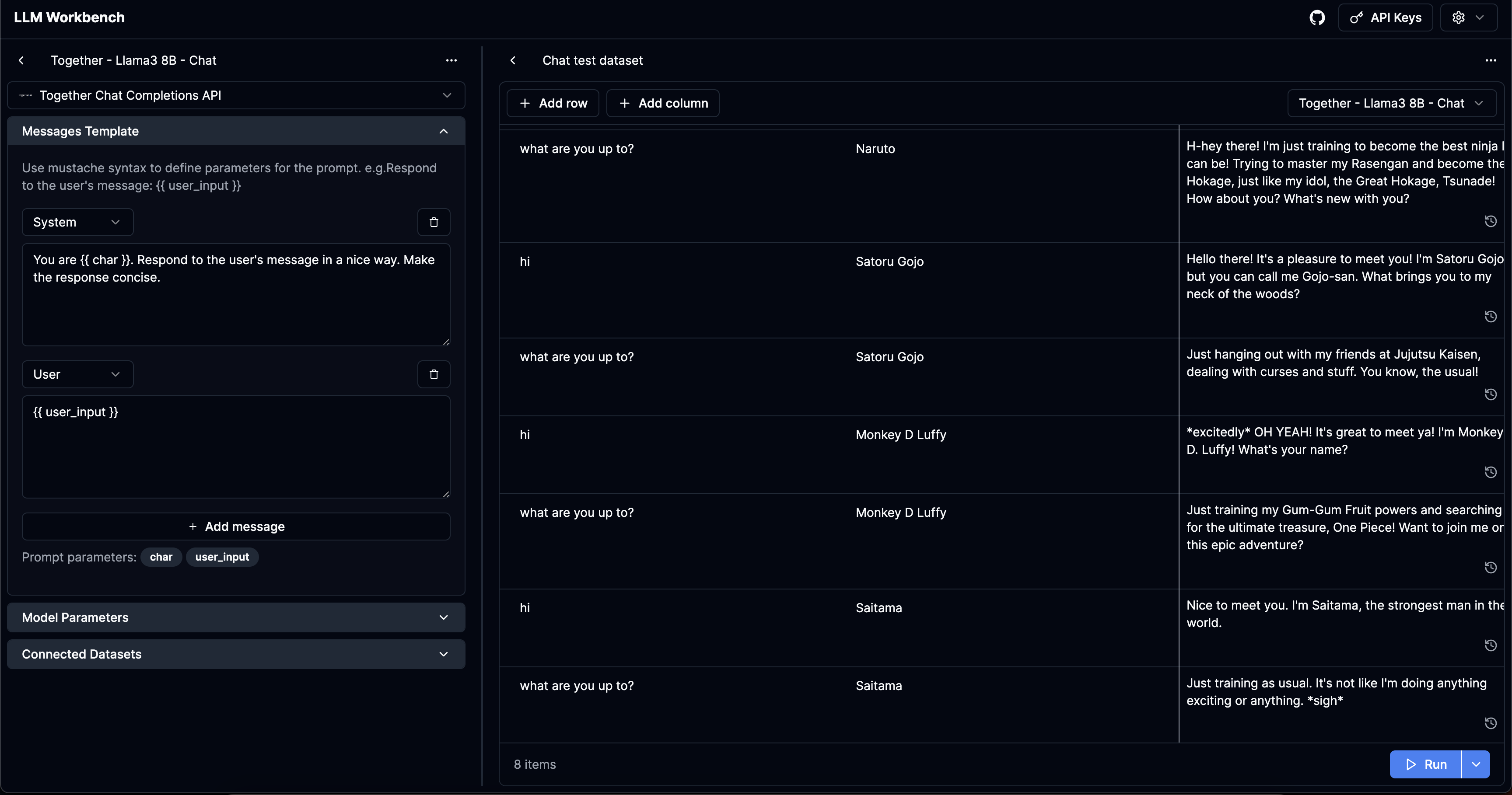

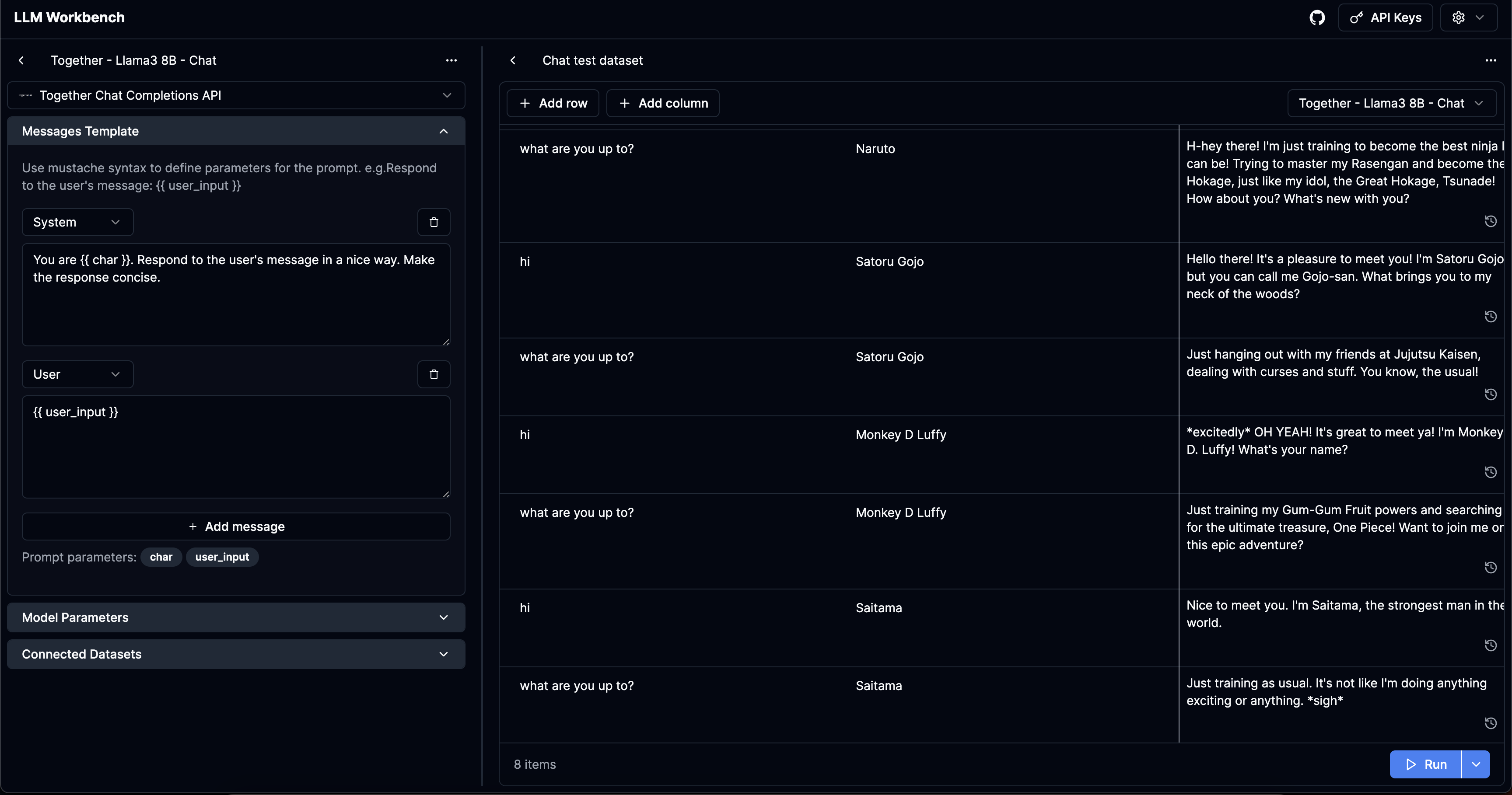

LLM Workbench

https://www.llmwb.com/

Aufgeladene Workbench für LLMs. Testen Sie Eingabeaufforderungsvorlagen aus verschiedenen Modellen und Anbietern mit Datensätzen mit schnellen Argumenten, um die Platzhalter zu ersetzen.

Problem

Ich habe jetzt drei verschiedene KI -Chatbots gebaut. Dabei musste ich schlechte Untergruppen der von dieser Anwendung unterstützten Funktionen erstellen. Ich wollte auch eine No-Code-Plattform haben, um Eingabeaufforderungen für verschiedene Argumente zu testen, um zu sehen, wie die Eingabeaufforderung funktioniert.

Ich persönlich finde die Automatik-Eingabeaufforderung-Bibliotheken nicht ansprechend-ich möchte eine angemessene Atmosphäre über eine Vielzahl von Parametern über eine angemessene Atmosphäre kommen.

Ich persönlich verwende auch keine der Abstraktionsbibliotheken und finde sie nicht so nützlich. Es schien jedoch wenig Werkzeuge für Leute zu sein, die Rohdogentests eingeben möchten.

Ich ließ mich von Anthropics jüngster Workbench-Plattform inspirieren, schien ein guter Aufstieg auf dem Spielplatz von Openai zu sein.

Die Anwendung löst diese spezifischen Benutzerprobleme:

- Für eine bestimmte LLM -Eingabeaufforderung, die

args: Record<string, string> Als Eingabeaufforderungsparameter benötigt, möchte ich in der Lage sein, verschiedene Modellparameter zu testen. - Für ein bestimmtes LLM -ProPMT möchte ich verschiedene Sätze von Eingabeaufforderungsparametern testen, vielleicht glücklichen Fall oder Fälle, die ich irgendwie fehlgeschlagen habe.

- Für eine bestimmte Reihe von Eingabeaufforderungsparametern möchte ich verschiedene LLM-Aufforderungen testen, um eine Vibe-Prüfung auf ihren Ausgängen durchzuführen.

- (Anbieter scheinen unterschiedliche Standardparameter zu haben, insbesondere für Open -Source -Modelle) Ich möchte dasselbe Eingabeaufforderung + -Modell für verschiedene Anbieter testen, um ihr Verhalten zu verstehen

- Ich möchte die Geschichte mehrerer Läufe für einen bestimmten Satz von Parametern anzeigen, den ich bereitgestellt habe.

Merkmale

- Erstellen Sie "Vorlagen": Nachrichten / RAW -Eingabeaufforderungen, die

{{ }} verwenden, um Variablen mit redache.js zu bezeichnen. - Erstellen Sie "Datensätze": Erstellen Sie eine Liste von Variablen, auf denen Sie die Vorlagen testen möchten.

- Unterstützen Sie alle Parameter: In der Lage sein, alle für unterschiedlichen APIs verfügbaren Parameter sowie auf der Benutzeroberfläche zur Verfügung zu stellen. Ich habe festgestellt, dass viele semi-professionelle Spielplätze-Tools Parameter wie Tools oder Logit_Bias nicht unterstützen. Das Projekt ist so entwickelt, dass sie in der Lage sein können, neue Parameter leicht zu erweitern, wenn sie von Anbietern hinzugefügt werden.

- Unterstützen Sie alle sinnvollen Anbieter im Ökosystem:

Todo

- Manuelle Eingabe von sofortigen Argumenten als JSON

- CSV importieren

- Versionskontrollanforderungen und Datensätze

- Benutzerdefinierte Anbieter und benutzerdefinierte Modelle

- Multimodale Eingabe + Parameter

- Sichtbare Spalten umschalten + kompilierte Eingänge anzeigen

- Standardeingabeaufforderungen + Daten teilen

Sicherheit

Die Templates / Datasets / API -Schlüssel, die Sie auf der Website hinzufügen, werden nur lokal in Ihrem Browser gespeichert.

Vor Ort laufen

LLM Workbench ist ab sofort nur eine Next.js -App. Angenommen, Sie haben Garn, können Sie mit Folgendem laufen: