Este é o repositório oficial para a recapitulação do artigo: Legenda de áudio de recuperação de recuperação aceita no ICASSP 2024 para apresentação oral.

[ Paper ] [ CLAP Checkpoints ] [ Weakly labeled captions for AudioSet, AudioCaps, and Clotho ]

NOTA : Os pontos de verificação de palmas devem ser usados com os modelos e o código definidos neste repositório.

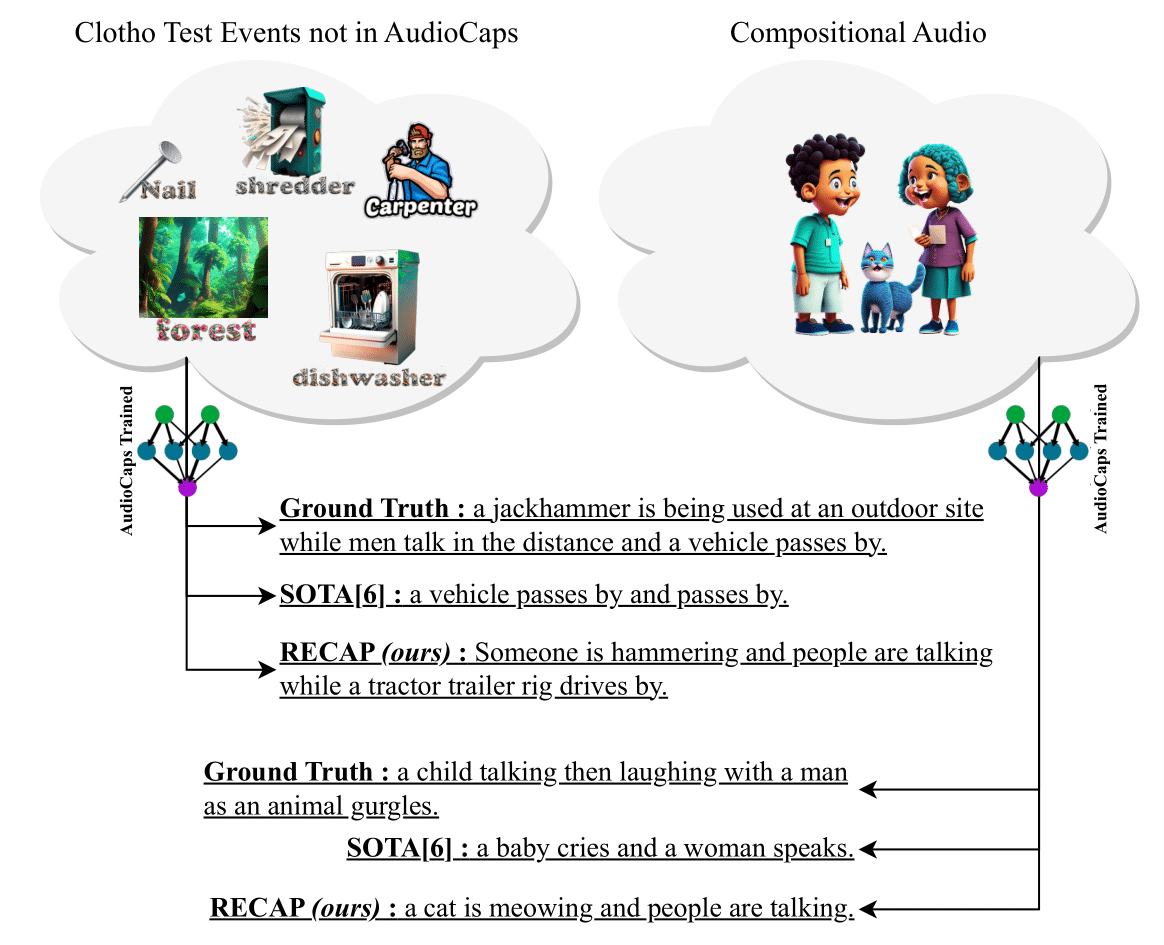

Apresentamos recapitulação (legenda de áudio de recuperação de recuperação), um novo e eficaz do sistema de legendamento de áudio que gera legendas condicionadas em um áudio de entrada e outras legendas semelhantes ao áudio recuperado de um armazenamento de dados. Além disso, nosso método proposto pode ser transferido para qualquer domínio sem a necessidade de qualquer ajuste fino adicional. Para gerar uma legenda para uma amostra de áudio, aproveitamos um modelo de modelo de texto de áudio para recuperar legendas semelhantes a ele de um armazenamento de dados substituível, que é usado para construir um prompt. Em seguida, alimentamos esse prompt a um decodificador GPT-2 e introduzimos camadas de atendimento cruzado entre o codificador CLAP e o GPT-2 para condicionar o áudio para a geração de legendas. Experimentos em dois conjuntos de dados de referência, CloTo e Audiocaps, mostram que a recapitulação atinge o desempenho competitivo em ambientes no domínio e melhorias significativas nas configurações fora do domínio. Além disso, devido à sua capacidade de explorar um grande conjunto de dados de capas de texto apenas de maneira livre de treinamento , a recapitulação mostra recursos exclusivos de legendar novos eventos de áudio nunca vistos durante os áudios de treinamento e composição com vários eventos. Para promover pesquisas neste espaço, também lançamos mais de 150.000 novas legendas fracamente rotuladas para Audioset, Audiocaps e Cloto.

pip install -r requirements.txt . Se você instalou o CONDA, pode executar o seguinte: cd RECAP &&

conda create -n recap python=3.10 &&

conda activate recap &&

pip install -r requirements.txtbash recap.sh O repositório possui comandos de treinamento e inferência. Recomendamos fazê -los um por um. Depois de executar python train.py e salve um ponto de verificação, atualize os caminhos em python infer.py e inferir seu modelo treinado. --model_path refere-se à pasta pai em que seus pontos de verificação são salvos e --checkpoint_path refere-se ao ponto de verificação que você deseja usar (o código de treinamento economiza vários pontos de verificação, sempre que um número predefinido de etapas é concluído).

Depois de baixar nossos pontos de verificação de palmas, você pode usá -los para avaliação usando o CLAP.

Nossa base de código foi inspirada no SmallCap. Agradecemos aos autores por seu trabalho aberto.

@INPROCEEDINGS { 10448030 ,

author = { Ghosh, Sreyan and Kumar, Sonal and Reddy Evuru, Chandra Kiran and Duraiswami, Ramani and Manocha, Dinesh } ,

booktitle = { ICASSP 2024 - 2024 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) } ,

title = { Recap: Retrieval-Augmented Audio Captioning } ,

year = { 2024 } ,

volume = { } ,

number = { } ,

pages = { 1161-1165 } ,

keywords = { Training;Signal processing;Benchmark testing;Acoustics;Decoding;Feeds;Speech processing;Automated audio captioning;multimodal learning;retrieval-augmented generation } ,

doi = { 10.1109/ICASSP48485.2024.10448030 } }