Il s'agit du référentiel officiel du récapitulatif de papier: sous-titrage audio de la récupération acceptée à ICASSP 2024 pour la présentation orale.

[ Paper ] [ CLAP Checkpoints ] [ Weakly labeled captions for AudioSet, AudioCaps, and Clotho ]

Remarque : les points de contrôle CLAP sont destinés à être utilisés avec les modèles et le code défini dans ce référentiel.

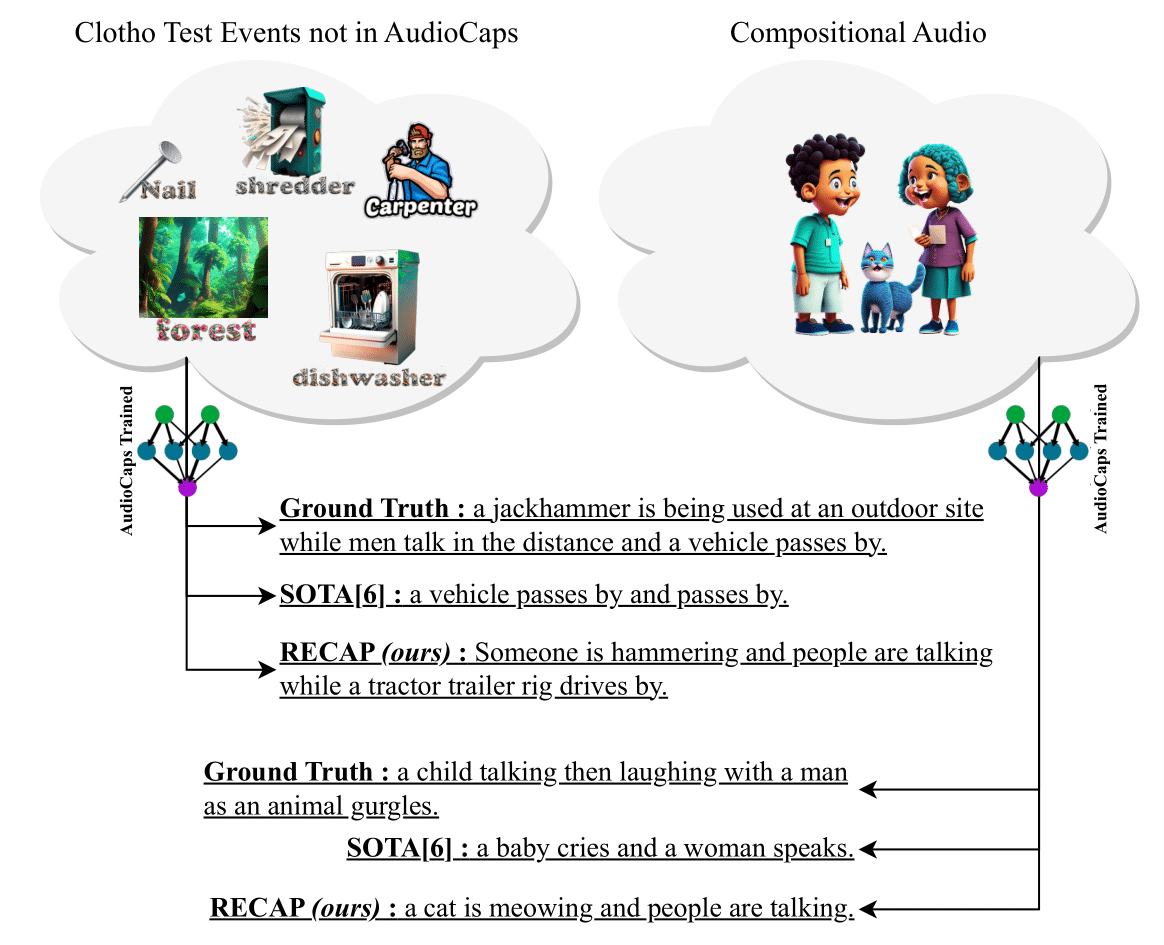

Nous présentons un récapitulatif (sous-titrage audio de la récupération), un système de sous-titrage audio nouveau et efficace qui génère des légendes conditionnées sur un audio d'entrée et d'autres légendes similaires à l'audio récupéré à partir d'un antécédent de données. De plus, notre méthode proposée peut transférer dans n'importe quel domaine sans avoir besoin d'un réglage fin supplémentaire. Pour générer une légende pour un échantillon audio, nous tirons parti d'un CLAP de modèle audio-texte pour récupérer des légendes similaires à celle d'un pasteur de données remplaçable, qui sont ensuite utilisés pour construire une invite. Ensuite, nous nourrissons cette invite à un décodeur GPT-2 et introduisons des couches croisées entre l'encodeur CLAP et GPT-2 pour conditionner l'audio pour la génération de légendes. Les expériences sur deux ensembles de données de référence, Clotho et Audiocaps, montrent que Recapt obtient des performances compétitives dans des paramètres dans le domaine et des améliorations significatives des paramètres hors du domaine. De plus, en raison de sa capacité à exploiter une grande carre de données sur les captions de texte uniquement de manière sans formation , Recap montre des capacités uniques de sous-titrage de nouveaux événements audio jamais vus lors de la formation et des audios de composition avec plusieurs événements. Pour promouvoir la recherche dans cet espace, nous publions également plus de 150 000 nouvelles légendes faiblement étiquetées pour AUDIOSET, Audiocaps et Clotho.

pip install -r requirements.txt . Si vous avez installé Conda, vous pouvez exécuter ce qui suit: cd RECAP &&

conda create -n recap python=3.10 &&

conda activate recap &&

pip install -r requirements.txtbash recap.sh Le référentiel a à la fois des commandes de formation et d'inférence. Nous vous recommandons de leur faire un par un. Une fois que vous exécutez python train.py et enregistrez un point de contrôle, mettez à jour les chemins dans python infer.py et déduisez votre modèle formé. --model_path fait référence au dossier parent où vos points de contrôle sont enregistrés, et --checkpoint_path fait référence au point de contrôle que vous souhaitez utiliser (le code de formation enregistre plusieurs points de contrôle, un à chaque fois qu'un nombre prédéfini d'étapes est terminé).

Une fois que vous avez téléchargé nos points de contrôle CLAP, vous pouvez les utiliser pour l'évaluation à l'aide de CLAP.

Notre base de code a été inspirée par SmallCap. Nous remercions les auteurs pour l'ouverture de leur travail.

@INPROCEEDINGS { 10448030 ,

author = { Ghosh, Sreyan and Kumar, Sonal and Reddy Evuru, Chandra Kiran and Duraiswami, Ramani and Manocha, Dinesh } ,

booktitle = { ICASSP 2024 - 2024 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) } ,

title = { Recap: Retrieval-Augmented Audio Captioning } ,

year = { 2024 } ,

volume = { } ,

number = { } ,

pages = { 1161-1165 } ,

keywords = { Training;Signal processing;Benchmark testing;Acoustics;Decoding;Feeds;Speech processing;Automated audio captioning;multimodal learning;retrieval-augmented generation } ,

doi = { 10.1109/ICASSP48485.2024.10448030 } }