Dies ist das offizielle Repository für das Papierrekapitum: ARRAGUVAL-AUTIONED SUDIO-Bildunterschriften, die bei ICASSP 2024 zur mündlichen Präsentation akzeptiert werden.

[ Paper ] [ CLAP Checkpoints ] [ Weakly labeled captions for AudioSet, AudioCaps, and Clotho ]

HINWEIS : Clap -Checkpoints sollen mit den in diesem Repository definierten Modellen und Code verwendet werden.

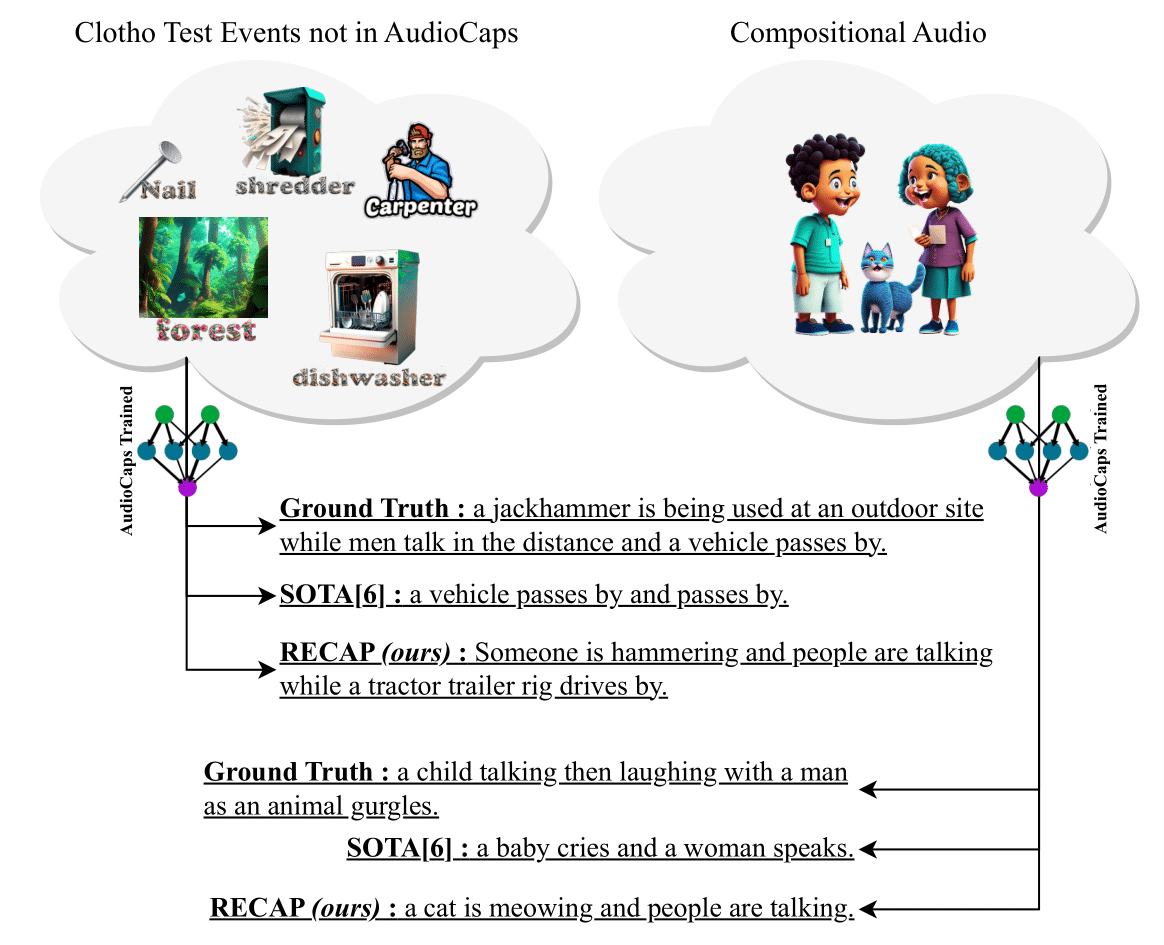

Wir präsentieren die Recape (Abruf-Augmented Audio Captioning), ein neuartiges und effektives Audio-Bildunterschriftensystem, das Bildunterschriften generiert, die auf einem Eingangs-Audio und anderen Bildunterschriften verbunden sind, die dem von einem Datenspeicher abgerufenen Audio ähneln. Darüber hinaus kann unsere vorgeschlagene Methode auf eine beliebige Domäne übertragen, ohne dass zusätzliche Feinabstimmungen erforderlich sind. Um eine Bildunterschrift für eine Audio-Probe zu generieren, nutzen wir ein Audio-Text-Modellklatschen, um Bildunterschriften aus einem austauschbaren Datenspeicher abzurufen, mit dem dann eine Eingabeaufforderung erstellt wird. Als nächstes füttern wir diese Eingabeaufforderung an einen GPT-2-Decoder und führen Cross-Tent-Schichten zwischen dem ClaP-Encoder und GPT-2 ein, um den Audio für die Bildunterschriftenerzeugung zu konditionieren. Experimente zu zwei Benchmark-Datensätzen, Clotho und Audiocaps, zeigen, dass die Zusammenfassung die Wettbewerbsleistung in Domäneneinstellungen und signifikante Verbesserungen der Umgebungen außerhalb der Domänen erzielt. Aufgrund seiner Fähigkeit, einen großartigen Datenspeicher-Datensport in einer Training frei zu nutzen, zeigt die Zusammenfassung einzigartige Funktionen, neuartige Audio-Events, die während des Trainings und der Kompositionsprotokolle mit mehreren Veranstaltungen noch nie gesehen wurden. Um die Forschung in diesem Bereich zu fördern, veröffentlichen wir außerdem 150.000 neue schwach beschriftete Bildunterschriften für Audioset, Audiocaps und Clotho.

pip install -r requirements.txt . Wenn Sie Conda installiert haben, können Sie Folgendes ausführen: cd RECAP &&

conda create -n recap python=3.10 &&

conda activate recap &&

pip install -r requirements.txtbash recap.sh Das Repository verfügt über Trainings- und Inferenzbefehle. Wir empfehlen ihnen, sie einzeln zu machen. Sobald Sie python train.py ausgeführt haben und einen Kontrollpunkt speichern, aktualisieren Sie die Pfade in python infer.py und schließen in Ihr ausgebildetes Modell. --model_path bezieht sich auf den übergeordneten Ordner, in dem Ihre Kontrollpunkte gespeichert sind, und --checkpoint_path bezieht sich auf den Kontrollpunkt, den Sie verwenden möchten (der Trainingscode speichert mehrere Kontrollpunkte, jedes Mal, wenn eine vordefinierte Anzahl von Schritten ausgeführt wird).

Sobald Sie unsere ClaP -Checkpoints heruntergeladen haben, können Sie sie zur Bewertung mithilfe von ClAP verwenden.

Unsere Codebasis wurde von SmallCap inspiriert. Wir danken den Autoren für die Open-Souring ihrer Arbeit.

@INPROCEEDINGS { 10448030 ,

author = { Ghosh, Sreyan and Kumar, Sonal and Reddy Evuru, Chandra Kiran and Duraiswami, Ramani and Manocha, Dinesh } ,

booktitle = { ICASSP 2024 - 2024 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) } ,

title = { Recap: Retrieval-Augmented Audio Captioning } ,

year = { 2024 } ,

volume = { } ,

number = { } ,

pages = { 1161-1165 } ,

keywords = { Training;Signal processing;Benchmark testing;Acoustics;Decoding;Feeds;Speech processing;Automated audio captioning;multimodal learning;retrieval-augmented generation } ,

doi = { 10.1109/ICASSP48485.2024.10448030 } }