Este es el repositorio oficial de la resumen del documento: subtítulos de audio de recuperación accesorios aceptados en ICASSP 2024 para la presentación oral.

[ Paper ] [ CLAP Checkpoints ] [ Weakly labeled captions for AudioSet, AudioCaps, and Clotho ]

Nota : Los puntos de control de Clap están destinados a usarse con los modelos y el código definido en este repositorio.

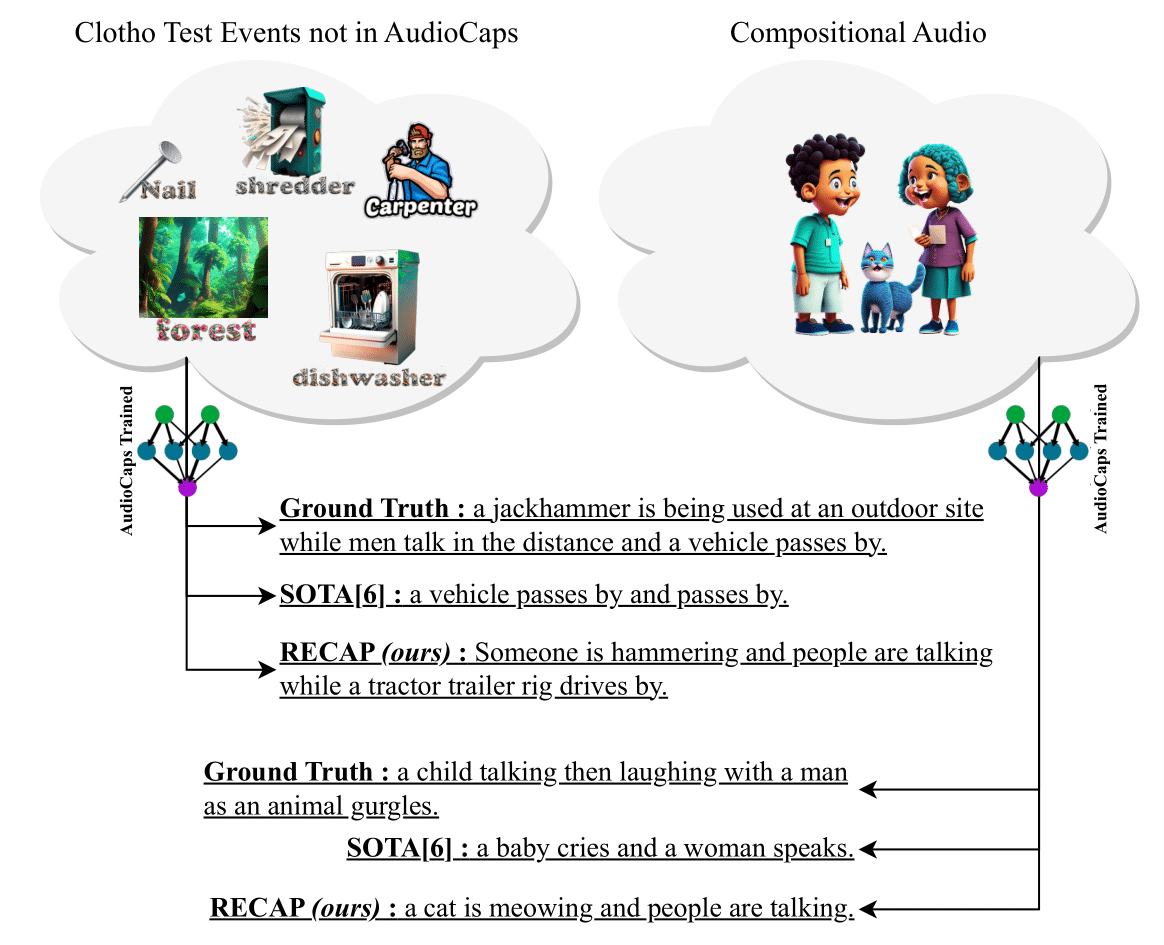

Presentamos recapitulación (subtitulación de audio de recuperación de recuperación), un sistema de subtítulos de audio novedoso y efectivo que genera subtítulos condicionados en un audio de entrada y otros subtítulos similares al audio recuperado de un almacén de datos. Además, nuestro método propuesto puede transferirse a cualquier dominio sin la necesidad de ningún ajuste adicional adicional. Para generar un título para una muestra de audio, aprovechamos un aplausos del modelo de texto de audio para recuperar los subtítulos de manera similar a él desde un almacén de datos reemplazable, que luego se utilizan para construir un aviso. A continuación, alimentamos este indicador a un decodificador GPT-2 e introducimos capas de atención cruzada entre el codificador Clap y GPT-2 para acondicionar el audio para la generación de subtítulos. Los experimentos en dos conjuntos de datos de referencia, Clotho y Audiocaps muestran que la recapitulación logra un rendimiento competitivo en la configuración del dominio y mejoras significativas en la configuración fuera del dominio. Además, debido a su capacidad de explotar un gran almacén de datos de texto de texto solo de manera libre de capacitación , el recapitulación muestra capacidades únicas de subtitular eventos de audio novedosos nunca vistos durante la capacitación y audios compositivos con múltiples eventos. Para promover la investigación en este espacio, también lanzamos más de 150,000 nuevos subtítulos débilmente etiquetados para Audioset, Audiocaps y Clotho.

pip install -r requirements.txt . Si tiene Conda instalado, puede ejecutar lo siguiente: cd RECAP &&

conda create -n recap python=3.10 &&

conda activate recap &&

pip install -r requirements.txtbash recap.sh El repositorio tiene comandos de capacitación e inferencia. Recomendamos hacerlos uno por uno. Una vez que ejecute python train.py y guarde un punto de control, actualice las rutas en python infer.py e infiera su modelo entrenado. --model_path se refiere a la carpeta principal donde se guardan sus puntos de control, y --checkpoint_path se refiere al punto de control que desea usar (el código de entrenamiento guarda múltiples puntos de control, uno cada vez que se completa un número predefinido de pasos).

Una vez que haya descargado nuestros puntos de control Clap, puede usarlos para evaluar usando Clap.

Nuestra base de código se ha inspirado en SmallCap. Agradecemos a los autores por obtener su trabajo.

@INPROCEEDINGS { 10448030 ,

author = { Ghosh, Sreyan and Kumar, Sonal and Reddy Evuru, Chandra Kiran and Duraiswami, Ramani and Manocha, Dinesh } ,

booktitle = { ICASSP 2024 - 2024 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) } ,

title = { Recap: Retrieval-Augmented Audio Captioning } ,

year = { 2024 } ,

volume = { } ,

number = { } ,

pages = { 1161-1165 } ,

keywords = { Training;Signal processing;Benchmark testing;Acoustics;Decoding;Feeds;Speech processing;Automated audio captioning;multimodal learning;retrieval-augmented generation } ,

doi = { 10.1109/ICASSP48485.2024.10448030 } }