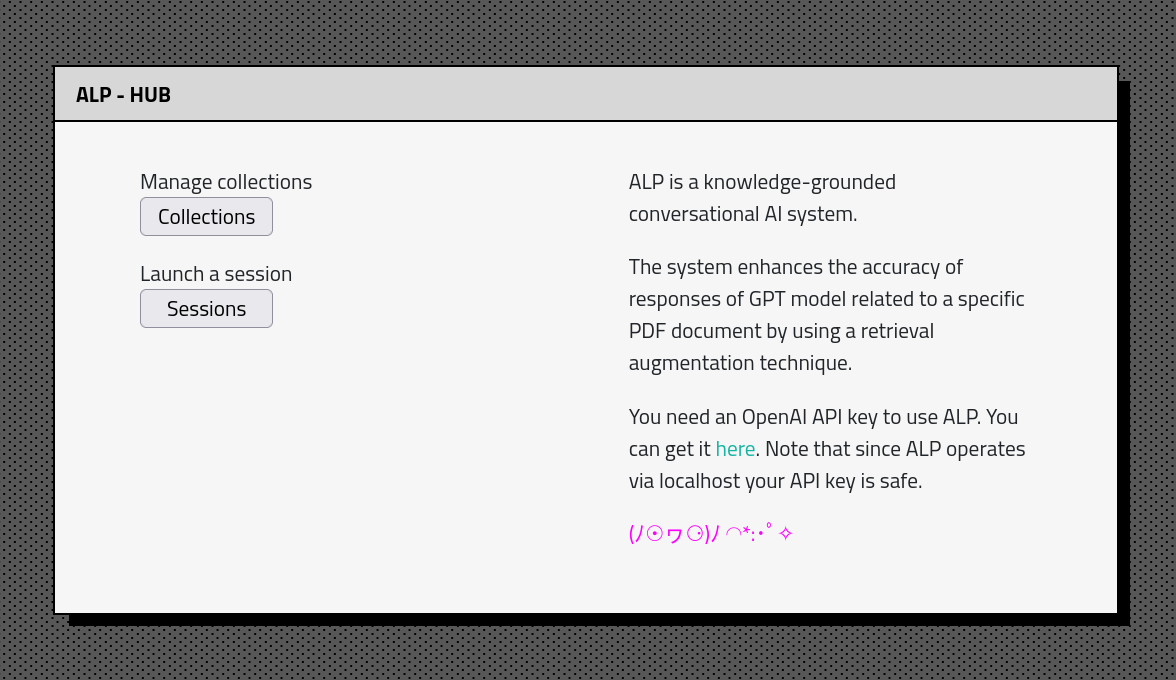

A ALP é um sistema de IA de conversação baseado em conhecimento aberto, criado para produzir respostas que estão enraizadas em informações relevantes de fontes externas. ?

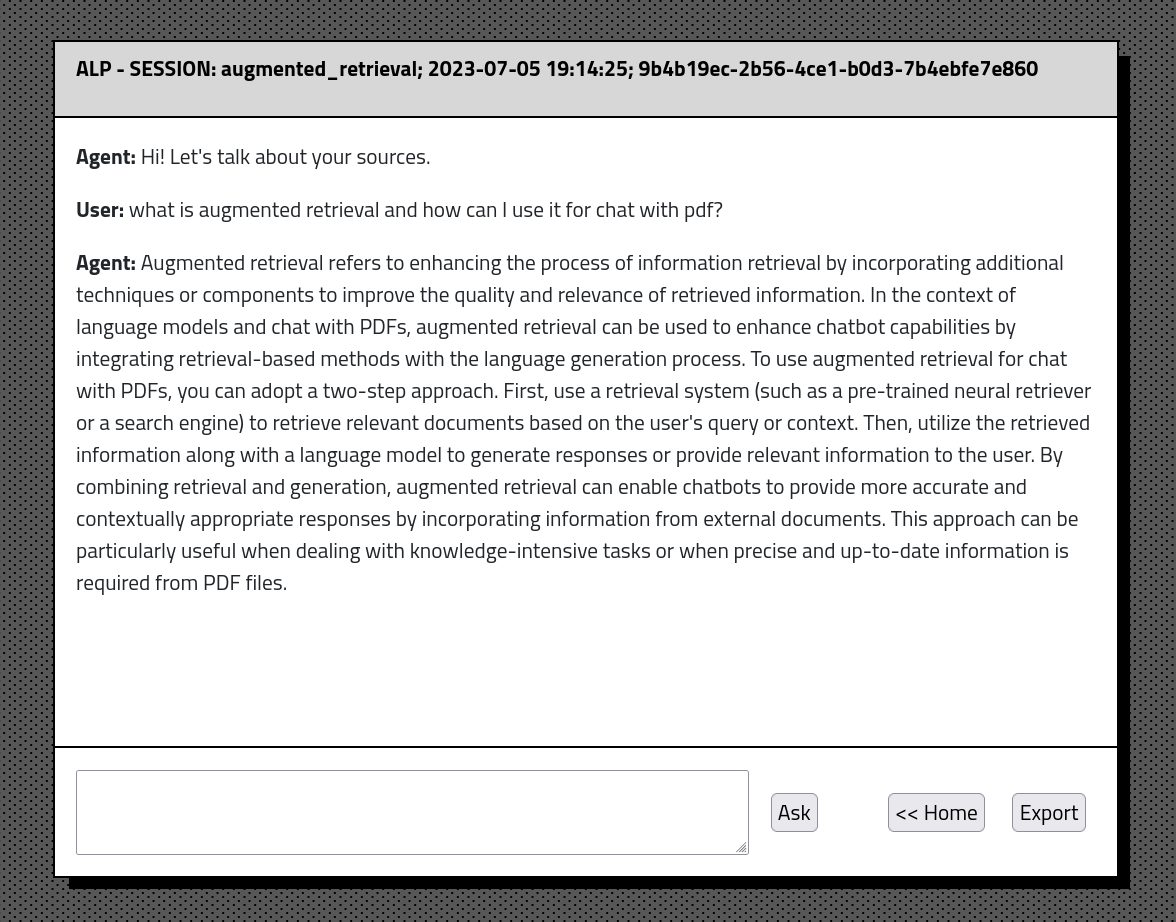

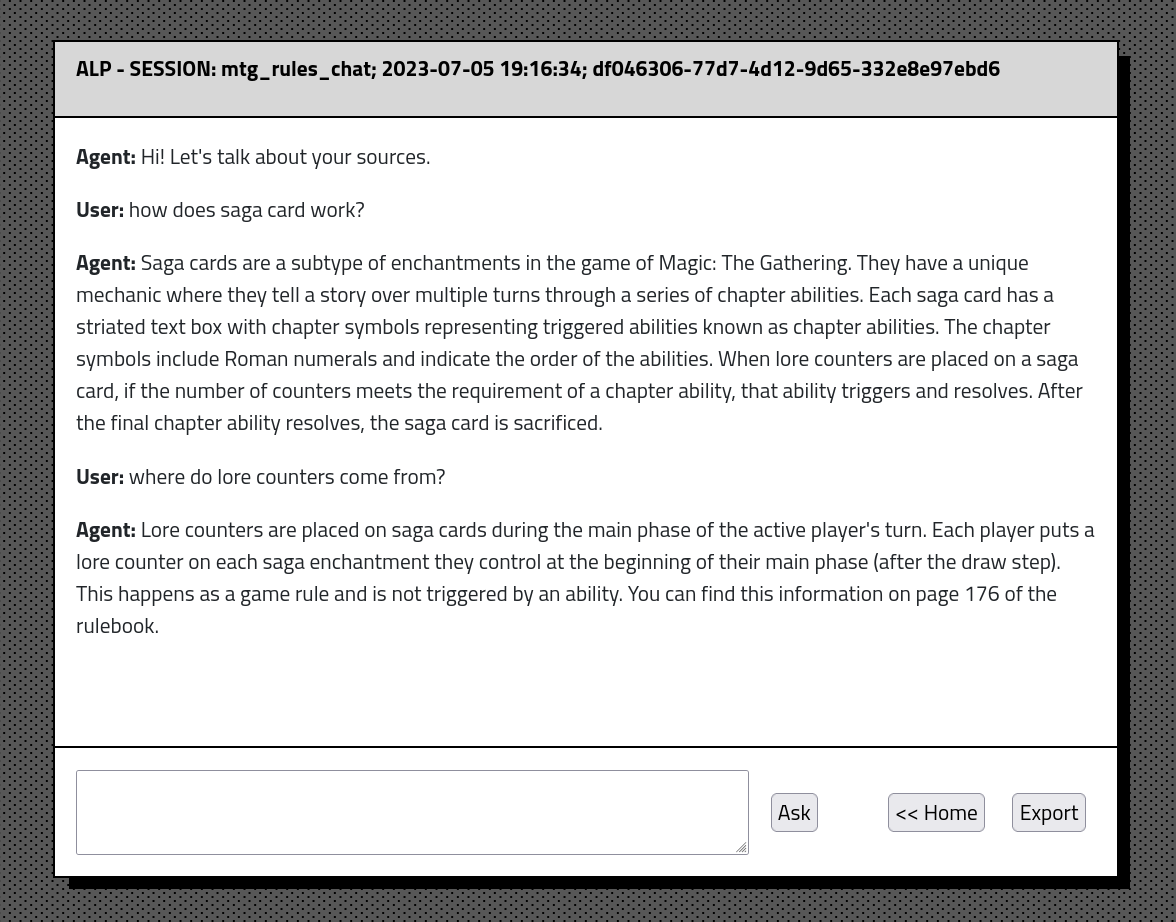

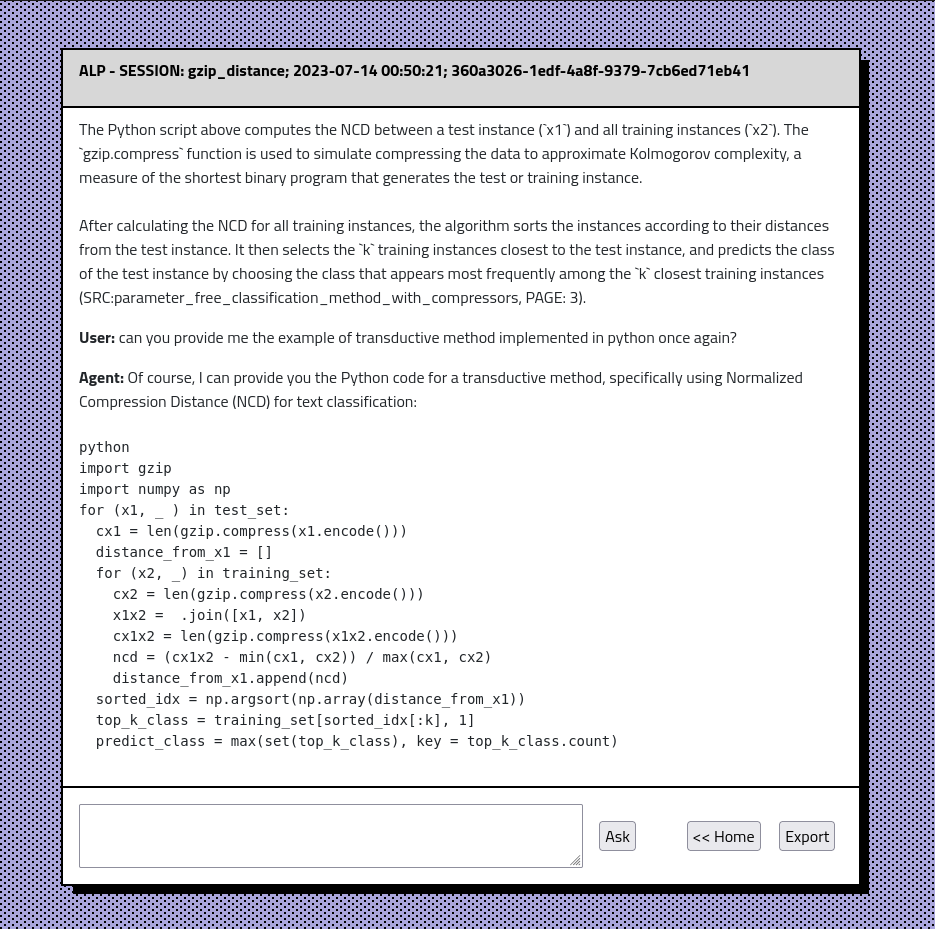

O ALP permite que você construa uma grande base de conhecimento que possa ser consultada enquanto interage com um chatbot. As construções de contexto baseadas em similaridade permitem uma melhor relevância de materiais extraídos do banco de dados. O chatbot possui memória de conversação ilimitada e a capacidade de exportar conversas e originar incorporação para o formato JSON.

O ALP mantém o histórico de conversas e as incorporações em um banco de dados SQLite local? Aste. Como resultado, os processos de upload e incorporação de documentos são necessários apenas uma vez, permitindo que os usuários retomem as conversas perfeitamente.

O ALP deve ser executado via localhost. Tudo o que você precisa é de Python e poucos comandos para configurar o ambiente. Sinta -se à vontade para bifurcar, explorar o código e ajustar suas necessidades?

gpt-4o' , gpt-4o-minigpt-4-1106-preview adicionado como modelo generativo padrão. O usuário pode alterá -lo em ./lib/params.py em prod_model . Coleção Correção Correção da contagem de bugs.O ALP aprimora a precisão das respostas dos modelos baseados em GPT em relação aos documentos em PDF, usando um método de aumento de recuperação. Essa abordagem garante que o contexto mais relevante seja sempre passado para o modelo. A intenção por trás do ALP é ajudar a explorar a esmagadora base de conhecimento de trabalhos de pesquisa, livros e notas, facilitando o acesso e a digerida do conteúdo.

Atualmente, o ALP utiliza os seguintes modelos:

multi-qa-MiniLM-L6-cos-v1gpt-4o' , gpt-4o-mini Para configurar o ALP em sua máquina local, siga estas etapas:

Certifique -se de ter o Python instalado em sua máquina. Eu recomendo a Anaconda para uma configuração fácil.

IMPORTANTE: O ALP é executado no Python 3.10

Depois de gastar o repo, clone -o em uma linha de comando:

git clone https://github.com/yourusername/alp.git

cd ALPDe dentro do diretório ALP/ Local Invoke os seguintes comandos

Para usuários do Linux em Bash:

python3 -m venv venv

source venv/bin/activatePara usuários do Windows em CMD:

python -m venv venv

venvScriptsactivate.bat

Isso deve criar o diretório ALP/ VENV/ ativar o ambiente virtual. Naturalmente, você pode usar outros programas para lidar com o VirtualENVS.

pip install -r requirements.txt Por padrão, o ALP é executado em localhost . Requer a chave da API para conectar -se ao modelo GPT via API da IA aberta. No diretório ALP/ Crie um api_key.txt e cole sua chave da API lá. Verifique se a API_KEY.TXT é adicionada ao seu arquivo .gitignore para que não vaze para o Github. Você pode obter sua chave API aberta aqui https://platform.openai.com

python alp.pyO aplicativo deve abrir no seu navegador padrão da Web. Caso contrário, navegue para http: // localhost: 5000. O primeiro uso envolve a criação do arquivo app.db em alp/static/dados/dbs/. Este é o seu arquivo de banco de dados SQLite que manterá o histórico de conversas e as incorporações. Além disso, o script baixará 'Multi-QA-Minilm-L6-COS-V1' (80 MB) para o seu PC de abraçar repositórios de rosto. Isso acontecerá automaticamente em um primeiro lançamento.

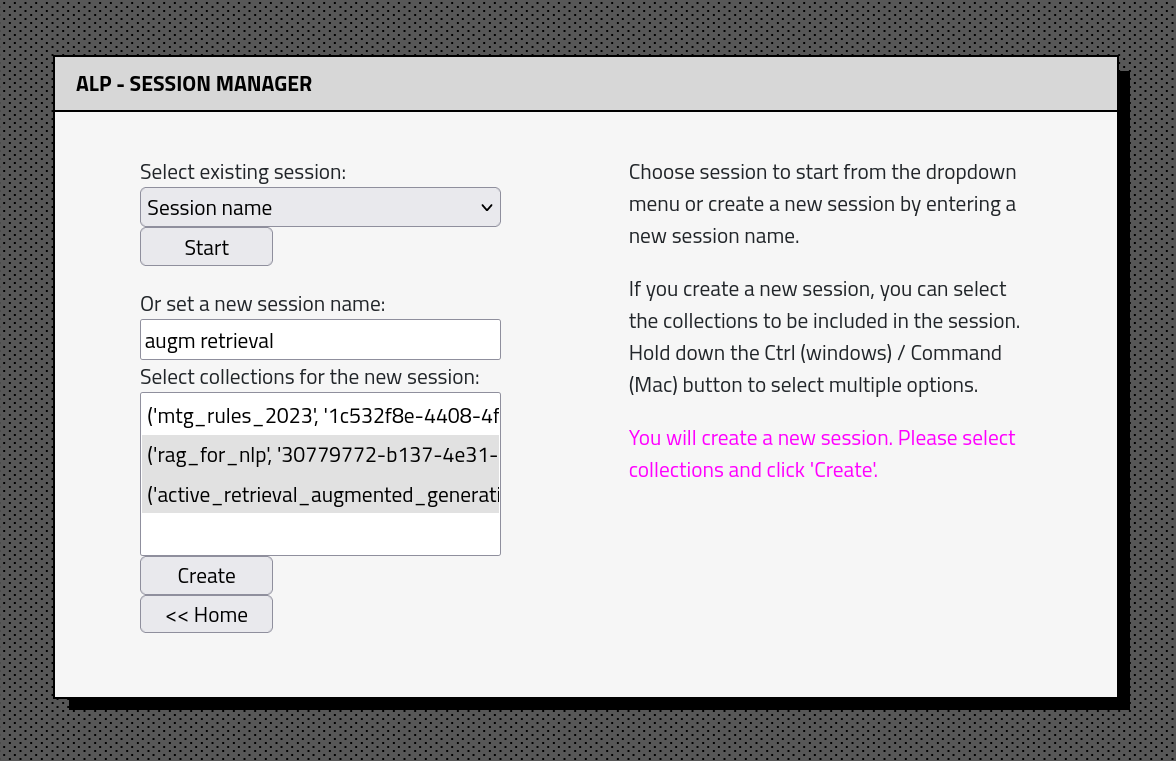

A interface de aplicativo ALP consiste em algumas seções: