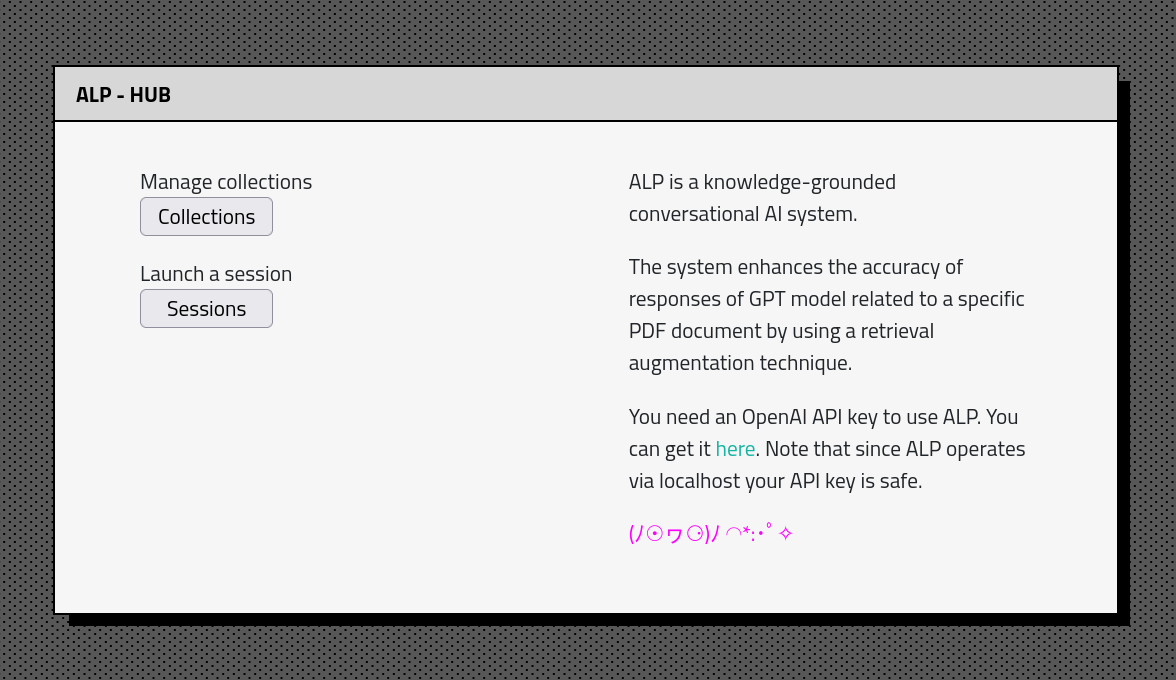

ALP es un sistema de IA conversacional basado en el conocimiento y de código abierto, diseñado para producir respuestas que se basan en la información relevante de fuentes externas. ?

ALP le permite construir una gran base de conocimiento que se puede consultar mientras interactúa con un chatbot. Las construcciones de contexto basadas en similitud permiten una mejor relevancia de los materiales extraídos de la base de datos. El chatbot tiene memoria de conversación ilimitada y la capacidad de exportar conversaciones y incrustaciones de origen al formato JSON.

¿ALP mantiene el historial de conversación y las integridades en una base de datos SQLite local? ️. Como resultado, los procesos de carga e incrustación de documentos se requieren solo una vez, lo que permite a los usuarios reanudar las conversaciones sin problemas.

ALP está destinado a ejecutarse a través de localhost. Todo lo que necesitas es Python y pocos comandos para configurar el entorno. ¿No dude en bifurcar, explorar el código y ajustar a sus necesidades?

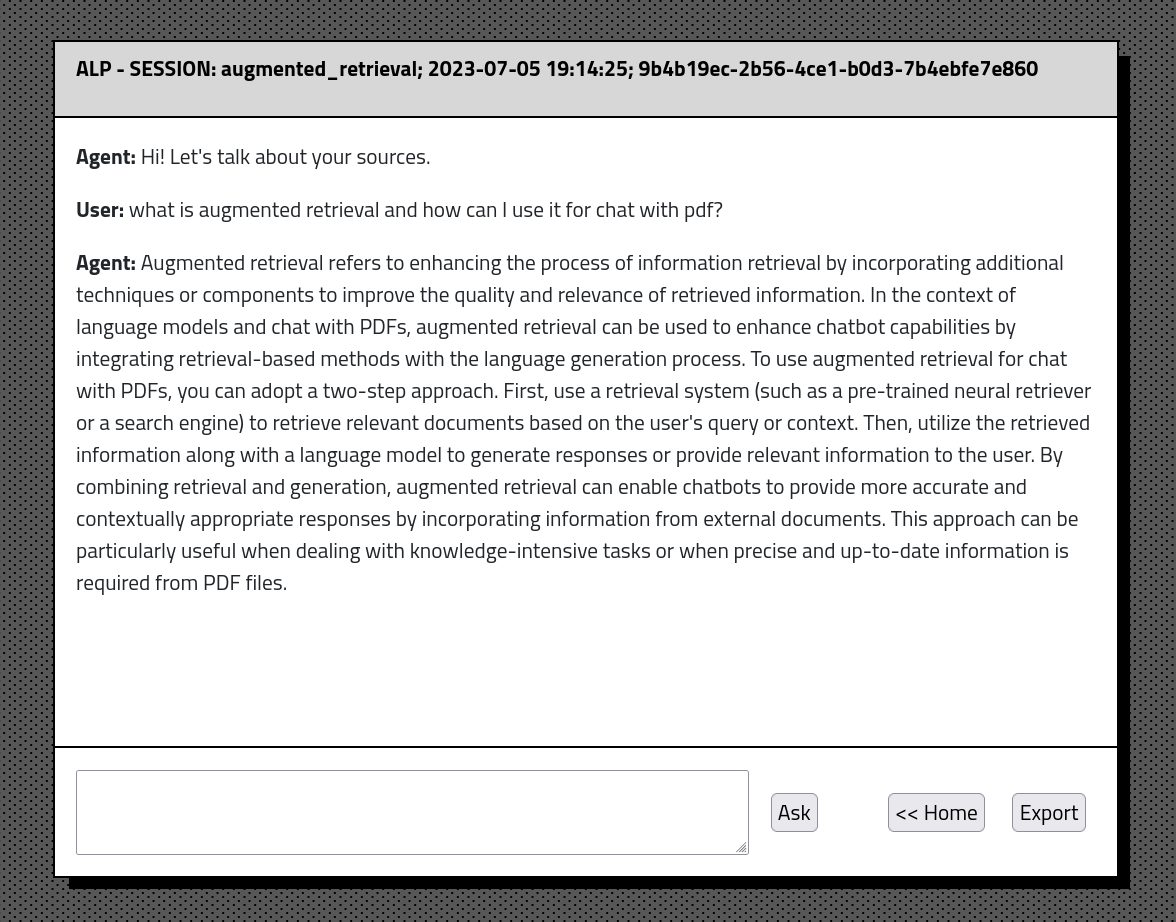

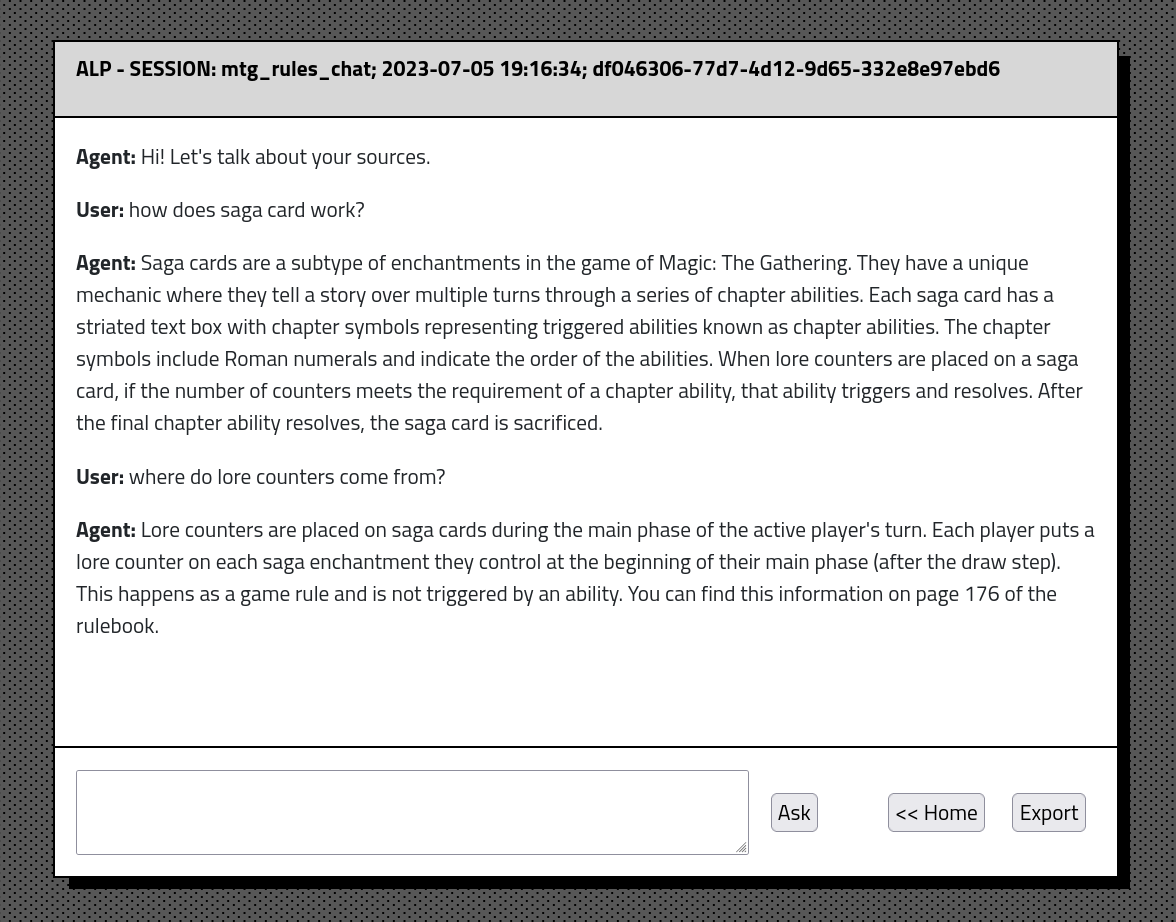

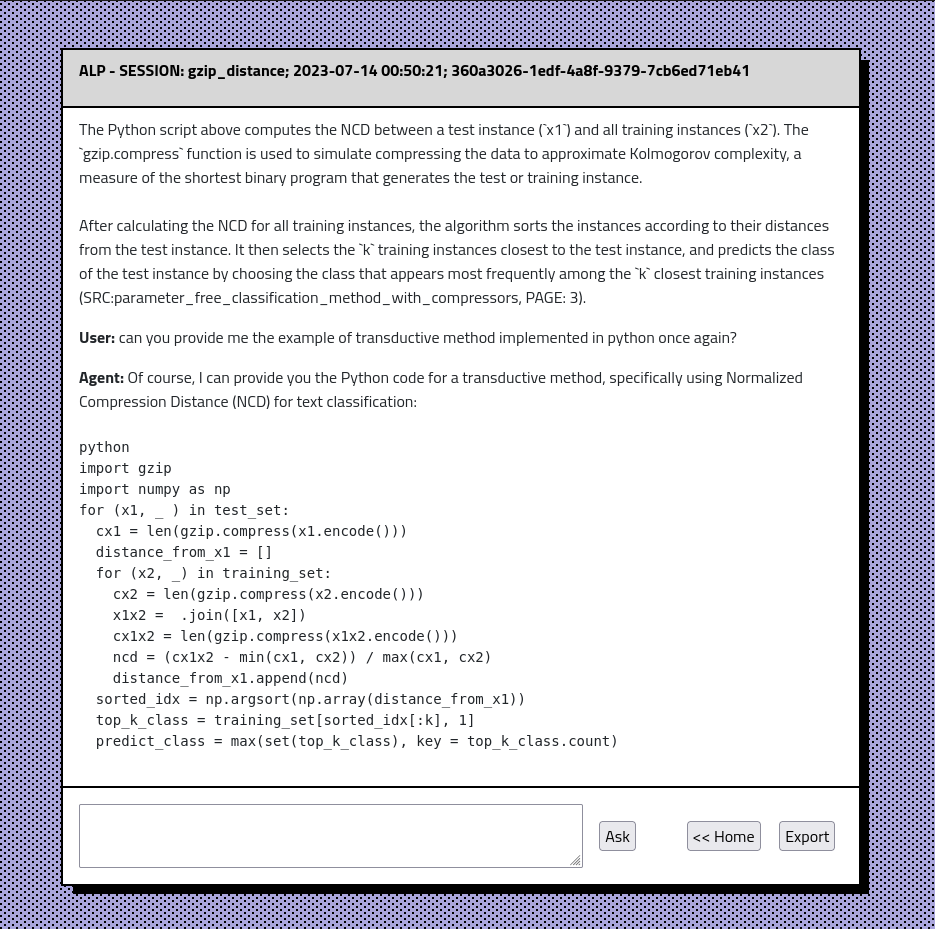

gpt-4o' , gpt-4o-minigpt-4-1106-preview agregada como modelo generativo predeterminado. El usuario puede cambiarlo en ./lib/params.py en prod_model . COLLECCIÓN DE LA COLECCIÓN CUENTA DE ENCUENTRO DEL CONTAJE DE LA PÁGINA.ALP mejora la precisión de las respuestas de los modelos basados en GPT en relación con los documentos PDF dados mediante el uso de un método de aumento de recuperación. Este enfoque asegura que el contexto más relevante siempre se pase al modelo. La intención detrás de ALP es ayudar a la exploración de la abrumadora base de conocimiento de trabajos de investigación, libros y notas, lo que facilita el acceso y digerir contenido.

Actualmente ALP utiliza los siguientes modelos:

multi-qa-MiniLM-L6-cos-v1gpt-4o' , gpt-4o-mini Para configurar ALP en su máquina local, siga estos pasos:

Asegúrese de tener Python instalado en su máquina. Recomiendo a Anaconda para una configuración fácil.

IMPORTANTE: ALP se ejecuta en Python 3.10

Después de bifurgar el Repo Clone en una línea de comando:

git clone https://github.com/yourusername/alp.git

cd ALPDesde dentro del directorio ALP/ Local Invoca los siguientes comandos

Para usuarios de Linux en Bash:

python3 -m venv venv

source venv/bin/activatePara usuarios de Windows en CMD:

python -m venv venv

venvScriptsactivate.bat

Esto debería crear alp/ venv/ directorio y activar el entorno virtual. Naturalmente, puede usar otros programas para manejar VirtualEnvs.

pip install -r requirements.txt Por defecto, ALP se ejecuta en localhost . Requiere la tecla API para conectarse con el modelo GPT a través de la API de AI Open. En el directorio ALP/, cree un API_KEY.TXT y pegue su tecla API allí. Asegúrese de que api_key.txt se agregue a su archivo .gitignore para que no se filtre a GitHub. Puede obtener su tecla API de AI Open aquí https://platform.openai.com

python alp.pyLa aplicación debe abrirse en su navegador web predeterminado. Si no es así, navegue a http: // localhost: 5000. El primer uso implica la creación del archivo APP.DB en ALP/STATIC/DATA/DBS/. Este es su archivo de base de datos SQLite que contendrá el historial de conversaciones y los incrustaciones. Además, el script descargará 'Multi-Qa-minilm-L6-Cos-V1' (80 MB) a su PC desde abrazar repositorios faciales. Sucederá automáticamente en un primer lanzamiento.

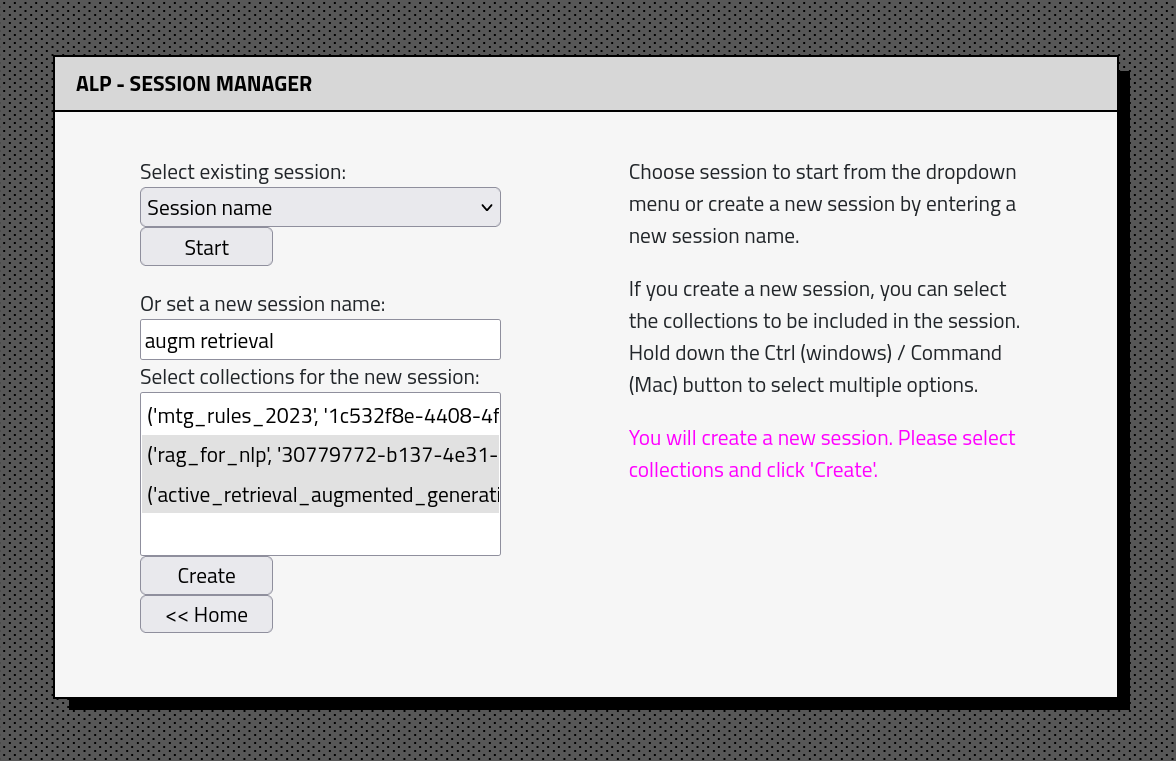

La interfaz de la aplicación ALP consta de un par de secciones: