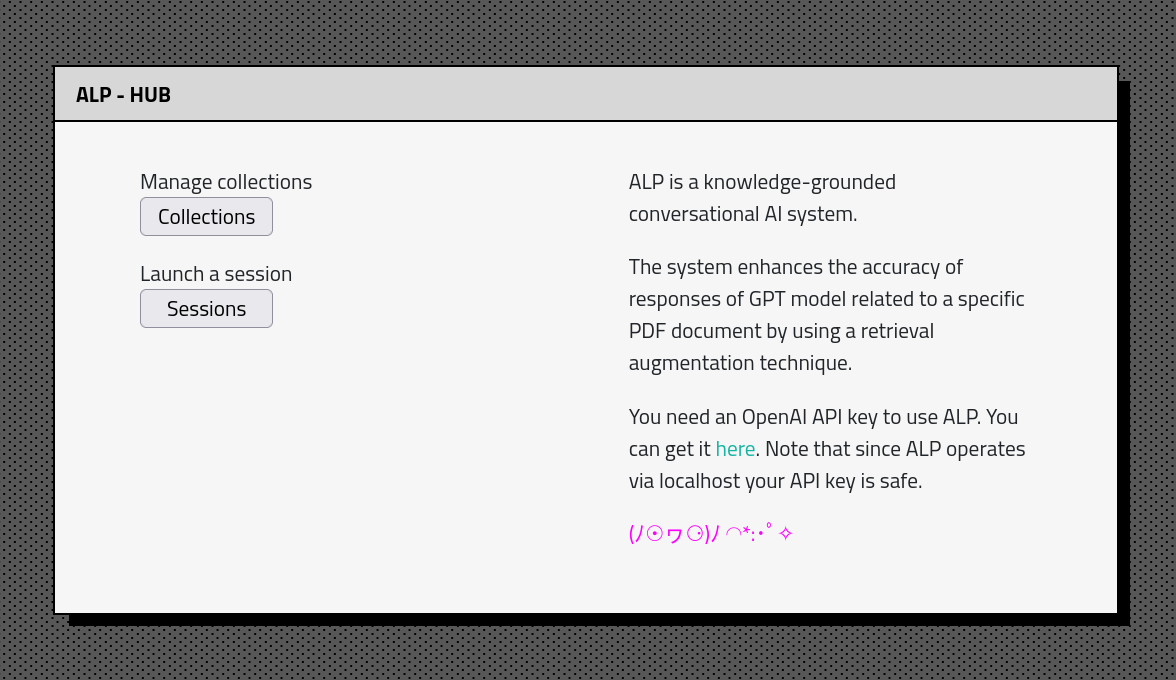

ALP ist ein Open-Source-KI-System mit wissensbasiertem Konversations-KI, das Reaktionen erzeugt, die in relevanten Informationen aus externen Quellen verwurzelt sind. ?

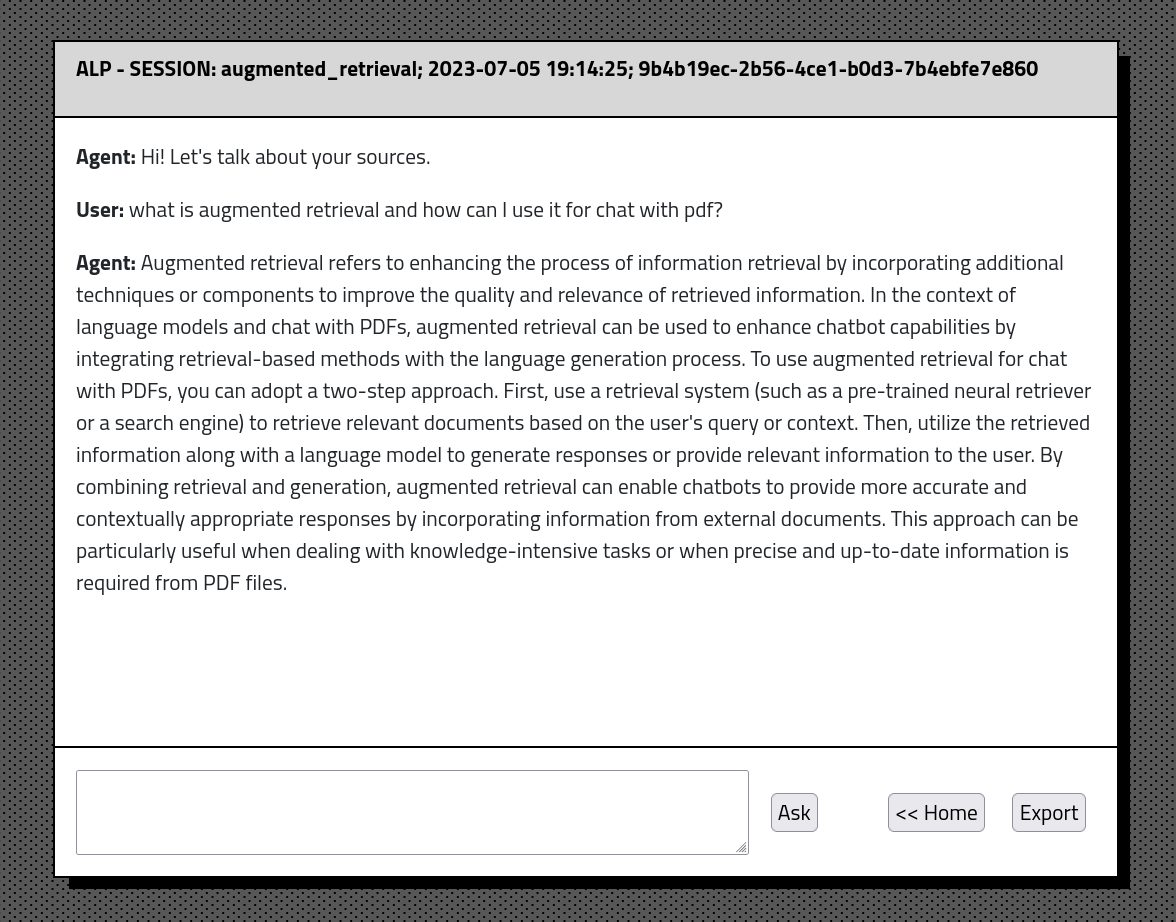

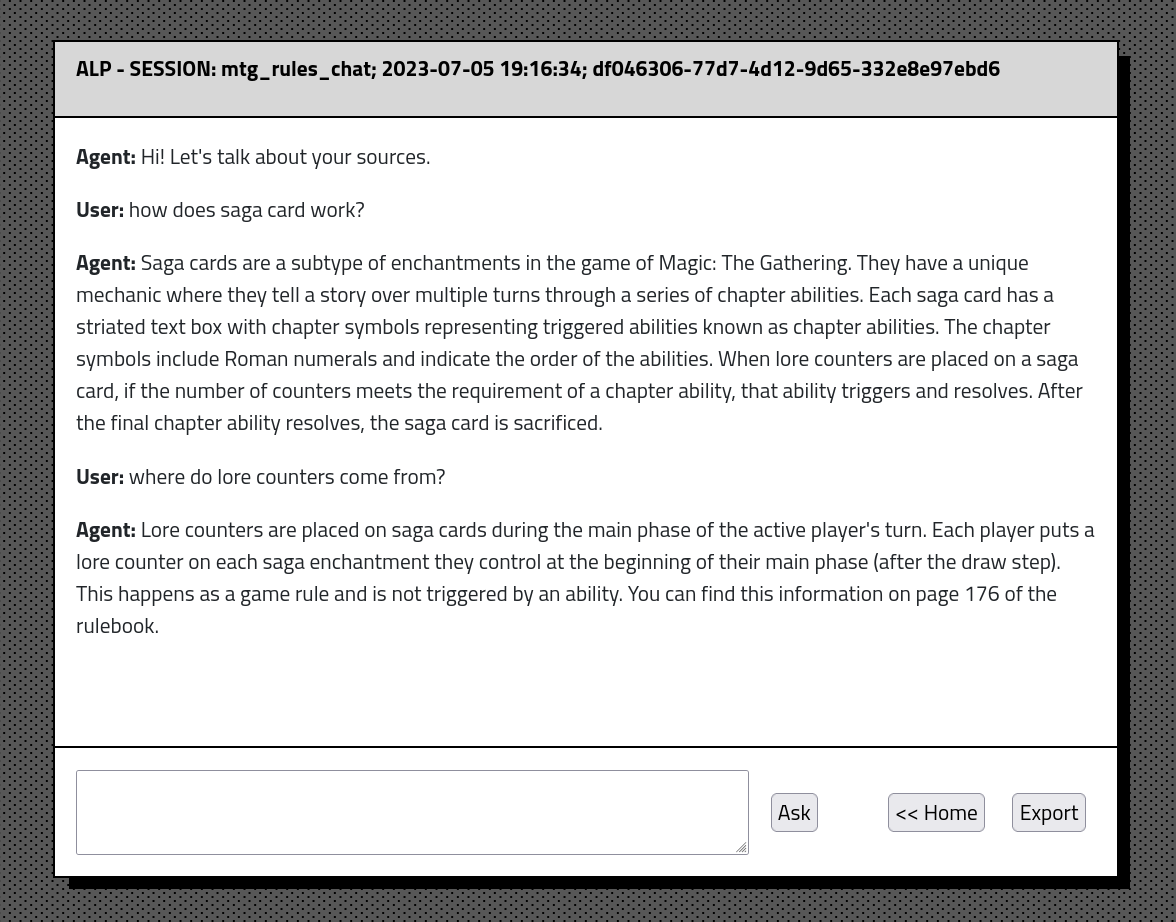

Mit ALP können Sie eine große Wissensbasis erstellen, die während der Interaktion mit einem Chatbot abgefragt werden kann. Ähnlichkeitsbasierte Kontextkonstruktionen ermöglichen eine bessere Relevanz der aus der Datenbank extrahierten Materialien. Der Chatbot verfügt über ein unbegrenztes Gesprächsgedächtnis und die Fähigkeit, Gespräche zu exportieren und Einbettungen in das JSON -Format zu haben.

ALP unterhält die Gesprächsgeschichte und Einbettung in einer lokalen SQLite -Datenbank? Euen. Infolgedessen sind nur einmal das Hochladen von Dokumenten und Einbettungsprozessen erforderlich, sodass Benutzer Konversationen nahtlos wieder aufnehmen können.

ALP soll über Localhost ausgeführt werden. Alles, was Sie brauchen, ist Python und wenige Befehle zur Einrichtung der Umgebung. Fühlen Sie sich frei, den Code zu erforschen und an Ihre Bedürfnisse anzupassen?

gpt-4o' , gpt-4o-minigpt-4-1106-preview als Standard-Generativmodell hinzugefügt. Der Benutzer kann es in ./lib/params.py in prod_model ändern. Sammelnerstellung Seitenzählungsfix.ALP verbessert die Genauigkeit der Antworten von GPT-basierten Modellen im Vergleich zu gegebenen PDF-Dokumenten unter Verwendung einer Abruf-Augmentationsmethode. Dieser Ansatz stellt sicher, dass der relevanteste Kontext immer an das Modell übergeben wird. Die Absicht hinter ALP ist die Erforschung der überwältigenden Wissensbasis von Forschungsarbeiten, Büchern und Notizen und erleichtert den Zugriff und die Verdauung von Inhalten.

Derzeit verwendet ALP folgende Modelle:

multi-qa-MiniLM-L6-cos-v1gpt-4o' , gpt-4o-mini Befolgen Sie die folgenden Schritte, um ALP auf Ihrer lokalen Maschine einzurichten:

Stellen Sie sicher, dass Sie Python auf Ihrem Computer installiert haben. Ich empfehle Anaconda für ein einfaches Setup.

Wichtig: ALP läuft auf Python 3.10

Nach dem Gabel des Repo klonen Sie es in einer Befehlszeile:

git clone https://github.com/yourusername/alp.git

cd ALPAus dem ALP/ Lokal -Verzeichnis rufen nach folgenden Befehlen auf

Für Linux -Benutzer in Bash:

python3 -m venv venv

source venv/bin/activateFür Windows -Benutzer in CMD:

python -m venv venv

venvScriptsactivate.bat

Dies sollte ALP/ Venv/ Verzeichnis erstellen und die virtuelle Umgebung aktivieren. Natürlich können Sie andere Programme verwenden, um VirtualenVs zu verarbeiten.

pip install -r requirements.txt Standardmäßig läuft ALP in localhost . Es erfordert den API -Schlüssel, um über die Open AI -API mit dem GPT -Modell eine Verbindung herzustellen. Erstellen Sie im Alp/ Verzeichnis einen api_key.txt und fügen Sie dort Ihre API -Schlüssel ein. Stellen Sie sicher, dass api_key.txt Ihrer .gitignore -Datei hinzugefügt wird, damit sie nicht an GitHub ausgelöst wird. Sie können Ihre offene AI -API -Schlüssel hier erhalten https://platform.openai.com

python alp.pyDie App sollte in Ihrem Standard -Webbrowser geöffnet werden. Wenn dies nicht der Fall ist, navigieren Sie zu http: // localhost: 5000. Die zunächst Verwendung beinhaltet die Erstellung von App.db -Datei unter ALP/STATIC/DATA/DBS/. Dies ist Ihre SQLite -Datenbankdatei, die den Gesprächsverlauf und die Einbettung enthält. Außerdem wird das Skript 'Multi-QA-Minilm-L6-Cos-V1' (80 MB) von umarmen Gesichtsrepositories auf Ihren PC heruntergeladen. Es wird automatisch beim ersten Start geschehen.

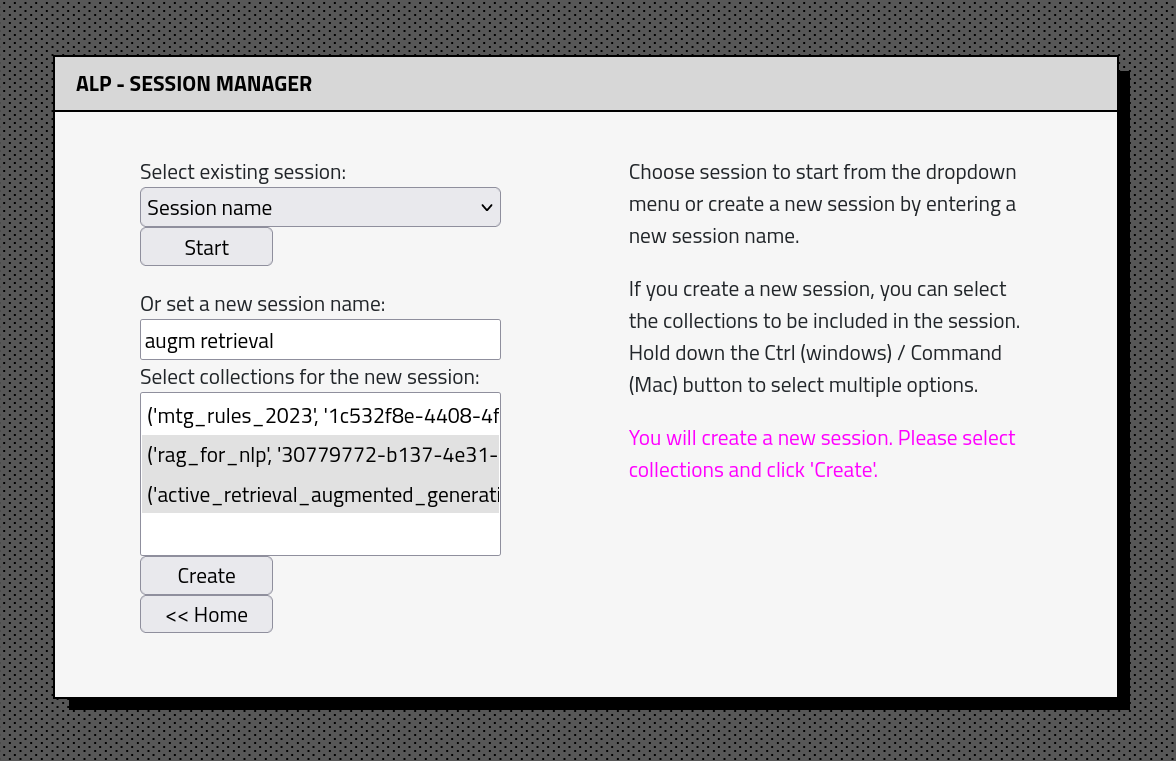

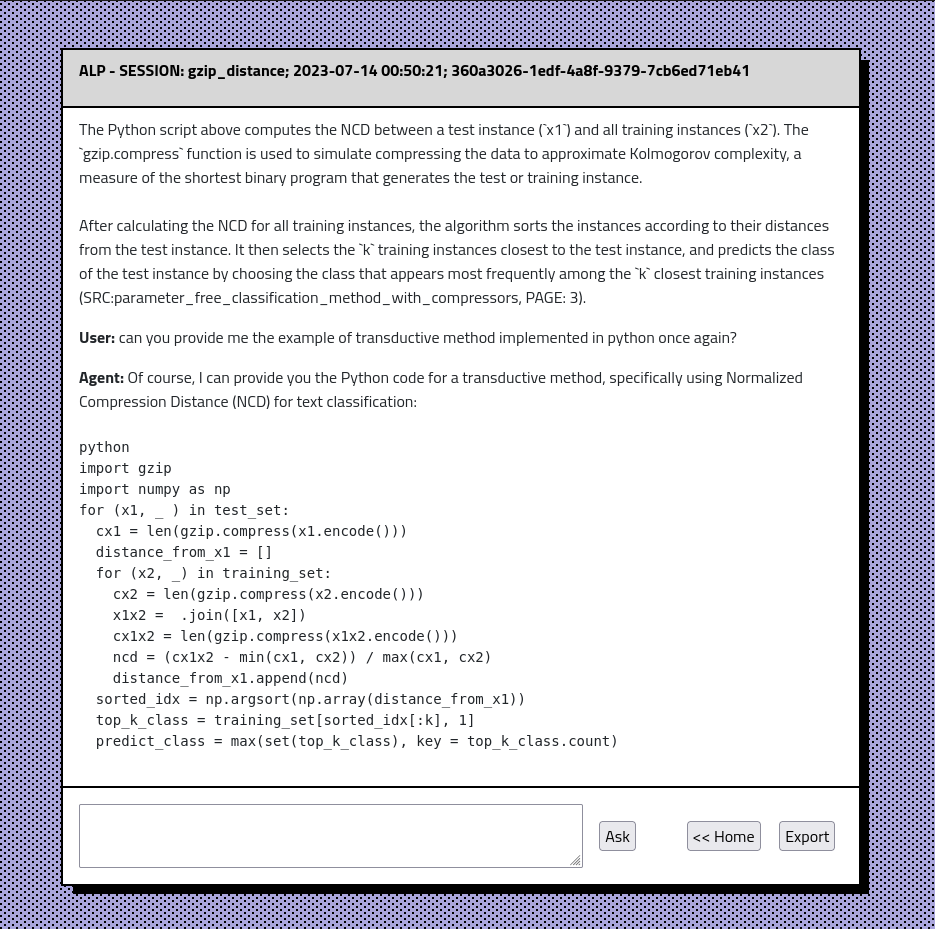

Die ALP -App -Schnittstelle besteht aus einigen Abschnitten: