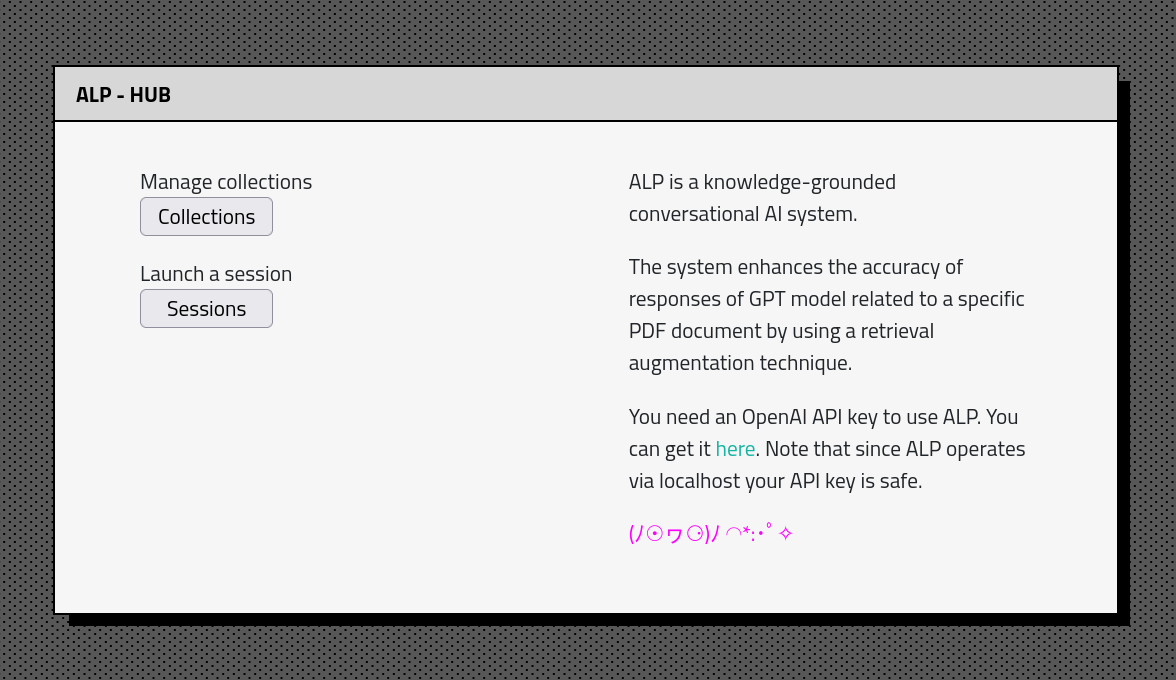

L'ALP est un système d'IA conversationnel open source et basé sur les connaissances, fabriqué pour produire des réponses qui sont enracinées dans les informations pertinentes provenant de sources externes. ?

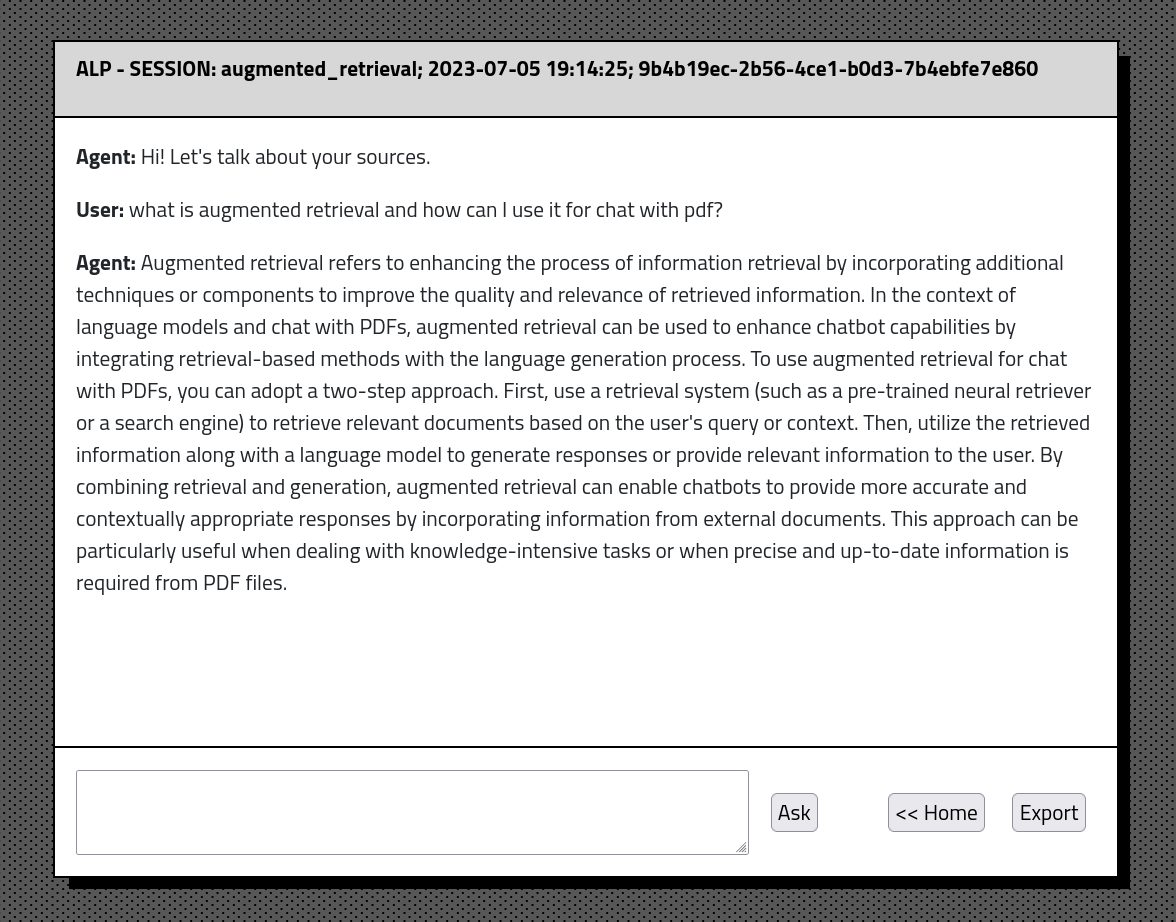

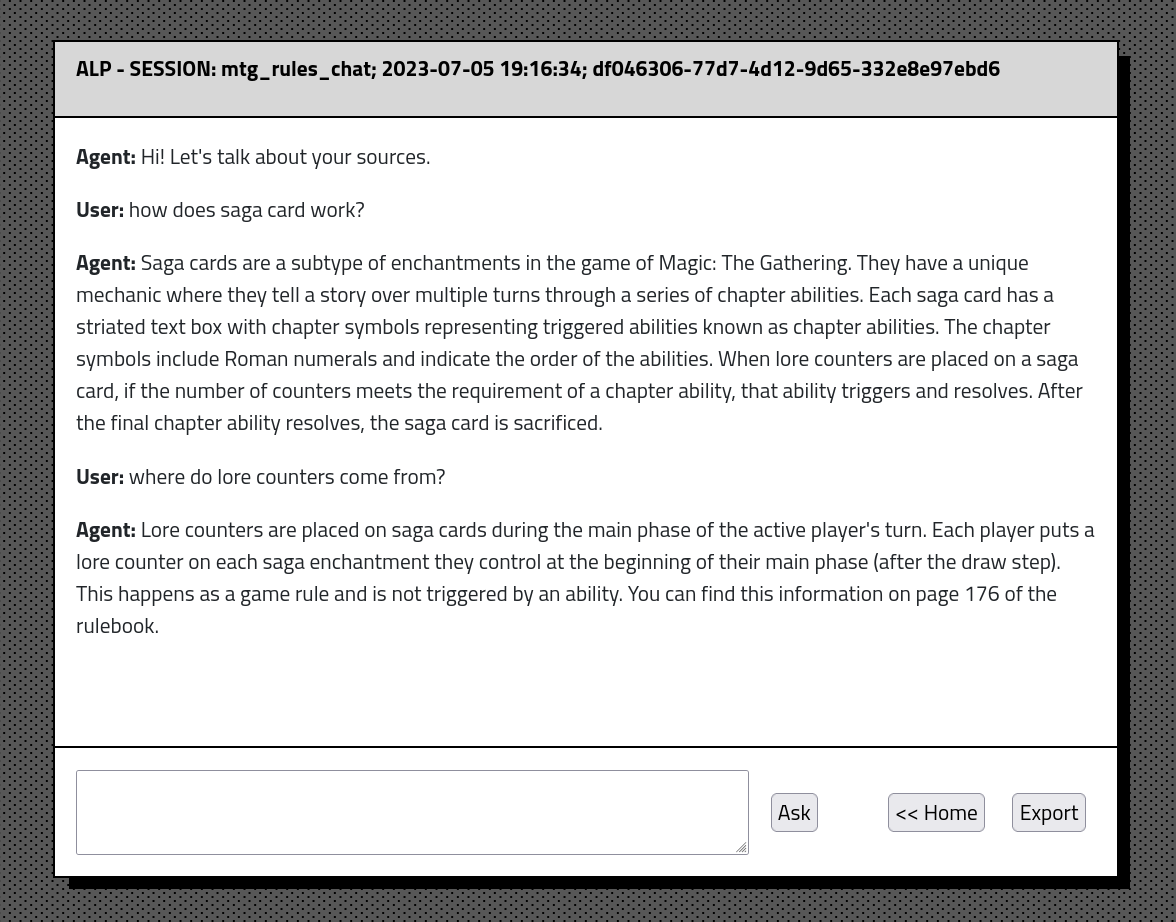

ALP vous permet de construire une grande base de connaissances qui peut être interrogée lors de l'interaction avec un chatbot. Les constructions de contexte basées sur la similitude permettent une meilleure pertinence des matériaux extraits de la base de données. Le chatbot a une mémoire conversationnelle illimitée et la possibilité d'exporter la conversation et la source d'intégration au format JSON.

ALP maintient l'historique de conversation et les intégres dans une base de données SQLite locale? ️. En conséquence, les processus de téléchargement et d'intégration de documents ne sont requis qu'une seule fois, permettant aux utilisateurs de reprendre les conversations de manière transparente.

ALP est destiné à être exécuté via LocalHost. Tout ce dont vous avez besoin est Python et quelques commandes pour configurer l'environnement. N'hésitez pas à fourrer, à explorer le code et à s'adapter à vos besoins ?.

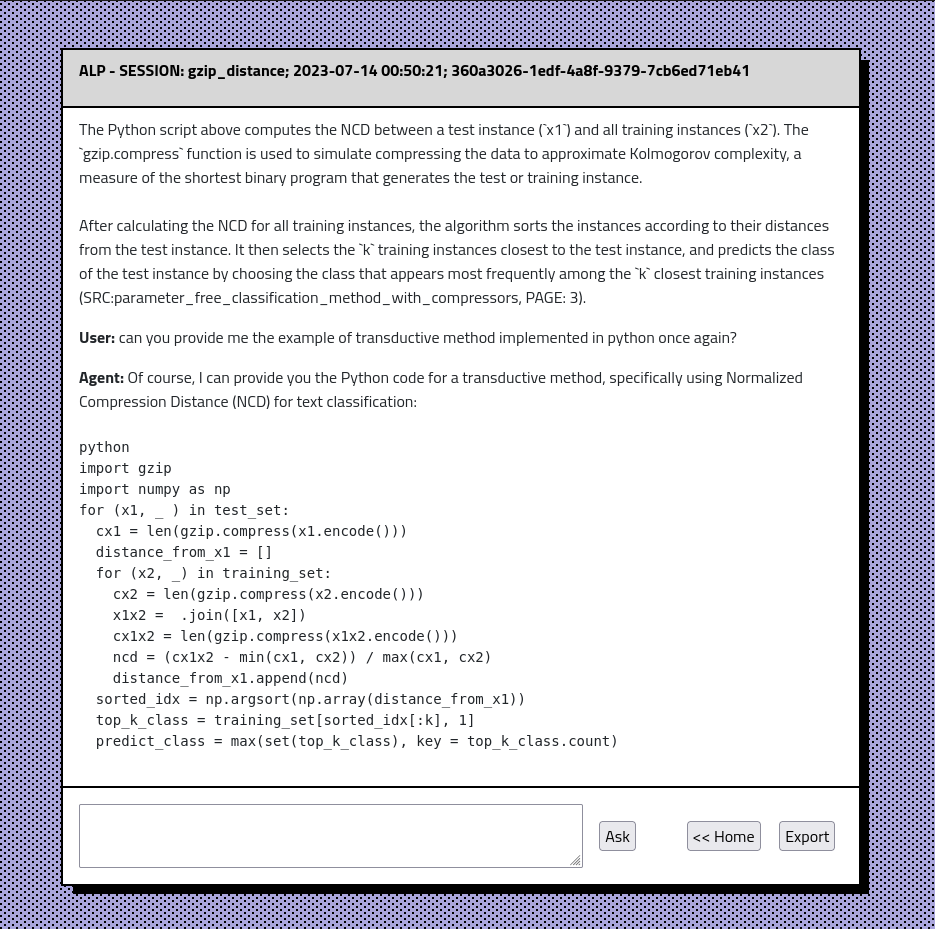

gpt-4o' , gpt-4o-minigpt-4-1106-preview ajouté comme modèle génératif par défaut. L'utilisateur peut le changer dans ./lib/params.py dans prod_model . Création de pages de création de collection Correction de bugs.L'ALP améliore la précision des réponses des modèles basés sur GPT par rapport aux documents PDF donnés en utilisant une méthode d'augmentation de récupération. Cette approche garantit que le contexte le plus pertinent est toujours transmis au modèle. L'intention derrière l'ALP est d'aider l'exploration de l'écrasante base de connaissances des articles de recherche, des livres et des notes, ce qui facilite l'accès et le contenu de digestion.

ALP utilise actuellement les modèles suivants:

multi-qa-MiniLM-L6-cos-v1gpt-4o' , gpt-4o-mini Pour configurer ALP sur votre machine locale, suivez ces étapes:

Assurez-vous que Python soit installé sur votre machine. Je recommande Anaconda pour une configuration facile.

IMPORTANT: ALP fonctionne sur Python 3.10

Après avoir fourni le repo le clonage dans une ligne de commande:

git clone https://github.com/yourusername/alp.git

cd ALPDe l'intérieur de l'ALP / répertoire local Invoquez les commandes suivantes

Pour les utilisateurs de Linux en bash:

python3 -m venv venv

source venv/bin/activatePour les utilisateurs de Windows dans CMD:

python -m venv venv

venvScriptsactivate.bat

Cela devrait créer ALP / VENV / Directory et activer l'environnement virtuel. Naturellement, vous pouvez utiliser d'autres programmes pour gérer VirtualEnvs.

pip install -r requirements.txt Par défaut, ALP s'exécute dans localhost . Il nécessite une touche API pour se connecter avec le modèle GPT via API Open AI. Dans l'ALP / Directory, créez une API_KEY.txt et collez votre clé API là-bas. Assurez-vous que API_KEY.TXT est ajouté à votre fichier .gitignore afin qu'il ne fuit pas à GitHub. Vous pouvez obtenir votre clé API AI ouverte ici https://platform.openai.com

python alp.pyL'application doit s'ouvrir dans votre navigateur Web par défaut. Si ce n'est pas le cas, accédez à http: // localhost: 5000. La première utilisation implique la création du fichier app.db sous ALP / statique / data / dbs /. Il s'agit de votre fichier de base de données SQLite qui conservera l'historique de la conversation et les intégres. En outre, le script téléchargera «Multi-QA-Minilm-L6-Cos-V1» (80 Mo) à votre PC dans des référentiels de visage étreintes. Cela se produira automatiquement lors d'un premier lancement.

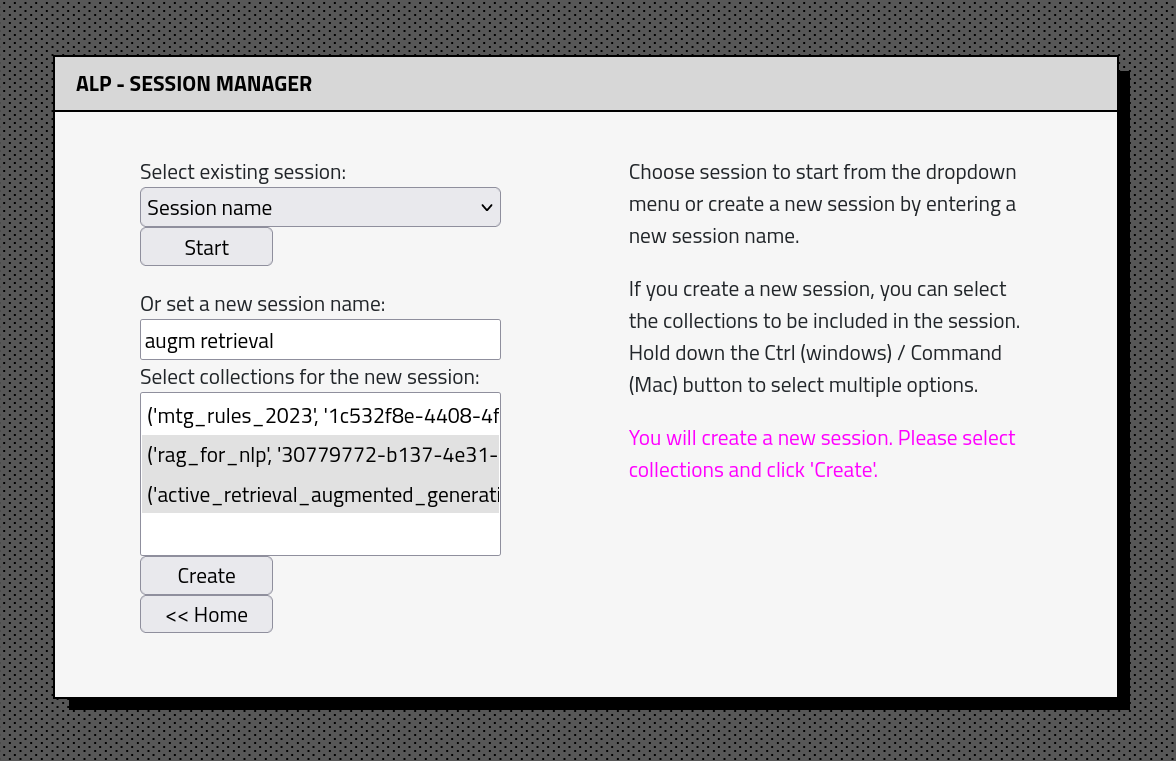

L'interface de l'application ALP se compose de deux sections: