중국 인공 지능 회사 인 Deepseek은 "오픈 소스 주간"의 세 번째 날에 FP8 Universal Matrix Multiplication (GEMM)을 지원하는 DeepGemm이라는 오픈 소스 라이브러리를 발표했습니다. 집중 및 하이브리드 전문가 (MOE) 매트릭스 작업을 위해 설계된이 도구는 DeepSeek V3 및 R1 모델에 대한 교육 및 추론에 대한 강력한 지원을 제공하도록 설계되었습니다. 공식 뉴스가 X 플랫폼을 통해 발표 된 후, 기술 커뮤니티의 광범위한 관심과 격렬한 토론을 빠르게 자극했습니다.

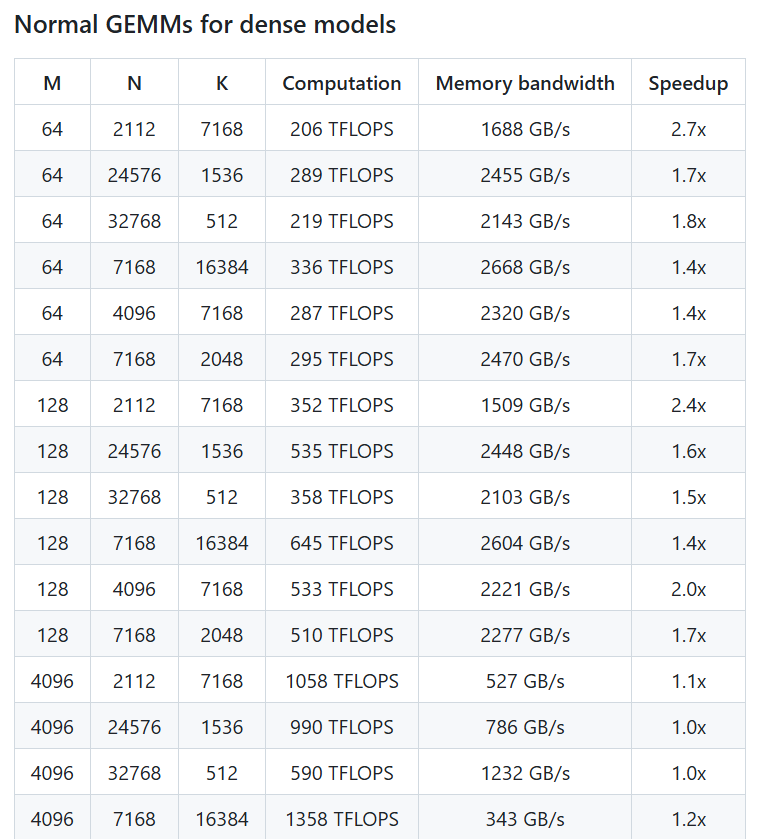

DeepSeek의 공식 계정이 게시 한 게시물에 따르면 DeepGemm은 NVIDIA HOPPER GPU에서 최대 1350+ TFLOPS의 FP8 컴퓨팅 성능을 달성 할 수 있습니다. 핵심 논리에는 약 300 줄의 코드가 포함되어 있지만 라이브러리는 대부분의 매트릭스 크기로 전문적으로 조정 된 커널을 넘어서도 매우 높은 효율성과 단순성을 보여줍니다. DeepGemm은 복잡한 종속성이 필요하지 않으며 정시 기술을 채택하고 집중적 인 레이아웃과 2 개의 MOE 레이아웃을 지원합니다. "튜토리얼처럼 깨끗하게"하도록 설계되었으며 개발자가 배우고 사용하기 쉽습니다.

X 사용자 @TechbitDaily는 다음과 같이 말했습니다 : "DeepGemm의 출시는 인상적인 FP8 성능과 단순성 디자인을 가진 DeepSeek의 오픈 소스 주간의 하이라이트입니다." 또 다른 사용자 @aiobservercn은 라이브러리가 MOE 모델의 효율적인 교육을 지원하는 데 상당한 이점이 있으며 Hopper Architecture에서 AI 커뮤니티에서 추가 혁신을 촉진 할 수 있다고 지적했습니다.

오픈 소스 주간의 일환으로 DeepGemm의 출시는 AI 기술 및 커뮤니티 협업의 투명성을 촉진하려는 DeepSeek의 약속을 계속합니다. 이전 에이 회사는 오픈 소스 주 2 일 전에 FlashMLA 및 Deepep 도구를 발표하여 각각 빠른 언어 모델 아키텍처 및 전문가 병렬 커뮤니케이션에 중점을 두었습니다. DeepGemm의 데뷔는 AI 인프라 구성에서 Deepseek의 기술적 강점을 더욱 보여줍니다. 업계 내부자들은이 라이브러리가 DeepSeek의 자체 모델의 성능을 향상시킬뿐만 아니라 광범위한 미래의 응용 프로그램 전망과 함께 효율적이고 사용하기 쉬운 매트릭스 컴퓨팅 도구를 제공 할 것이라고 생각합니다. 이제 사용자는 Github를 통해 DeepGemm을 얻을 수있어 AI 교육 및 추론의 잠재력을 탐색 할 수 있습니다.

프로젝트 주소 : https://github.com/deepseek-ai/deepgemm