Le troisième jour de sa "Semaine de l'Open Source", la société chinoise de renseignement artificiel Deepseek a annoncé une bibliothèque open source appelée DeepGemm, qui prend en charge la multiplication de la matrice universelle FP8 (GEMM). Conçu pour les opérations de matrice experte intensive et hybride (MOE), cet outil est conçu pour fournir un soutien solide à la formation et à l'inférence pour les modèles Deepseek V3 et R1. Après la publication des nouvelles officielles via la plate-forme X, il a rapidement suscité une attention généralisée et des discussions animées de la communauté technologique.

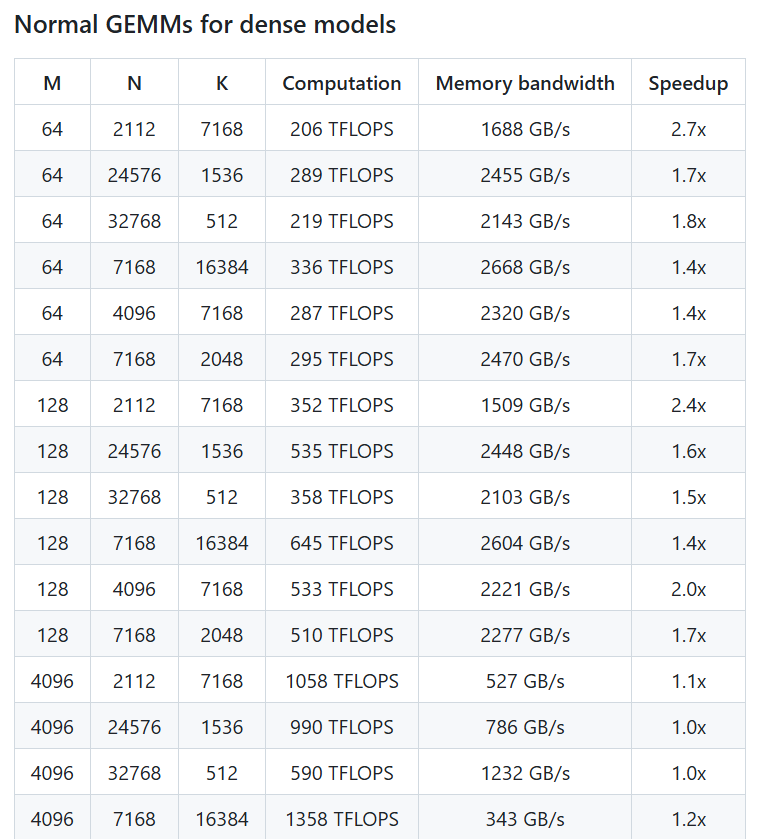

Selon un article publié par le compte officiel de Deepseek, DeepgeMM peut atteindre des performances informatiques FP8 jusqu'à 1350+ tflops sur le GPU Nvidia Hopper. Bien que sa logique de base ne contienne qu'environ 300 lignes de code, la bibliothèque fonctionne même au-delà des noyaux réglés de manière experte sur la plupart des tailles de matrice, montrant une efficacité et une simplicité extrêmement élevées. Deepgemm ne nécessite pas de dépendances complexes et adopte une technologie juste en temps, prend en charge la disposition intensive et deux dispositions de MOE. Il est conçu pour être "propre comme un tutoriel" et est facile à apprendre pour les développeurs.

X User @TechBitDaily a commenté: "Le lancement de Deepgemm est un point culminant de la semaine open source de Deepseek, avec des performances FP8 impressionnantes et une conception de simplicité." Un autre utilisateur @aioBServercn a souligné que la bibliothèque a des avantages importants à soutenir une formation efficace des modèles MOE et peut favoriser une innovation supplémentaire dans la communauté de l'IA dans l'architecture Hopper.

Dans le cadre de la semaine open source, le lancement de Deepgemm continue l'engagement de Deepseek à promouvoir la transparence dans la technologie de l'IA et la collaboration communautaire. Auparavant, la société avait publié des outils FlashMLA et Deepp deux jours avant la semaine open source, en se concentrant respectivement sur l'architecture du modèle de langage rapide et les communications parallèles expertes. Les débuts de Deepgemm démontre en outre la force technique de Deepseek dans la construction des infrastructures d'IA. Les initiés de l'industrie estiment que cette bibliothèque améliorera non seulement les performances du modèle de Deepseek, mais offrira également aux développeurs mondiaux un outil informatique de matrice efficace et facile à utiliser, avec de larges perspectives d'application futures. Les utilisateurs peuvent désormais obtenir Deepgemm via GitHub pour explorer son potentiel dans la formation et le raisonnement de l'IA.

Adresse du projet: https://github.com/deepseek-ai/deepgemm