En el tercer día de su "Semana de código abierto", la compañía de inteligencia artificial china Deepseek anunció una biblioteca de código abierto llamada DeepGemm, que admite FP8 Universal Matrix Multipleation (GEMM). Diseñada para operaciones de matriz de expertos intensivos e híbridos (MOE), esta herramienta está diseñada para proporcionar un fuerte apoyo para la capacitación e inferencia para los modelos DeepSeek V3 y R1. Después de que se lanzó las noticias oficiales a través de la plataforma X, rápidamente despertó una atención generalizada y las acaloradas discusiones de la comunidad tecnológica.

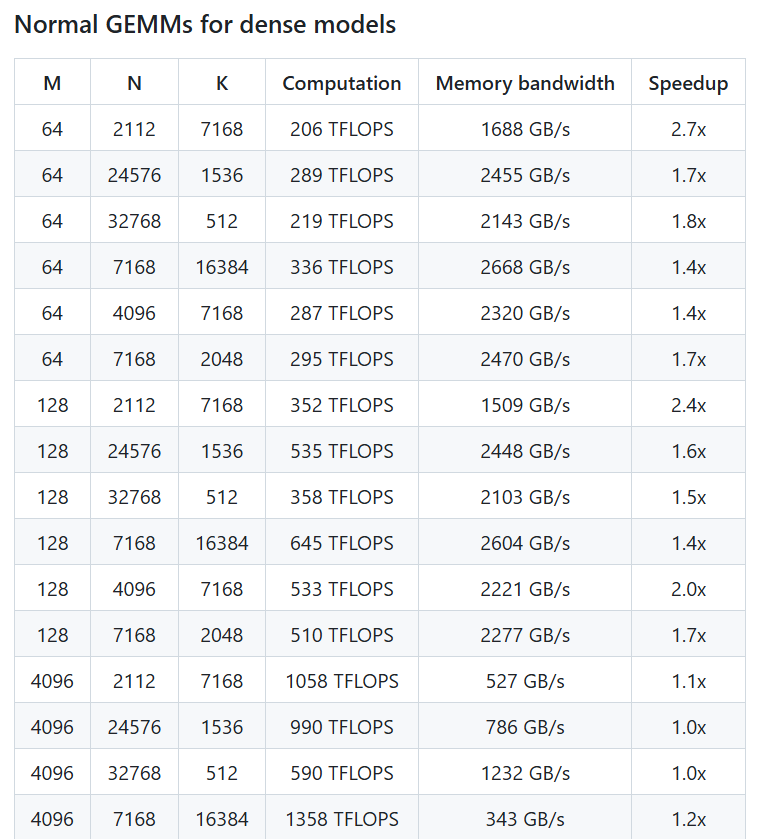

Según una publicación publicada por la cuenta oficial de Deepseek, DeepGemm puede lograr un rendimiento informático de FP8 de hasta más de 1350 Tflops en la GPU de Nvidia Hopper. Aunque su lógica central contiene solo unas 300 líneas de código, la biblioteca se desempeña incluso más allá de los núcleos sintonizados expertos en la mayoría de los tamaños de matriz, mostrando una eficiencia y simplicidad extremadamente alta. DeepGemm no requiere dependencias complejas y adopta tecnología justo a tiempo, admite un diseño intensivo y dos diseños de MOE. Está diseñado para estar "limpio como un tutorial" y es fácil de aprender y usar para los desarrolladores.

X usuario @TechBitDaily comentó: "El lanzamiento de DeepGemm es lo más destacado de la semana de código abierto de Deepseek, con un impresionante diseño de FP8 y un diseño de simplicidad". Otro usuario @aiobservercn señaló que la biblioteca tiene ventajas significativas para apoyar la capacitación eficiente de los modelos MOE y puede promover una mayor innovación en la comunidad de IA en la arquitectura de la tolva.

Como parte de la Semana de Open Source, el lanzamiento de DeepGemm continúa el compromiso de Deepseek de promover la transparencia en la tecnología de IA y la colaboración comunitaria. Anteriormente, la compañía había lanzado herramientas FlashMLA y Deepep dos días antes de la Semana de Open Source, centrándose en la arquitectura de modelos de lenguaje rápido y las comunicaciones paralelas expertas, respectivamente. El debut de DeepGemm demuestra aún más la fuerza técnica de Deepseek en la construcción de infraestructura de IA. Los expertos de la industria creen que esta biblioteca no solo mejorará el desempeño del modelo de Deepseek, sino que también proporcionará a los desarrolladores globales una herramienta de computación de matriz eficiente y fácil de usar, con amplias perspectivas futuras de aplicaciones. Los usuarios ahora pueden obtener DeepGemm a través de Github para explorar su potencial en el entrenamiento y el razonamiento de la IA.

Dirección del proyecto: https://github.com/deepseek-ai/deepgemm