저작권 (C) 2018 Nvidia Corporation. 모든 권리 보유. CC By-NC-SA 4.0 라이센스 (https://creativecommons.org/licenses/by-nc-sa/4.0/legalcode)에 따라 라이센스가 부여됩니다.

Caffe 사용자의 경우 Caffe/Readme.md를 참조하십시오.

Pytorch 사용자의 경우 Pytorch/Readme.md를 참조하십시오

Pytorch 구현은 Caffe 구현과 거의 일치합니다 (Sintel Training 세트의 최종 패스에서 평균 EPE : Pytorch의 2.31 및 Caffe의 2.29).

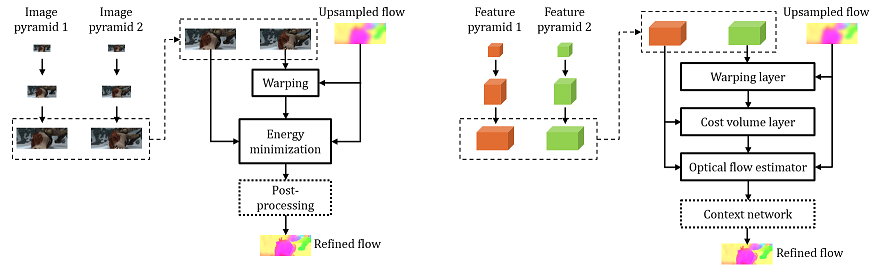

PWC-NET는 최첨단 결과를 달성하기위한 엔드 투 엔드 훈련 가능한 심해 신경망에서 이미지 피라미드, 뒤틀림 및 비용 볼륨을 포함한 몇 가지 고전적인 광학 흐름 추정 기술을 융합시킵니다.

Deqing Sun, Xiaodong Yang, Ming-Yu Liu 및 Jan Kautz. "PWC-NET : 피라미드, 뒤틀림 및 비용 부피를 사용한 광학 흐름에 대한 CNN." CVPR 2018 또는 ARXIV : 1709.02371

업데이트 및 확장 버전 : "모델이 중요합니다. 교육도 마찬가지입니다. 광학 흐름 추정을위한 CNN에 대한 경험적 연구." ARXIV : 1809.05571

프로젝트 페이지 링크

Robust Vision Challenge Workshop에서 이야기하십시오

CVPR 2018 컨퍼런스에서 대화하십시오

pwc-net을 사용하는 경우 다음 논문을 인용하십시오.

@InProceedings{Sun2018PWC-Net,

author = {Deqing Sun and Xiaodong Yang and Ming-Yu Liu and Jan Kautz},

title = {{PWC-Net}: {CNNs} for Optical Flow Using Pyramid, Warping, and Cost Volume},

booktitle = CVPR,

year = {2018},

}

또는 Arxiv 종이

@article{sun2017pwc,

author={Sun, Deqing and Yang, Xiaodong and Liu, Ming-Yu and Kautz, Jan},

title={{PWC-Net}: {CNNs} for Optical Flow Using Pyramid, Warping, and Cost Volume},

journal={arXiv preprint arXiv:1709.02371},

year={2017}

}

또는 업데이트 및 확장 버전

@article{Sun2018:Model:Training:Flow,

author={Sun, Deqing and Yang, Xiaodong and Liu, Ming-Yu and Kautz, Jan},

title={Models Matter, So Does Training: An Empirical Study of CNNs for Optical Flow Estimation},

journal={IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI)},

note = {to appear}

}

멀티 프레임 흐름에 대해서도 인용하십시오

@inproceedings{ren2018fusion,

title={A Fusion Approach for Multi-Frame Optical Flow Estimation},

author={Ren, Zhile and Gallo, Orazio and Sun, Deqing and Yang, Ming-Hsuan and Sudderth, Erik B and Kautz, Jan},

booktitle={Proceedings of the IEEE Winter Conference on Applications of Computer Vision (WACV)},

year={2019}

}

FLOWNET2-PYTORCH

3D 모션 필드 추정을위한 움직이는 카메라로 동적 장면의 강성 학습 (ECCV 2018)

deqing sun ([email protected])