영어 | 简体中文

종이 구현 :

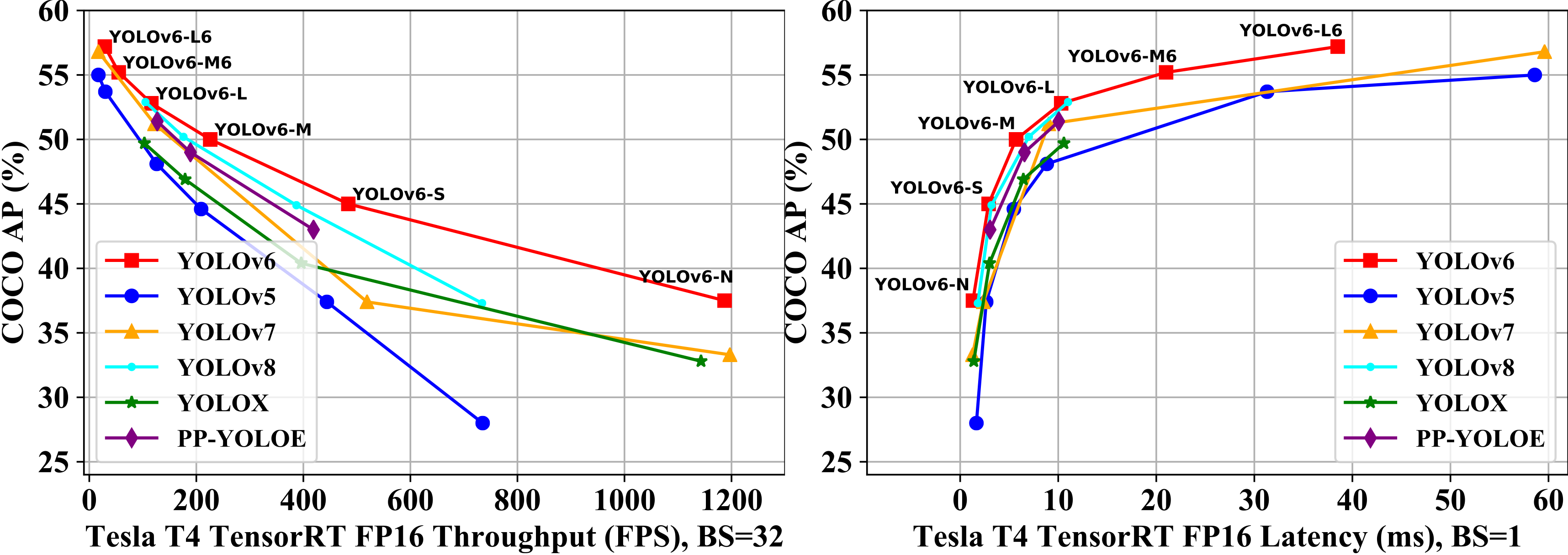

| 모델 | 크기 | 지도 발 0.5 : 0.95 | 속도 T4 TRT FP16 B1 (FPS) | 속도 T4 TRT FP16 B32 (FPS) | 매개 변수 (중) | 플롭 (G) |

|---|---|---|---|---|---|---|

| yolov6-n | 640 | 37.5 | 779 | 1187 | 4.7 | 11.4 |

| yolov6-s | 640 | 45.0 | 339 | 484 | 18.5 | 45.3 |

| yolov6-m | 640 | 50.0 | 175 | 226 | 34.9 | 85.8 |

| yolov6-l | 640 | 52.8 | 98 | 116 | 59.6 | 150.7 |

| yolov6-n6 | 1280 | 44.9 | 228 | 281 | 10.4 | 49.8 |

| Yolov6-S6 | 1280 | 50.3 | 98 | 108 | 41.4 | 198.0 |

| Yolov6-M6 | 1280 | 55.2 | 47 | 55 | 79.6 | 379.5 |

| yolov6-l6 | 1280 | 57.2 | 26 | 29 | 140.4 | 673.4 |

| 모델 | 크기 | 지도 발 0.5 : 0.95 | 속도 T4 TRT FP16 B1 (FPS) | 속도 T4 TRT FP16 B32 (FPS) | 매개 변수 (중) | 플롭 (G) |

|---|---|---|---|---|---|---|

| yolov6-n | 640 | 35.9 300e 36.3 400e | 802 | 1234 | 4.3 | 11.1 |

| yolov6-t | 640 | 40.3 300E 41.1 400e | 449 | 659 | 15.0 | 36.7 |

| yolov6-s | 640 | 43.5 300e 43.8 400e | 358 | 495 | 17.2 | 44.2 |

| yolov6-m | 640 | 49.5 | 179 | 233 | 34.3 | 82.2 |

| Yolov6-L-Relu | 640 | 51.7 | 113 | 149 | 58.5 | 144.0 |

| yolov6-l | 640 | 52.5 | 98 | 121 | 58.5 | 144.0 |

| 모델 | 크기 | 정도 | 지도 발 0.5 : 0.95 | 속도 T4 TRT B1 (FPS) | 속도 T4 TRT B32 (FPS) |

|---|---|---|---|---|---|

| Yolov6-N Repopt | 640 | int8 | 34.8 | 1114 | 1828 |

| yolov6-n | 640 | FP16 | 35.9 | 802 | 1234 |

| Yolov6-T Repopt | 640 | int8 | 39.8 | 741 | 1167 |

| yolov6-t | 640 | FP16 | 40.3 | 449 | 659 |

| Yolov6-S Repopt | 640 | int8 | 43.3 | 619 | 924 |

| yolov6-s | 640 | FP16 | 43.5 | 377 | 541 |

| 모델 | 크기 | 지도 발 0.5 : 0.95 | SM8350 (MS) | MT6853 (MS) | SDM660 (MS) | 매개 변수 (중) | 플롭 (G) |

|---|---|---|---|---|---|---|---|

| yolov6lite-s | 320*320 | 22.4 | 7.99 | 11.99 | 41.86 | 0.55 | 0.56 |

| yolov6lite-m | 320*320 | 25.1 | 9.08 | 13.27 | 47.95 | 0.79 | 0.67 |

| yolov6lite-l | 320*320 | 28.0 | 11.37 | 16.20 | 61.40 | 1.09 | 0.87 |

| yolov6lite-l | 320*192 | 25.0 | 7.02 | 9.66 | 36.13 | 1.09 | 0.52 |

| yolov6lite-l | 224*128 | 18.9 | 3.63 | 4.99 | 17.76 | 1.09 | 0.24 |

git clone https://github.com/meituan/YOLOv6

cd YOLOv6

pip install -r requirements.txtTrain Coco 데이터 세트를 참조하십시오.

단일 GPU

# P5 models

python tools/train.py --batch 32 --conf configs/yolov6s_finetune.py --data data/dataset.yaml --fuse_ab --device 0

# P6 models

python tools/train.py --batch 32 --conf configs/yolov6s6_finetune.py --data data/dataset.yaml --img 1280 --device 0멀티 GPU (DDP 모드 권장)

# P5 models

python -m torch.distributed.launch --nproc_per_node 8 tools/train.py --batch 256 --conf configs/yolov6s_finetune.py --data data/dataset.yaml --fuse_ab --device 0,1,2,3,4,5,6,7

# P6 models

python -m torch.distributed.launch --nproc_per_node 8 tools/train.py --batch 128 --conf configs/yolov6s6_finetune.py --data data/dataset.yaml --img 1280 --device 0,1,2,3,4,5,6,7 ├── coco

│ ├── annotations

│ │ ├── instances_train2017.json

│ │ └── instances_val2017.json

│ ├── images

│ │ ├── train2017

│ │ └── val2017

│ ├── labels

│ │ ├── train2017

│ │ ├── val2017

│ ├── LICENSE

│ ├── README.txt

YOLOV6은 다른 입력 해상도 모드를 지원합니다. 자세한 내용은 입력 크기를 설정하는 방법을 참조하십시오.

교육 과정이 손상되면 교육을 재개 할 수 있습니다.

# single GPU training.

python tools/train.py --resume

# multi GPU training.

python -m torch.distributed.launch --nproc_per_node 8 tools/train.py --resume

위의 명령은 YOLOV6 디렉토리에서 최신 체크 포인트를 자동으로 찾은 다음 교육 프로세스를 재개합니다.

또한 --resume 매개 변수에 대한 체크 포인트 경로를 지정할 수도 있습니다.

# remember to replace /path/to/your/checkpoint/path to the checkpoint path which you want to resume training.

--resume /path/to/your/checkpoint/path

이것은 당신이 제공하는 특정 체크 포인트에서 재개됩니다.

640 × 640 또는 1280x1280 해상도로 Coco Val2017 데이터 세트에서지도를 재현하십시오.

# P5 models

python tools/eval.py --data data/coco.yaml --batch 32 --weights yolov6s.pt --task val --reproduce_640_eval

# P6 models

python tools/eval.py --data data/coco.yaml --batch 32 --weights yolov6s6.pt --task val --reproduce_640_eval --img 1280먼저, YOLOV6 릴리스에서 사전 고정 된 모델을 다운로드하거나 훈련 된 모델을 사용하여 추론하십시오.

둘째, tools/infer.py 에 대한 추론을 실행하십시오

# P5 models

python tools/infer.py --weights yolov6s.pt --source img.jpg / imgdir / video.mp4

# P6 models

python tools/infer.py --weights yolov6s6.pt --img 1280 1280 --source img.jpg / imgdir / video.mp4로컬 카메라 나 웹 카메라에서 추론하려면 다음을 실행할 수 있습니다.

# P5 models

python tools/infer.py --weights yolov6s.pt --webcam --webcam-addr 0

# P6 models

python tools/infer.py --weights yolov6s6.pt --img 1280 1280 --webcam --webcam-addr 0 webcam-addr 로컬 카메라 번호 ID 또는 RTSP 주소 일 수 있습니다.

Amazon Sagemaker와의 Yolov6 교육 : AshwinCC의 Yolov6-Sagemaker

YOLOV6 NCNN Android 앱 데모 : Feigechuanshu의 NCNN android-Yolov6

YOLOV6 ONNXRUNTIME/MNN/TNN C ++ : DEFTRUTH의 YOLOV6-ORT, YOLOV6-MNN 및 YOLOV6-TNN

linaom1214로부터 Yolov6 Tensorrt Python : YOLOV6-TENSORRT-PYSTHON

Yolov6 Tensorrt Windows C ++ : Wei Zeng의 Yolort

Gradio가있는 Huggingface 공간에 대한 Yolov6 웹 데모.

간소 한 Dagshub의 대화식 데모

튜토리얼 : 사용자 정의 데이터 세트에서 Yolov6을 훈련시키는 방법

YouTube 튜토리얼 : 사용자 정의 데이터 세트에서 Yolov6을 훈련시키는 방법

Google Colab에서 Yolov6 추론의 데모

블로그 게시물 : Yolov6 객체 감지 - 종이 설명 및 추론

궁금한 점이 있으시면 WeChat 그룹에 가입하여 토론하고 교환하십시오.