Inglés | 简体中文

Implementación del documento:

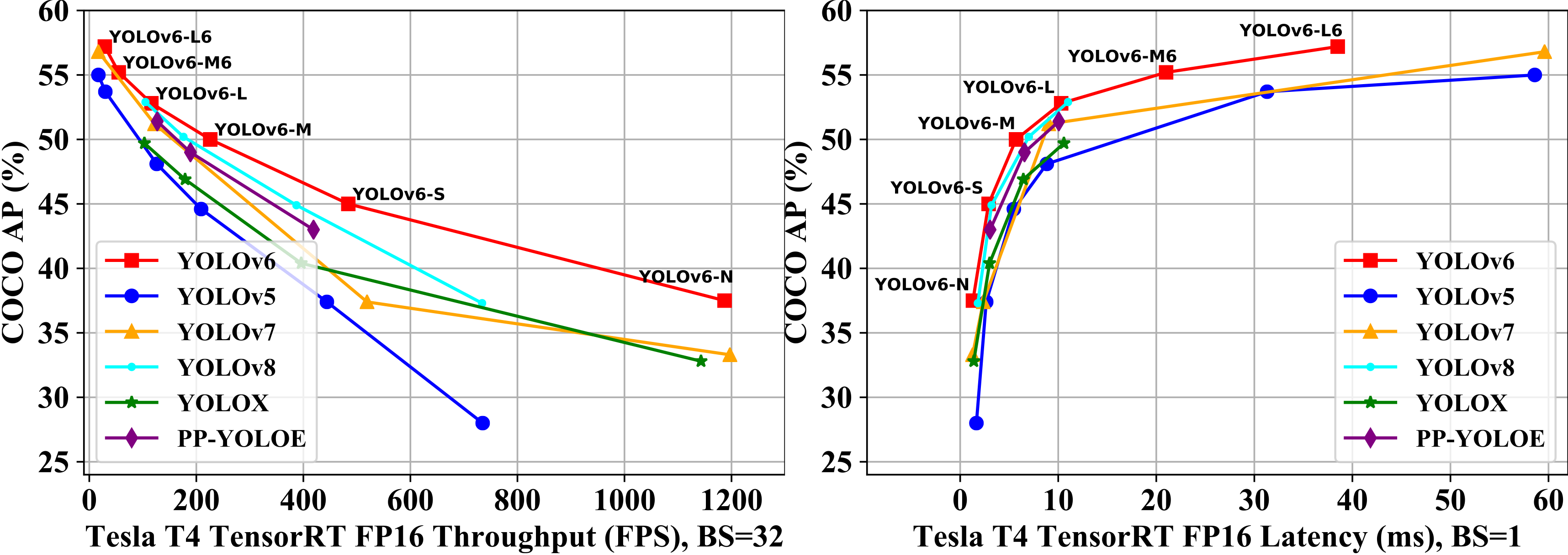

| Modelo | Tamaño | mapa val 0.5: 0.95 | Velocidad t4 TRT FP16 B1 (FPS) | Velocidad t4 TRT FP16 B32 (FPS) | Parámetros (METRO) | Chocolas (GRAMO) |

|---|---|---|---|---|---|---|

| Yolov6-n | 640 | 37.5 | 779 | 1187 | 4.7 | 11.4 |

| Yolov6-S | 640 | 45.0 | 339 | 484 | 18.5 | 45.3 |

| Yolov6-m | 640 | 50.0 | 175 | 226 | 34.9 | 85.8 |

| Yolov6-l | 640 | 52.8 | 98 | 116 | 59.6 | 150.7 |

| Yolov6-n6 | 1280 | 44.9 | 228 | 281 | 10.4 | 49.8 |

| Yolov6-S6 | 1280 | 50.3 | 98 | 108 | 41.4 | 198.0 |

| Yolov6-m6 | 1280 | 55.2 | 47 | 55 | 79.6 | 379.5 |

| Yolov6-l6 | 1280 | 57.2 | 26 | 29 | 140.4 | 673.4 |

| Modelo | Tamaño | mapa val 0.5: 0.95 | Velocidad t4 TRT FP16 B1 (FPS) | Velocidad t4 TRT FP16 B32 (FPS) | Parámetros (METRO) | Chocolas (GRAMO) |

|---|---|---|---|---|---|---|

| Yolov6-n | 640 | 35.9 300E 36.3 400E | 802 | 1234 | 4.3 | 11.1 |

| Yolov6-t | 640 | 40.3 300E 41.1 400E | 449 | 659 | 15.0 | 36.7 |

| Yolov6-S | 640 | 43.5 300E 43.8 400E | 358 | 495 | 17.2 | 44.2 |

| Yolov6-m | 640 | 49.5 | 179 | 233 | 34.3 | 82.2 |

| Yolov6-L-Lelu | 640 | 51.7 | 113 | 149 | 58.5 | 144.0 |

| Yolov6-l | 640 | 52.5 | 98 | 121 | 58.5 | 144.0 |

| Modelo | Tamaño | Precisión | mapa val 0.5: 0.95 | Velocidad t4 TRT B1 (FPS) | Velocidad t4 TRT B32 (FPS) |

|---|---|---|---|---|---|

| Yolov6-n repopt | 640 | Int8 | 34.8 | 1114 | 1828 |

| Yolov6-n | 640 | FP16 | 35.9 | 802 | 1234 |

| Yolov6-t repopt | 640 | Int8 | 39.8 | 741 | 1167 |

| Yolov6-t | 640 | FP16 | 40.3 | 449 | 659 |

| Yolov6-s repopt | 640 | Int8 | 43.3 | 619 | 924 |

| Yolov6-S | 640 | FP16 | 43.5 | 377 | 541 |

| Modelo | Tamaño | mapa val 0.5: 0.95 | SM8350 (EM) | MT6853 (EM) | SDM660 (EM) | Parámetros (METRO) | Chocolas (GRAMO) |

|---|---|---|---|---|---|---|---|

| Yolov6lite-s | 320*320 | 22.4 | 7.99 | 11.99 | 41.86 | 0.55 | 0.56 |

| Yolov6lite-m | 320*320 | 25.1 | 9.08 | 13.27 | 47.95 | 0.79 | 0.67 |

| Yolov6lite-l | 320*320 | 28.0 | 11.37 | 16.20 | 61.40 | 1.09 | 0.87 |

| Yolov6lite-l | 320*192 | 25.0 | 7.02 | 9.66 | 36.13 | 1.09 | 0.52 |

| Yolov6lite-l | 224*128 | 18.9 | 3.63 | 4.99 | 17.76 | 1.09 | 0.24 |

git clone https://github.com/meituan/YOLOv6

cd YOLOv6

pip install -r requirements.txtConsulte el conjunto de datos de Coco Coco.

GPU único

# P5 models

python tools/train.py --batch 32 --conf configs/yolov6s_finetune.py --data data/dataset.yaml --fuse_ab --device 0

# P6 models

python tools/train.py --batch 32 --conf configs/yolov6s6_finetune.py --data data/dataset.yaml --img 1280 --device 0GPU múltiple (modo DDP recomendado)

# P5 models

python -m torch.distributed.launch --nproc_per_node 8 tools/train.py --batch 256 --conf configs/yolov6s_finetune.py --data data/dataset.yaml --fuse_ab --device 0,1,2,3,4,5,6,7

# P6 models

python -m torch.distributed.launch --nproc_per_node 8 tools/train.py --batch 128 --conf configs/yolov6s6_finetune.py --data data/dataset.yaml --img 1280 --device 0,1,2,3,4,5,6,7 ├── coco

│ ├── annotations

│ │ ├── instances_train2017.json

│ │ └── instances_val2017.json

│ ├── images

│ │ ├── train2017

│ │ └── val2017

│ ├── labels

│ │ ├── train2017

│ │ ├── val2017

│ ├── LICENSE

│ ├── README.txt

Yolov6 admite diferentes modos de resolución de entrada. Para obtener más detalles, consulte cómo establecer el tamaño de entrada.

Si su proceso de capacitación está dañado, puede reanudar la capacitación por

# single GPU training.

python tools/train.py --resume

# multi GPU training.

python -m torch.distributed.launch --nproc_per_node 8 tools/train.py --resume

El comando anterior encontrará automáticamente el último punto de control en el directorio YOLOV6, luego reanudará el proceso de capacitación.

También puede especificar una ruta de punto de control para -parámetro --resume por

# remember to replace /path/to/your/checkpoint/path to the checkpoint path which you want to resume training.

--resume /path/to/your/checkpoint/path

Esto se reanudará desde el punto de control específico que proporciona.

Reproducir el mapa en el conjunto de datos Coco Val2017 con 640 × 640 o 1280x1280 Resolución

# P5 models

python tools/eval.py --data data/coco.yaml --batch 32 --weights yolov6s.pt --task val --reproduce_640_eval

# P6 models

python tools/eval.py --data data/coco.yaml --batch 32 --weights yolov6s6.pt --task val --reproduce_640_eval --img 1280Primero, descargue un modelo previo a la versión de Yolov6 o use su modelo capacitado para hacer inferencia.

Segundo, ejecute inferencia con tools/infer.py

# P5 models

python tools/infer.py --weights yolov6s.pt --source img.jpg / imgdir / video.mp4

# P6 models

python tools/infer.py --weights yolov6s6.pt --img 1280 1280 --source img.jpg / imgdir / video.mp4Si desea inferencia en la cámara local o la cámara web, puede ejecutar:

# P5 models

python tools/infer.py --weights yolov6s.pt --webcam --webcam-addr 0

# P6 models

python tools/infer.py --weights yolov6s6.pt --img 1280 1280 --webcam --webcam-addr 0 webcam-addr puede ser la ID de número de cámara local o la dirección RTSP.

Entrenamiento de Yolov6 con Amazon Sagemaker: Yolov6-Sagemaker de Ashwincc

Yolov6 NCNN Android App Demo: NCNN-Android-Yolov6 de Feigechuanshu

Yolov6 onnxruntime/mnn/tnn c ++: yolov6-art, yolov6-mnn y yolov6-tnn de Deftruth

Yolov6 Tensorrt Python: Yolov6-Tensorrt-Python de Linaom1214

Yolov6 tensorrt windows c ++: yolort de wei zeng

Demostración web de Yolov6 en espacios Huggingface con Gradio.

Demostración interactiva en dagShub con racionalización

Tutorial: Cómo entrenar Yolov6 en un conjunto de datos personalizado

Tutorial de YouTube: cómo entrenar yolov6 en un conjunto de datos personalizado

Demostración de inferencia de yolov6 en Google Colab

Publicación de blog: Detección de objetos Yolov6 - Explicación en papel e inferencia

Si tiene alguna pregunta, bienvenido a unirse a nuestro grupo WeChat para discutir e intercambiar.