Englisch | 简体中文

Implementierung von Papier:

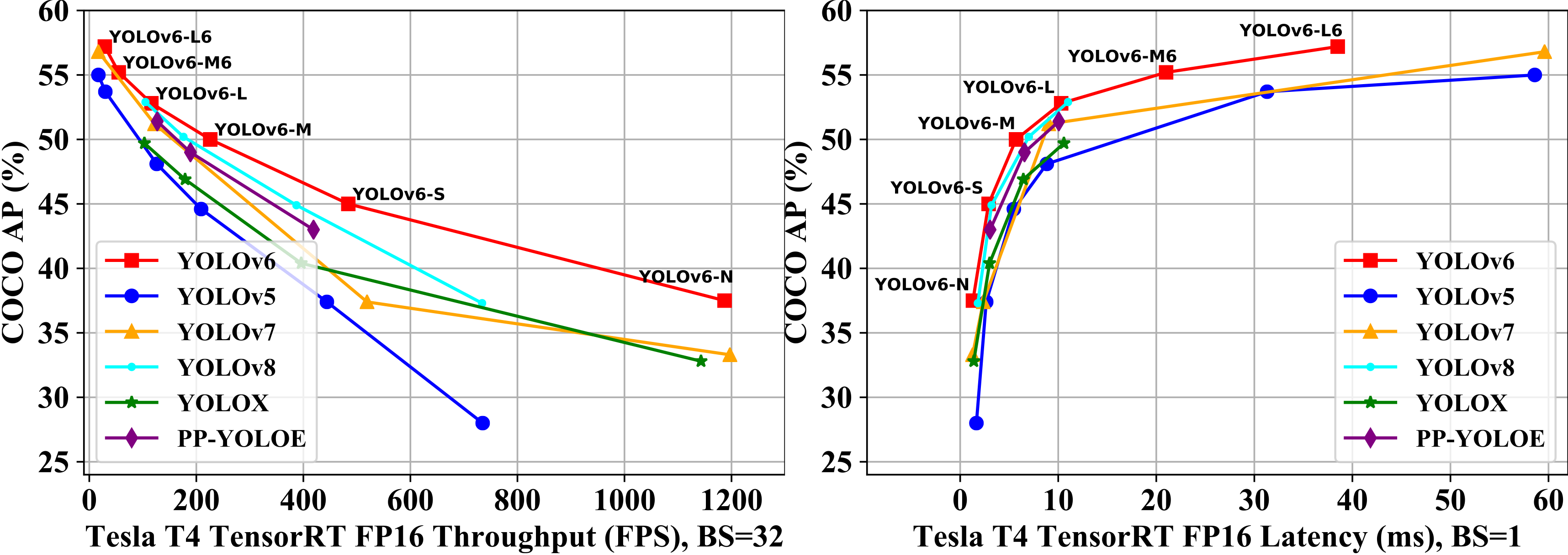

| Modell | Größe | Karte val 0,5: 0,95 | Geschwindigkeit T4 TRT FP16 B1 (FPS) | Geschwindigkeit T4 TRT FP16 B32 (FPS) | Parameter (M) | Flops (G) |

|---|---|---|---|---|---|---|

| Yolov6-n | 640 | 37,5 | 779 | 1187 | 4.7 | 11.4 |

| Yolov6-s | 640 | 45,0 | 339 | 484 | 18.5 | 45,3 |

| Yolov6-m | 640 | 50.0 | 175 | 226 | 34.9 | 85,8 |

| Yolov6-l | 640 | 52,8 | 98 | 116 | 59,6 | 150.7 |

| Yolov6-N6 | 1280 | 44,9 | 228 | 281 | 10.4 | 49,8 |

| Yolov6-s6 | 1280 | 50.3 | 98 | 108 | 41,4 | 198.0 |

| Yolov6-m6 | 1280 | 55.2 | 47 | 55 | 79,6 | 379,5 |

| Yolov6-L6 | 1280 | 57,2 | 26 | 29 | 140,4 | 673.4 |

| Modell | Größe | Karte val 0,5: 0,95 | Geschwindigkeit T4 TRT FP16 B1 (FPS) | Geschwindigkeit T4 TRT FP16 B32 (FPS) | Parameter (M) | Flops (G) |

|---|---|---|---|---|---|---|

| Yolov6-n | 640 | 35,9 300e 36.3 400e | 802 | 1234 | 4.3 | 11.1 |

| Yolov6-t | 640 | 40.3 300e 41.1 400e | 449 | 659 | 15.0 | 36.7 |

| Yolov6-s | 640 | 43,5 300e 43,8 400e | 358 | 495 | 17.2 | 44,2 |

| Yolov6-m | 640 | 49,5 | 179 | 233 | 34.3 | 82.2 |

| Yolov6-l-relu | 640 | 51.7 | 113 | 149 | 58,5 | 144.0 |

| Yolov6-l | 640 | 52,5 | 98 | 121 | 58,5 | 144.0 |

| Modell | Größe | Präzision | Karte val 0,5: 0,95 | Geschwindigkeit T4 Trt B1 (FPS) | Geschwindigkeit T4 Trt B32 (FPS) |

|---|---|---|---|---|---|

| Yolov6-n Repopt | 640 | Int8 | 34.8 | 1114 | 1828 |

| Yolov6-n | 640 | FP16 | 35.9 | 802 | 1234 |

| Yolov6-t Repopt | 640 | Int8 | 39,8 | 741 | 1167 |

| Yolov6-t | 640 | FP16 | 40.3 | 449 | 659 |

| Yolov6-s Repopt | 640 | Int8 | 43.3 | 619 | 924 |

| Yolov6-s | 640 | FP16 | 43,5 | 377 | 541 |

| Modell | Größe | Karte val 0,5: 0,95 | SM8350 (MS) | MT6853 (MS) | SDM660 (MS) | Parameter (M) | Flops (G) |

|---|---|---|---|---|---|---|---|

| Yolov6lite-s | 320*320 | 22.4 | 7.99 | 11.99 | 41,86 | 0,55 | 0,56 |

| Yolov6lite-m | 320*320 | 25.1 | 9.08 | 13.27 | 47,95 | 0,79 | 0,67 |

| Yolov6lite-l | 320*320 | 28.0 | 11.37 | 16.20 | 61.40 | 1.09 | 0,87 |

| Yolov6lite-l | 320*192 | 25.0 | 7.02 | 9.66 | 36.13 | 1.09 | 0,52 |

| Yolov6lite-l | 224*128 | 18.9 | 3.63 | 4.99 | 17.76 | 1.09 | 0,24 |

git clone https://github.com/meituan/YOLOv6

cd YOLOv6

pip install -r requirements.txtWeitere Informationen finden Sie im Train Coco -Datensatz.

Single GPU

# P5 models

python tools/train.py --batch 32 --conf configs/yolov6s_finetune.py --data data/dataset.yaml --fuse_ab --device 0

# P6 models

python tools/train.py --batch 32 --conf configs/yolov6s6_finetune.py --data data/dataset.yaml --img 1280 --device 0Multi -GPUs (DDP -Modus empfohlen)

# P5 models

python -m torch.distributed.launch --nproc_per_node 8 tools/train.py --batch 256 --conf configs/yolov6s_finetune.py --data data/dataset.yaml --fuse_ab --device 0,1,2,3,4,5,6,7

# P6 models

python -m torch.distributed.launch --nproc_per_node 8 tools/train.py --batch 128 --conf configs/yolov6s6_finetune.py --data data/dataset.yaml --img 1280 --device 0,1,2,3,4,5,6,7 ├── coco

│ ├── annotations

│ │ ├── instances_train2017.json

│ │ └── instances_val2017.json

│ ├── images

│ │ ├── train2017

│ │ └── val2017

│ ├── labels

│ │ ├── train2017

│ │ ├── val2017

│ ├── LICENSE

│ ├── README.txt

YOLOV6 unterstützt verschiedene Eingangsauflösungsmodi. Weitere Informationen finden Sie unter der Festlegung der Eingangsgröße.

Wenn Ihr Trainingsprozess beschädigt ist, können Sie das Training mit dem Training fortsetzen

# single GPU training.

python tools/train.py --resume

# multi GPU training.

python -m torch.distributed.launch --nproc_per_node 8 tools/train.py --resume

Oben Befehl findet automatisch den neuesten Checkpoint im Yolov6 -Verzeichnis und fördert dann den Schulungsprozess.

Sie können auch einen Checkpoint -Pfad an --resume Parameter von angeben

# remember to replace /path/to/your/checkpoint/path to the checkpoint path which you want to resume training.

--resume /path/to/your/checkpoint/path

Dies wird von dem spezifischen Checkpoint, den Sie bereitstellen, wieder aufgenommen.

Reproduzieren Sie die Karte auf CoCO VAL2017 -Datensatz mit 640 × 640 oder 1280 x 1280 Auflösung

# P5 models

python tools/eval.py --data data/coco.yaml --batch 32 --weights yolov6s.pt --task val --reproduce_640_eval

# P6 models

python tools/eval.py --data data/coco.yaml --batch 32 --weights yolov6s6.pt --task val --reproduce_640_eval --img 1280Laden Sie zunächst ein vorgezogenes Modell aus der Yolov6 -Version herunter oder verwenden Sie Ihr geschultes Modell, um Schluss zu führen.

Zweitens führen Sie Inferenz mit tools/infer.py aus

# P5 models

python tools/infer.py --weights yolov6s.pt --source img.jpg / imgdir / video.mp4

# P6 models

python tools/infer.py --weights yolov6s6.pt --img 1280 1280 --source img.jpg / imgdir / video.mp4Wenn Sie sich auf die lokale Kamera oder die Webkamera einsetzen möchten, können Sie ausführen:

# P5 models

python tools/infer.py --weights yolov6s.pt --webcam --webcam-addr 0

# P6 models

python tools/infer.py --weights yolov6s6.pt --img 1280 1280 --webcam --webcam-addr 0 webcam-addr kann die lokale Kamera-Nummern-ID oder eine RTSP-Adresse sein.

YOLOV6-Training mit Amazon Sagemaker: Yolov6-Agemaker von Ashwincc

Yolov6 ncnn android App Demo: ncnn-android-yolov6 von feigechuanshu

Yolov6 onnxruntime/mnn/tnn c ++: yolov6-ort, yolov6-mnn und yolov6-tnn aus Deftruth

Yolov6 Tensorrt Python: Yolov6-Tensorrt-Python von Linaom1214

Yolov6 Tensorrt Windows C ++: Yolort von Wei Zeng

YOLOV6 -Web -Demo auf Umarmungsflächen mit Gradio.

Interaktive Demo auf Dagshub mit stromloser

Tutorial: Wie man Yolov6 in einem benutzerdefinierten Datensatz trainiert

YouTube -Tutorial: So trainieren Sie Yolov6 auf einem benutzerdefinierten Datensatz

Demo von Yolov6 Inferenz auf Google Colab

Blogbeitrag: Yolov6 -Objekterkennung - Erklärung und Inferenzpapier

Wenn Sie Fragen haben, sollten Sie sich unserer Wechat -Gruppe anschließen, um zu diskutieren und auszutauschen.