팁 : , ,, 目标检测、目标跟踪、语义分割等 目标检测、目标跟踪、语义分割等, QQ3419923783

| 이름 | 기차 데이터 세트 | 테스트 데이터 세트 | 테스트 크기 | 지도 | 추론 시간 (MS) | 매개 변수 (m) | 모델 링크 |

|---|---|---|---|---|---|---|---|

| mobilenetv2-yolov4 | VOC TRAINVAL (07+12) | VOC 테스트 (07) | 416 | 0.851 | 11.29 | 46.34 | args |

Mobilenetv3-Yolov4가 도착하고 있습니다! (config/yolov4_config.py에서 model_type 만 변경하면됩니다.

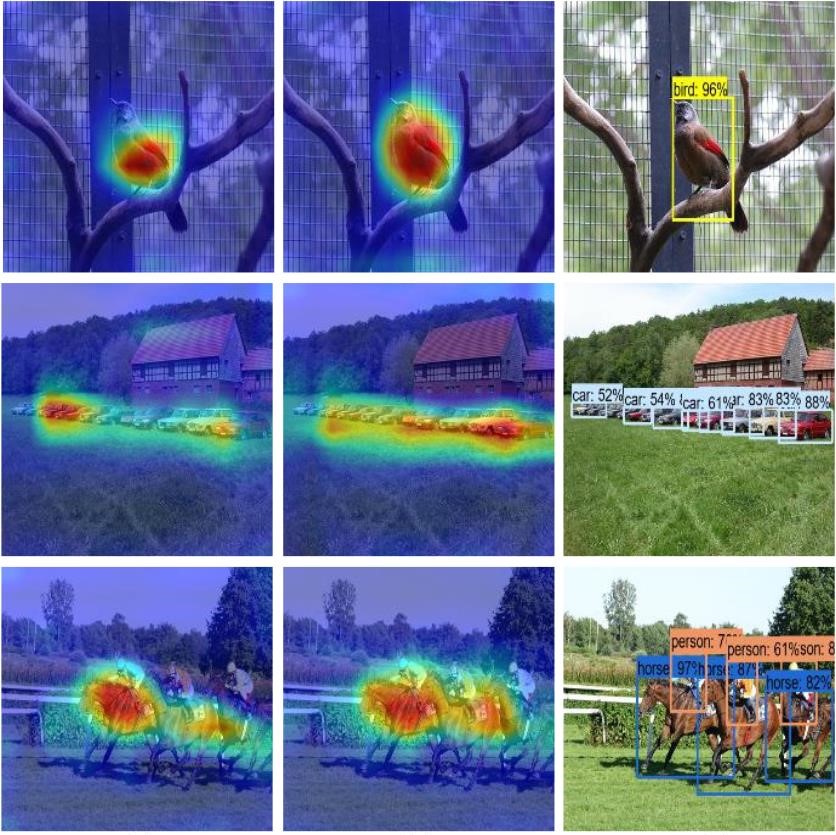

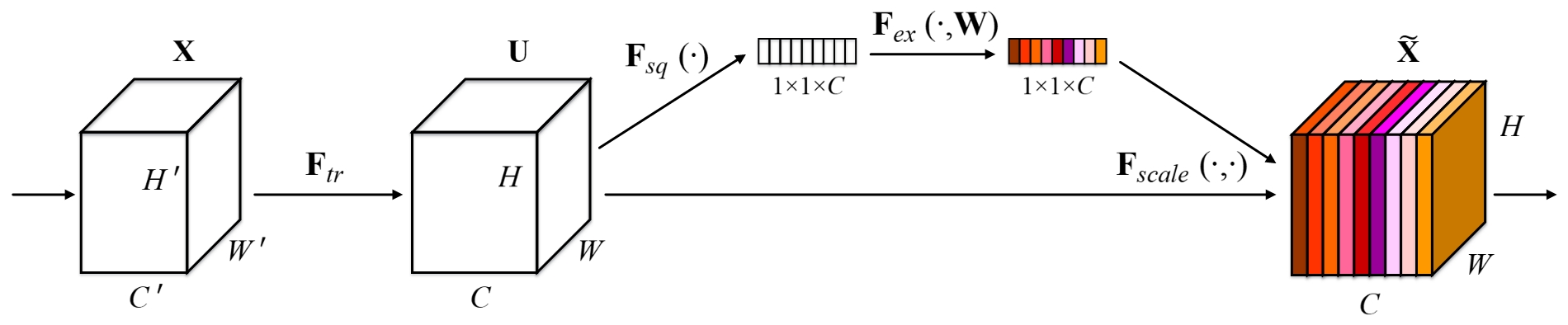

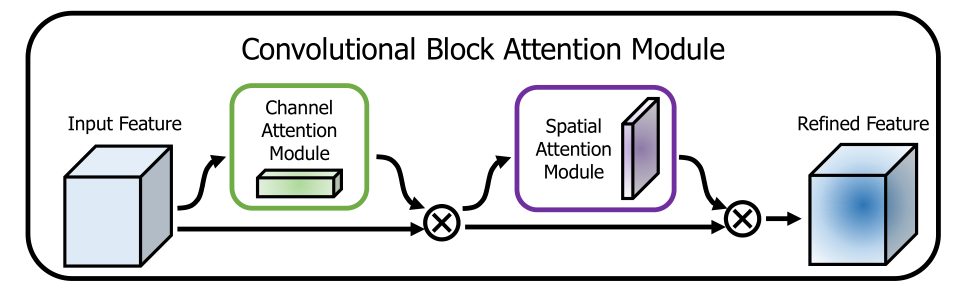

이 repo는 백본에 유용한주의 방법을 추가합니다. 다음 그림은 다음을 보여줍니다.

이 repo는 사용하기 간단하고 읽기 쉽고 다른 사람들과 비교할 때 개선하기가 쉽지 않습니다 !!!

설치 스크립트를 실행하여 모든 종속성을 설치하십시오. Conda 설치 경로 (예 : ~/anaconda3)와 생성 된 Conda 환경 (여기서 YOLOv4-pytorch )의 이름을 제공해야합니다.

pip3 install -r requirements.txt --user참고 : 설치 스크립트는 Ubuntu 18.04 및 Window 10 시스템에서 테스트되었습니다. 문제의 경우 자세한 설치 지침을 확인하십시오.

git clone github.com/argusswift/YOLOv4-pytorch.git config/yolov4_config.py에서 "PROJECT_PATH" 업데이트하십시오.

# Download the data.

cd $HOME /data

wget http://host.robots.ox.ac.uk/pascal/VOC/voc2012/VOCtrainval_11-May-2012.tar

wget http://host.robots.ox.ac.uk/pascal/VOC/voc2007/VOCtrainval_06-Nov-2007.tar

wget http://host.robots.ox.ac.uk/pascal/VOC/voc2007/VOCtest_06-Nov-2007.tar

# Extract the data.

tar -xvf VOCtrainval_11-May-2012.tar

tar -xvf VOCtrainval_06-Nov-2007.tar

tar -xvf VOCtest_06-Nov-2007.tar # step1: download the following data and annotation

2017 Train images [118K/18GB]

2017 Val images [5K/1GB]

2017 Test images [41K/6GB]

2017 Train/Val annotations [241MB]

# step2: arrange the data to the following structure

COCO

---train

---test

---val

---annotations"DATA_PATH" 업데이트하십시오.weight/ 만들고 가중치 파일을 넣으십시오. 다음 명령을 실행하여 교육을 시작하고 config/yolov4_config.py 의 세부 사항을 확인하면 교육 프로그램을 실행할 때 Data_Type를 VOC 또는 Coco로 설정해야합니다.

CUDA_VISIBLE_DEVICES=0 nohup python -u train.py --weight_path weight/yolov4.weights --gpu_id 0 > nohup.log 2>&1 & 또한 * 훈련을 재개하는 지원 --resume , 커뮤니케이션을 사용하여 자동으로 last.pt 됩니다.

CUDA_VISIBLE_DEVICES=0 nohup python -u train.py --weight_path weight/last.pt --gpu_id 0 > nohup.log 2>&1 & Detecte IMG 경로를 수정하십시오 : data_test =/path/to/your/test_data # 자신의 이미지를 수정하십시오

for VOC dataset:

CUDA_VISIBLE_DEVICES=0 python3 eval_voc.py --weight_path weight/best.pt --gpu_id 0 --visiual $DATA_TEST --eval --mode det

for COCO dataset:

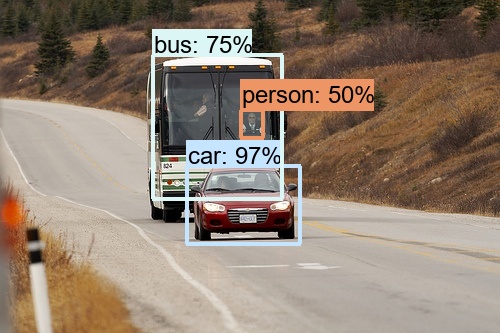

CUDA_VISIBLE_DEVICES=0 python3 eval_coco.py --weight_path weight/best.pt --gpu_id 0 --visiual $DATA_TEST --eval --mode det 이미지는 output/ 에서 볼 수 있습니다. 다음과 같은 사진을 볼 수 있습니다.

수정하다:

CUDA_VISIBLE_DEVICES=0 python3 video_test.py --weight_path best.pt --gpu_id 0 --video_path video.mp4 --output_dir --output_dir평가 데이터 세트 경로 평가 : data_path =/path/to/your/test_data # 자신의 이미지를 수정하십시오

for VOC dataset:

CUDA_VISIBLE_DEVICES=0 python3 eval_voc.py --weight_path weight/best.pt --gpu_id 0 --visiual $DATA_TEST --eval --mode val

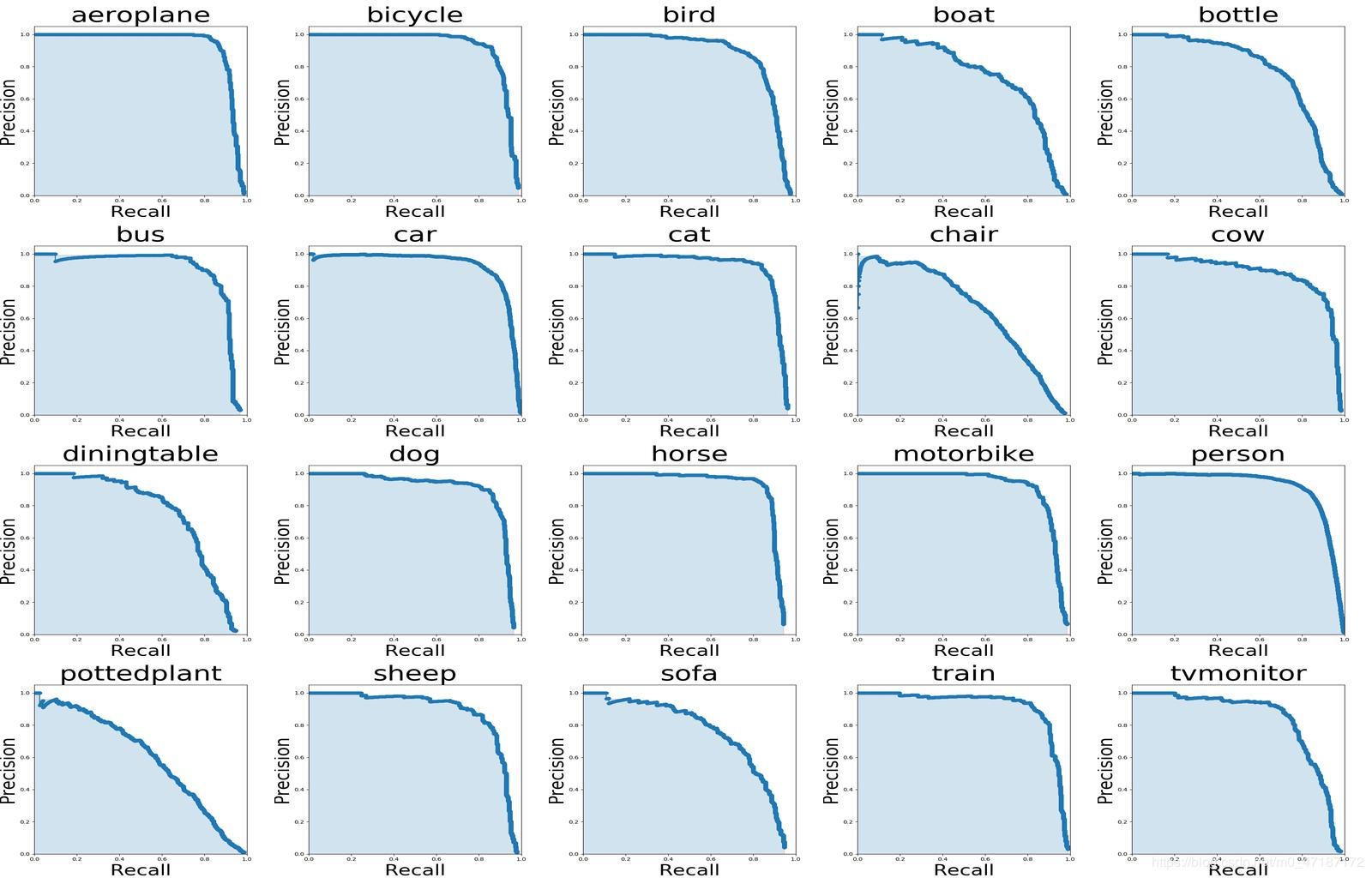

위의 그림을 보려면 다음 명령을 사용해야합니다.

# To get ground truths of your dataset

python3 utils/get_gt_txt.py

# To plot P-R curve and calculate mean average precision

python3 utils/get_map.py 평가 데이터 세트 경로 평가 : data_path =/path/to/your/test_data # 자신의 이미지를 수정하십시오

CUDA_VISIBLE_DEVICES=0 python3 eval_coco.py --weight_path weight/best.pt --gpu_id 0 --visiual $DATA_TEST --eval --mode val

type=bbox

Running per image evaluation... DONE (t=0.34s).

Accumulating evaluation results... DONE (t=0.08s).

Average Precision (AP) @[ IoU = 0.50:0.95 | area = all | maxDets = 100 ] = 0.438

Average Precision (AP) @[ IoU = 0.50 | area = all | maxDets = 100 ] = 0.607

Average Precision (AP) @[ IoU = 0.75 | area = all | maxDets = 100 ] = 0.469

Average Precision (AP) @[ IoU = 0.50:0.95 | area = small | maxDets = 100 ] = 0.253

Average Precision (AP) @[ IoU = 0.50:0.95 | area = medium | maxDets = 100 ] = 0.486

Average Precision (AP) @[ IoU = 0.50:0.95 | area = large | maxDets = 100 ] = 0.567

Average Recall (AR) @[ IoU = 0.50:0.95 | area = all | maxDets = 1 ] = 0.342

Average Recall (AR) @[ IoU = 0.50:0.95 | area = all | maxDets = 10 ] = 0.571

Average Recall (AR) @[ IoU = 0.50:0.95 | area = all | maxDets = 100 ] = 0.632

Average Recall (AR) @[ IoU = 0.50:0.95 | area = small | maxDets = 100 ] = 0.458

Average Recall (AR) @[ IoU = 0.50:0.95 | area = medium | maxDets = 100 ] = 0.691

Average Recall (AR) @[ IoU = 0.50:0.95 | area = large | maxDets = 100 ] = 0.790python3 utils/modelsize.pyval_voc.py에서 showatt = ture를 설정하면 네트워크 '출력에서 열광이 등장하는 것을 볼 수 있습니다.

for VOC dataset:

CUDA_VISIBLE_DEVICES=0 python3 eval_voc.py --weight_path weight/best.pt --gpu_id 0 --visiual $DATA_TEST --eval

for COCO dataset:

CUDA_VISIBLE_DEVICES=0 python3 eval_coco.py --weight_path weight/best.pt --gpu_id 0 --visiual $DATA_TEST --eval 히트 맵은 output/ 에서 볼 수 있습니다.