Wenhao Wu 1,2 , Huanjin Yao 2,3 , Mengxi Zhang 2,4 , Yuxin Song 2 , Wanli Ouyang 5 , Jingdong Wang 2

1 시드니 대학교, 2 바이두, 3 Tsinghua University, 4 Tianjin University, 5 홍콩 중국 대학

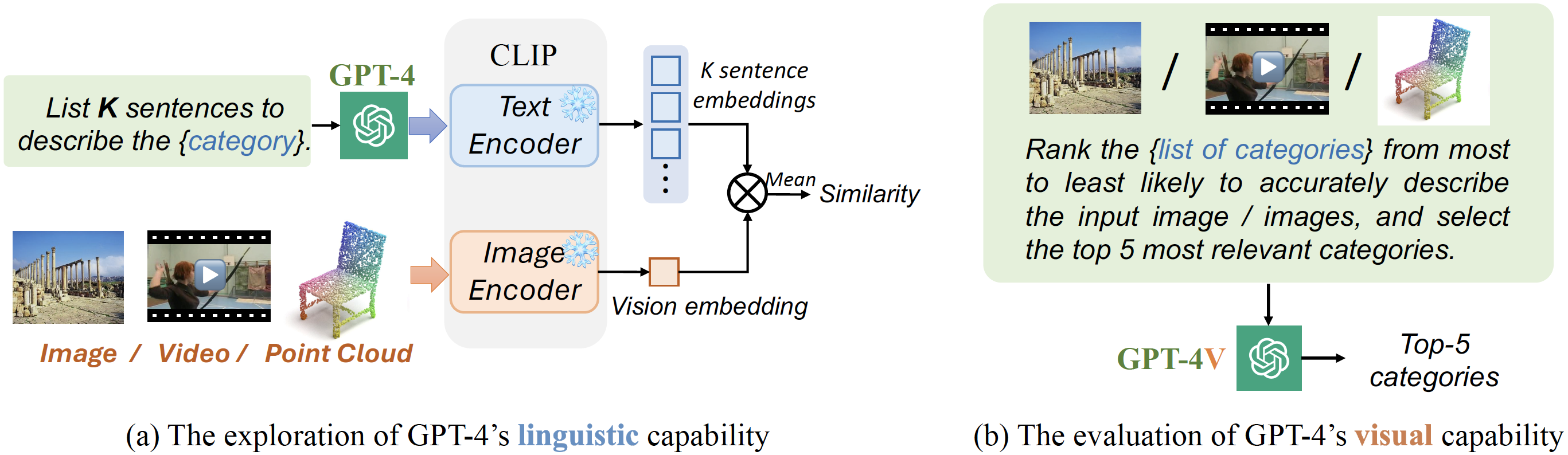

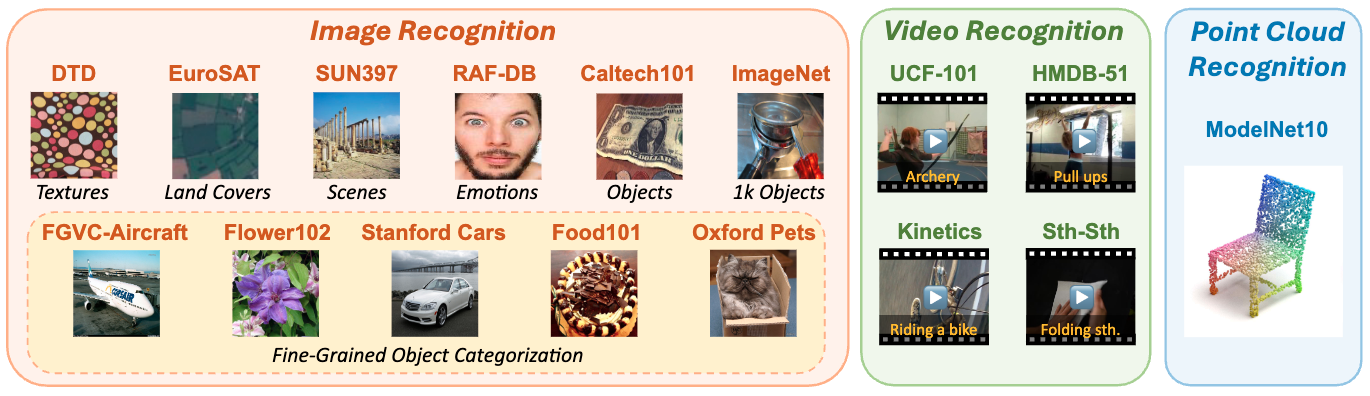

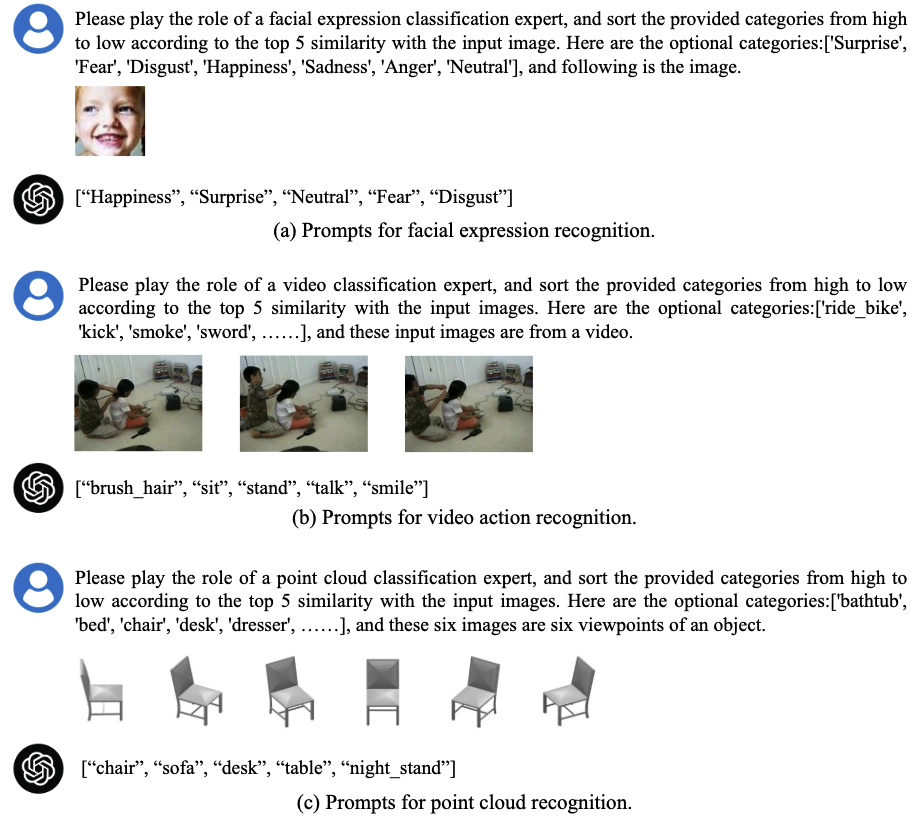

이 작업은 생성 인공 지능 (GENAI)의 최신 발전에 비추어 필수적이지만 알아야 할 기준을 탐구합니다. 시각적 이해를 위해 GPT-4의 활용. 우리는 제로 샷 시각적 인식 작업에서 GPT-4의 언어 및 시각적 기능 평가를 중심으로합니다. 포괄적 인 평가를 보장하기 위해 총 16 개의 인기있는 학업 벤치 마크를 불러 일으키는 세 가지 양식 (이미지, 비디오 및 포인트 클라우드)에 대한 실험을 수행했습니다.

분류기 재 방문 : 비디오 인식을위한 비전 언어 모델 전송

Wenhao Wu, Zhun Sun, Wanli Ouyang

미리 훈련 된 비전 언어 모델을 사용한 비디오 인식을위한 양방향 교차 모달 지식 탐색

Wenhao Wu, Xiaohan Wang, Haipeng Luo, Jingdong Wang, Yi Yang, Wanli Ouyang

CAP4VIDEO : 텍스트 비디오 검색을 위해 보조 캡션이 무엇을 할 수 있습니까?

Wenhao Wu, Haipeng Luo, Bo Fang, Jingdong Wang, Wanli Ouyang

CVPR 2023에 의해 하이라이트? |

GPT-4의 언어 및 시각적 기능을 활용하는 제로 샷 시각적 인식.

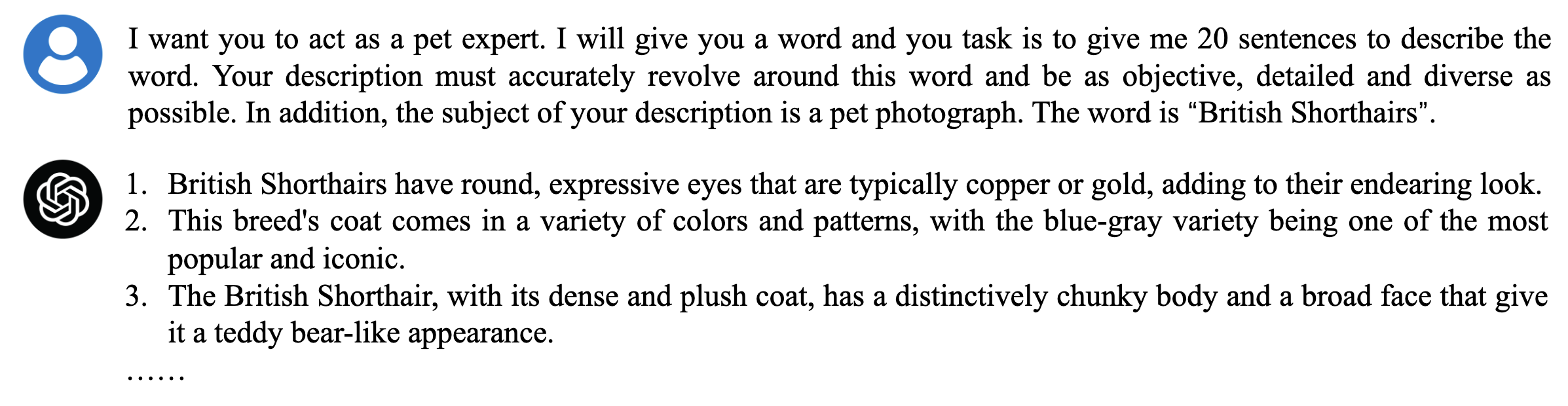

GPT_GENERATED_PROMPTS 폴더에서 찾을 수있는 데이터 세트의 모든 범주에 대한 사전 생성 설명 문장이 있습니다. 탐험을 즐기십시오!

또한 GPT-4를 사용하여 설명을 생성하는 데 도움이되는 예제 스크립트를 제공했습니다. 이에 대한 지침은 generate_prompt.py 파일을 참조하십시오. 행복한 코딩! 프로젝트에 사용 된 모든 데이터 세트에 대한 자세한 정보는 구성 폴더를 참조하십시오.

GPT-4로 설명을 생성하려면 다음 명령을 실행하십시오.

# To run the script for specific dataset, simply update the following line with the name of the dataset you're working with:

# dataset_name = ["Dataset Name Here"] # e.g., dtd

python generate_prompt.py

DTD 데이터 세트에서 제로 샷 예측에 GPT-4V API를 사용하는 방법을 보여주는 예제 스크립트를 공유합니다. 이 구현에 대한 단계별 안내서는 gpt4v_zs.py 파일을 참조하십시오. 우리는 그것이 당신이 쉽게 시작하는 데 도움이되기를 바랍니다!

# GPT4V zero-shot recognition script.

# dataset_name = ["Dataset Name Here"] # e.g., dtd

python GPT4V_ZS.py모든 결과는 gpt4v_zs_results 폴더에서 사용할 수 있습니다! 또한 데이터 세트 링크를 해당 근거 진실 ( 주석 폴더)과 함께 제공하여 리더가 결과를 복제하는 데 도움이됩니다. 참고 : 특정 데이터 세트의 경우 샘플 ID에서 접두사를 제거했을 수 있습니다. 예를 들어, ImageNet의 경우 "ILSVRC2012_VAL_00031094.JPEG"는 "00031094.jpeg"로 수정되었습니다.

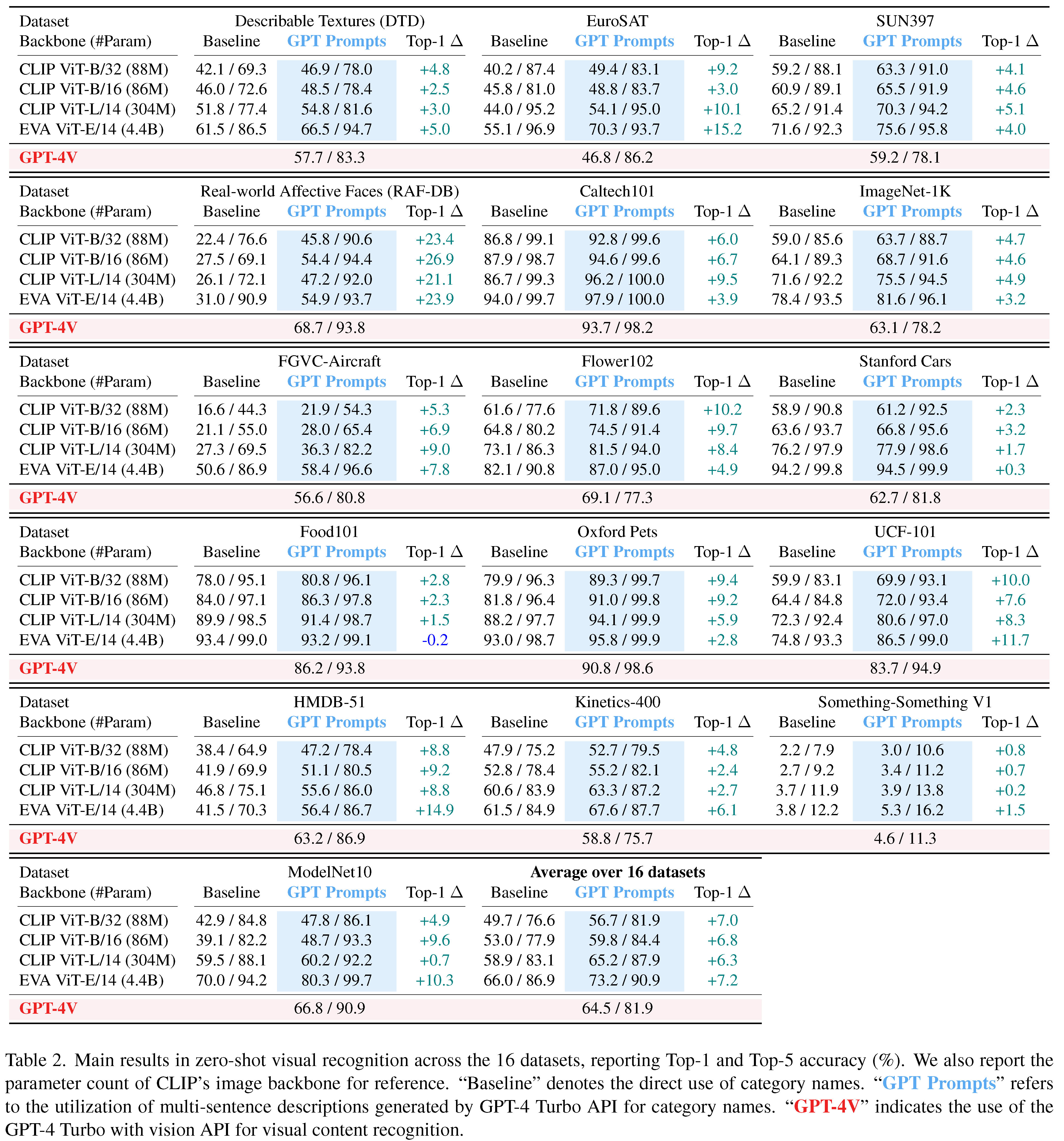

| DTD | EUROSAT | Sun397 | RAF-DB | caltech101 | imagenet-1k | FGVC-Aircraft | 꽃 102 |

|---|---|---|---|---|---|---|---|

| 57.7 | 46.8 | 59.2 | 68.7 | 93.7 | 63.1 | 56.6 | 69.1 |

| 상표 | 상표 | 상표 | 상표 | 상표 | 상표 | 상표 | 상표 |

| 스탠포드 차 | Food101 | 옥스포드 애완 동물 | UCF-101 | HMDB-51 | 동역학 -400 | ModelNet-10 |

|---|---|---|---|---|---|---|

| 62.7 | 86.2 | 90.8 | 83.7 | 58.8 | 58.8 | 66.9 |

| 상표 | 상표 | 상표 | 상표 | 상표 | 상표 | 상표 |

제공된 예측 및 주석 파일을 사용하면 계산 _acc.py 스크립트를 사용하여 상단 1/상단 5 정확도 결과를 재현 할 수 있습니다.

# pred_json_path = 'GPT4V_ZS_Results/imagenet.json'

# gt_json_path = 'annotations/imagenet_gt.json'

python calculate_acc.pyGPT-4 API 설정 및 실행에 대한 지침을 보려면 OpenAi QuickStart Guide에서 사용할 수있는 공식 OpenAi QuickStart 문서를 확인하는 것이 좋습니다.

귀하의 연구에서 우리의 코드를 사용하거나 결과를 참조하려면 별을 주시나요? 이 저장소와 다음 Bibtex를 사용합니까? 기입.

@article { GPT4Vis ,

title = { GPT4Vis: What Can GPT-4 Do for Zero-shot Visual Recognition? } ,

author = { Wu, Wenhao and Yao, Huanjin and Zhang, Mengxi and Song, Yuxin and Ouyang, Wanli and Wang, Jingdong } ,

booktitle = { arXiv preprint arXiv:2311.15732 } ,

year = { 2023 }

}이 평가는 훌륭한 작품을 기반으로합니다.

우리는이 기고자들에게 진심으로 감사를 표합니다.

질문이 있으시면 언제든지 문제를 제기하십시오.