Wenhao Wu 1،2 ، Huanjin Yao 2،3 ، Mengxi Zhang 2،4 ، Yuxin Song 2 ، Wanli Ouyang 5 ، Jingdong Wang 2

1 جامعة سيدني ، 2 بايدو ، 3 جامعة تسينغهوا ، 4 جامعة تيانجين ، 5 جامعة هونغ كونغ الصينية

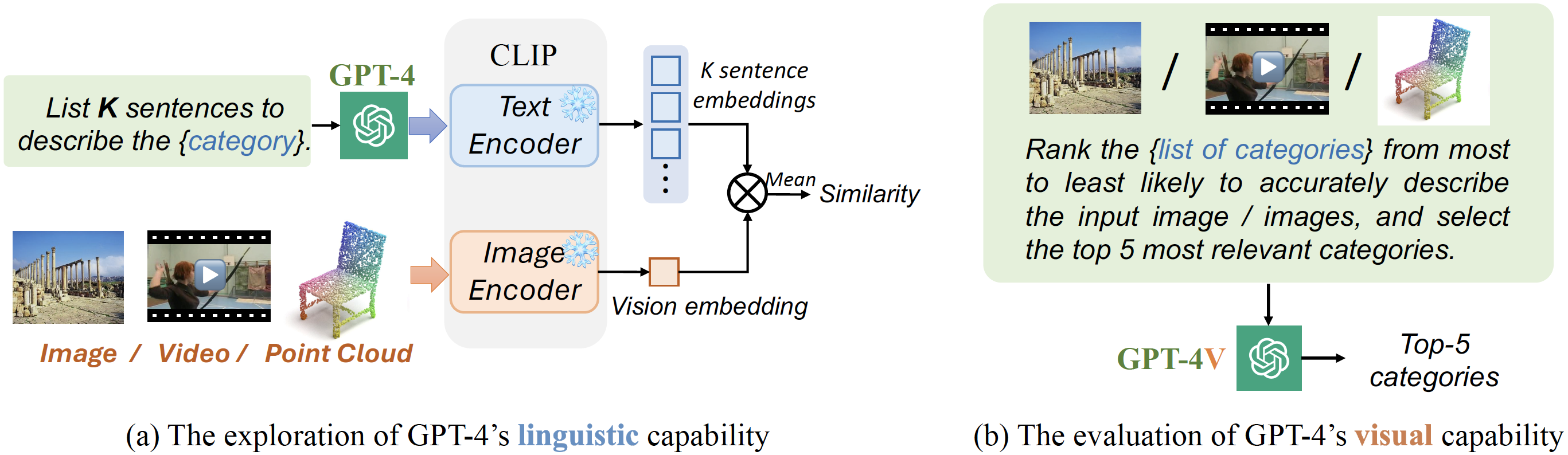

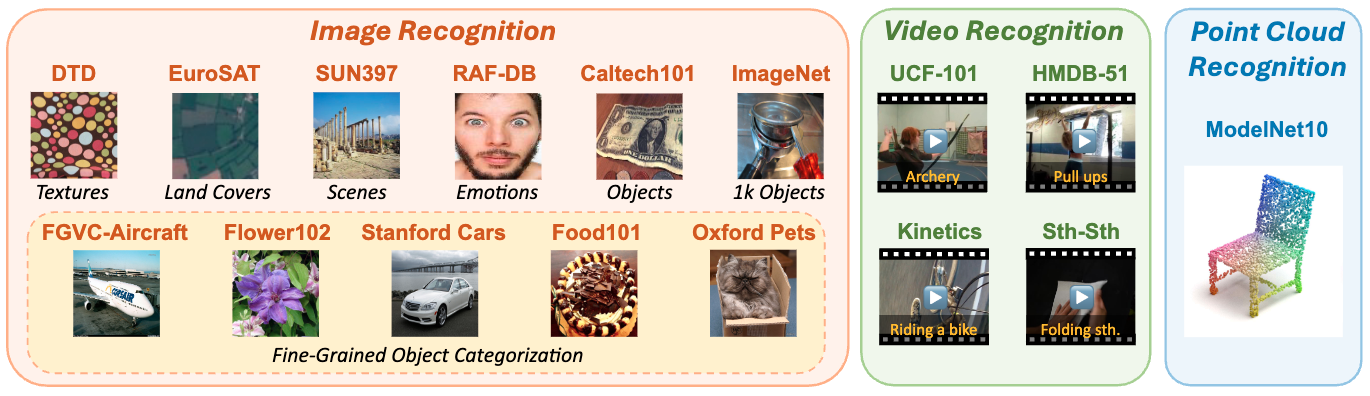

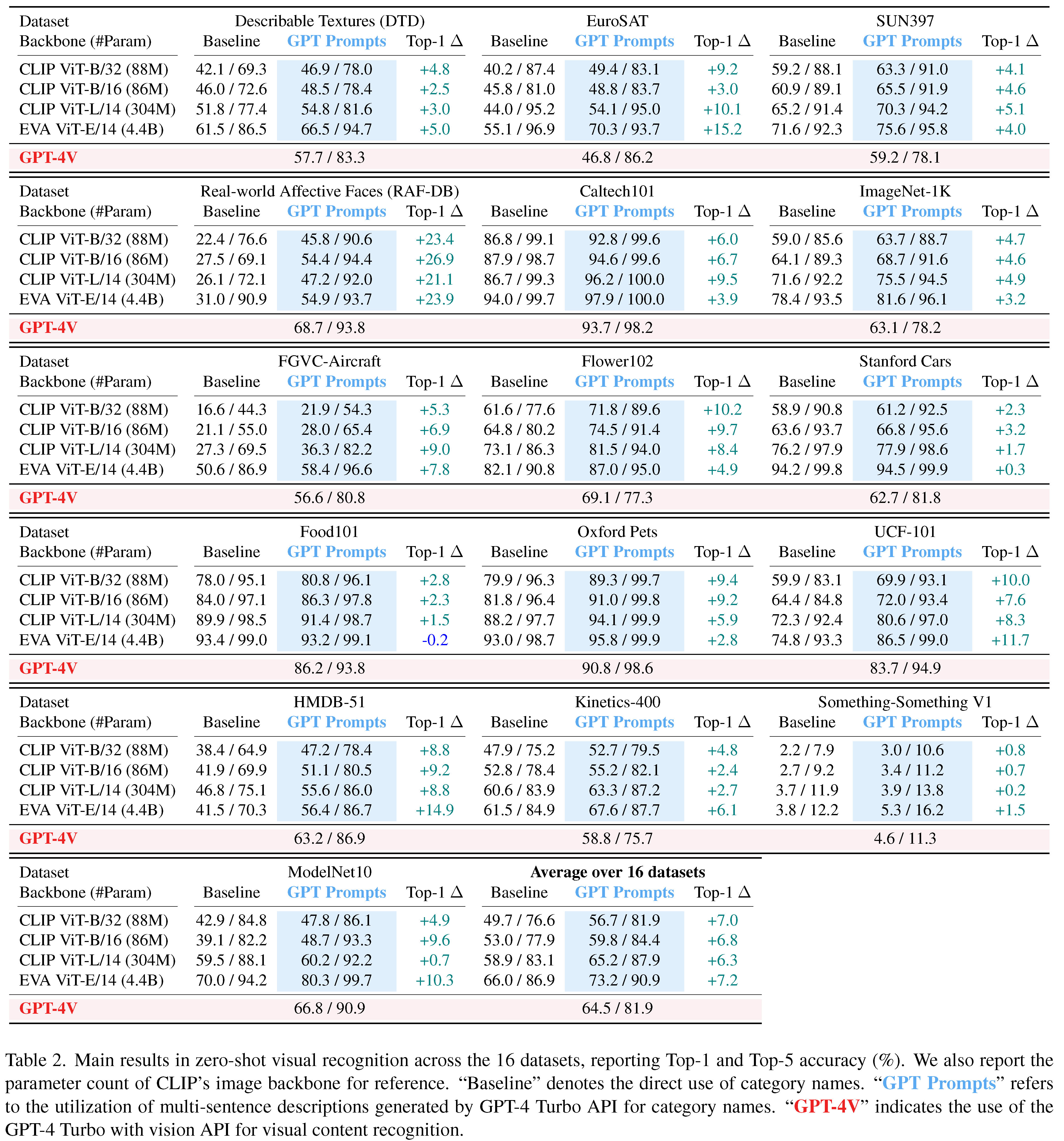

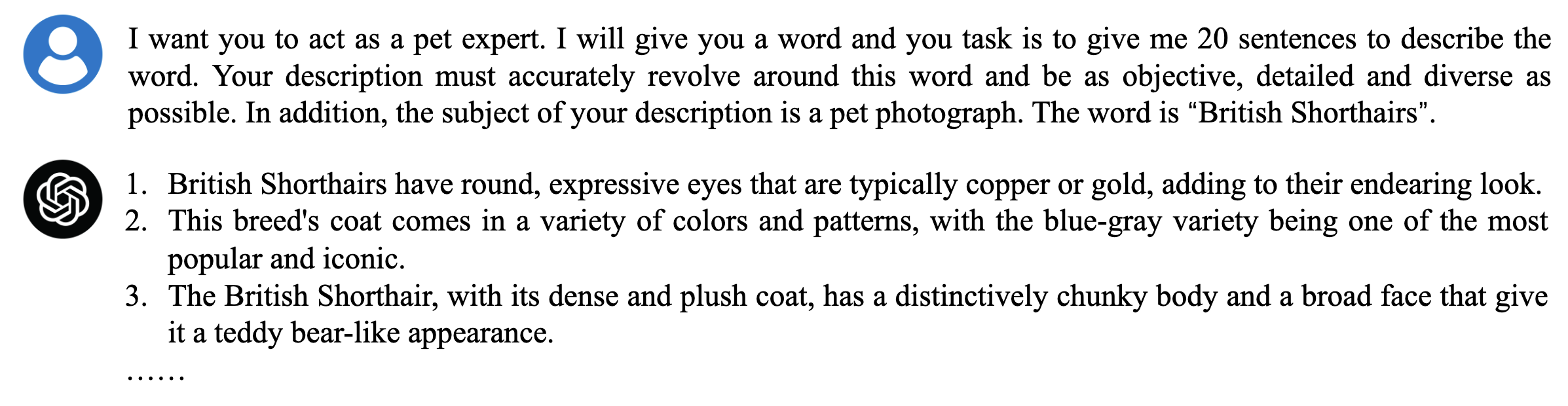

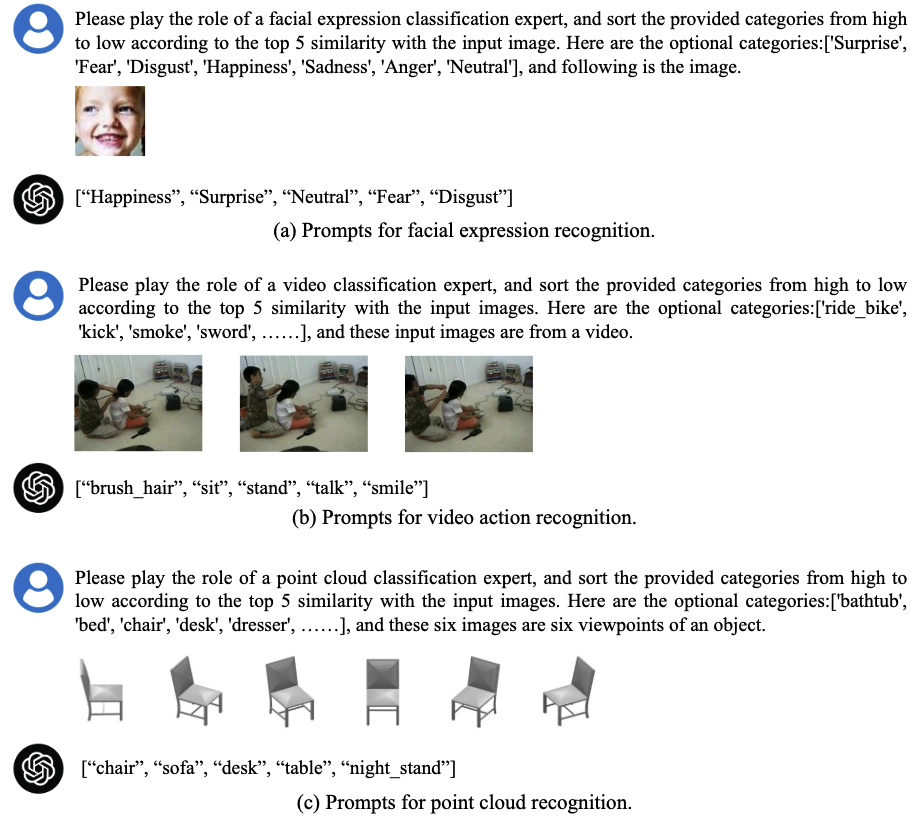

يتحول هذا العمل إلى خط أساسي أساسي ، ولكن يجب أن يعرف في ضوء أحدث التطورات في الذكاء الاصطناعي التوليدي (Genai): استخدام GPT-4 للفهم البصري. نركز على تقييم القدرات اللغوية والبصرية لـ GPT-4 في مهام التعرف المرئي صفراً. لضمان تقييم شامل ، قمنا بإجراء تجارب عبر ثلاث طرائق - التصورات ، مقاطع الفيديو ، والغيوم النقطية - ما مجموعه 16 معيارًا أكاديميًا شعبيًا.

إعادة النظر في المصنف: نقل نماذج لغة الرؤية للتعرف على الفيديو

Wenhao Wu ، Zhun Sun ، Wanli Ouyang

استكشاف المعرفة عبر الوسائط ثنائية الاتجاه للاعتراف بالفيديو مع نماذج لغة الرؤية التي تم تدريبها مسبقًا

Wenhao Wu ، Xiaohan Wang ، Haipeng Luo ، Jingdong Wang ، Yi Yang ، Wanli Ouyang

CAP4VIDEO: ما الذي يمكن أن تفعله التسميات التوضيحية المساعدة لاسترجاع النص النصي؟

Wenhao Wu ، Haipeng Luo ، Bo Fang ، Jingdong Wang ، Wanli Ouyang

قبلت CVPR 2023 AS؟ تسليط الضوء؟ |

التعرف المرئي صفريًا على الاستفادة من القدرات اللغوية والبصرية لـ GPT-4.

لدينا جمل وصفية تم إنشاؤها مسبقًا لجميع الفئات عبر مجموعات البيانات ، والتي يمكنك العثور عليها في مجلد GPT_Generated_Prompts . استمتع بالاستكشاف!

لقد قدمنا أيضًا برنامج النصي المثال لمساعدتك في إنشاء أوصاف باستخدام GPT-4. للحصول على إرشادات حول هذا ، يرجى الرجوع إلى ملف cenery_prompt.py. ترميز سعيد! يرجى الرجوع إلى مجلد التكوين للحصول على معلومات مفصلة عن جميع مجموعات البيانات المستخدمة في مشروعنا.

قم بتنفيذ الأمر التالي لإنشاء أوصاف مع GPT-4.

# To run the script for specific dataset, simply update the following line with the name of the dataset you're working with:

# dataset_name = ["Dataset Name Here"] # e.g., dtd

python generate_prompt.py

نشارك نصيًا مثالًا يوضح كيفية استخدام واجهة برمجة تطبيقات GPT-4V للتنبؤات الصفرية على مجموعة بيانات DTD. يرجى الرجوع إلى ملف gpt4v_zs.py للحصول على دليل خطوة بخطوة حول تنفيذ هذا. نأمل أن يساعدك في البدء بكل سهولة!

# GPT4V zero-shot recognition script.

# dataset_name = ["Dataset Name Here"] # e.g., dtd

python GPT4V_ZS.pyجميع النتائج متوفرة في مجلد GPT4V_ZS_RESULTS ! بالإضافة إلى ذلك ، قدمنا رابط مجموعات البيانات إلى جانب حقائقها المقابلة (مجلد التعليقات التوضيحية ) لمساعدة القراء في تكرار النتائج. ملاحظة: بالنسبة لبعض مجموعات البيانات ، ربما قمنا بإزالة البادئات من معرفات العينة. على سبيل المثال ، في حالة ImageNet ، تم تعديل "ILSVRC2012_VAL_00031094.JPEG" إلى "00031094.jpeg".

| DTD | Eurosat | Sun397 | RAF-DB | Caltech101 | ImageNet-1k | FGVC-AIRCRAFT | Flower102 |

|---|---|---|---|---|---|---|---|

| 57.7 | 46.8 | 59.2 | 68.7 | 93.7 | 63.1 | 56.6 | 69.1 |

| ملصق | ملصق | ملصق | ملصق | ملصق | ملصق | ملصق | ملصق |

| سيارات ستانفورد | Food101 | الحيوانات الأليفة أكسفورد | UCF-101 | HMDB-51 | حركية-400 | ModelNet-10 |

|---|---|---|---|---|---|---|

| 62.7 | 86.2 | 90.8 | 83.7 | 58.8 | 58.8 | 66.9 |

| ملصق | ملصق | ملصق | ملصق | ملصق | ملصق | ملصق |

مع ملفات التنبؤ والتعليقات المتوفرة المقدمة ، يمكنك إعادة إنتاج نتائج الدقة الأولى -1/أعلى 5 مع البرنامج النصي COLACUTER_ACC.PY.

# pred_json_path = 'GPT4V_ZS_Results/imagenet.json'

# gt_json_path = 'annotations/imagenet_gt.json'

python calculate_acc.pyللحصول على إرشادات حول إعداد وتشغيل واجهة برمجة تطبيقات GPT-4 ، نوصي بمراجعة وثائق Openai QuickStart الرسمية المتاحة على: Openai QuickStart Guide.

إذا كنت تستخدم التعليمات البرمجية الخاصة بنا في بحثك أو ترغب في الرجوع إلى النتائج ، فالرجاء نجمة؟ هذا الريبو واستخدام bibtex التالي؟ دخول.

@article { GPT4Vis ,

title = { GPT4Vis: What Can GPT-4 Do for Zero-shot Visual Recognition? } ,

author = { Wu, Wenhao and Yao, Huanjin and Zhang, Mengxi and Song, Yuxin and Ouyang, Wanli and Wang, Jingdong } ,

booktitle = { arXiv preprint arXiv:2311.15732 } ,

year = { 2023 }

}هذا التقييم مبني على الأعمال الممتازة:

نوسع امتناننا الصادق لهؤلاء المساهمين.

لأي أسئلة ، لا تتردد في تقديم مشكلة.