BERTweet

1.0.0

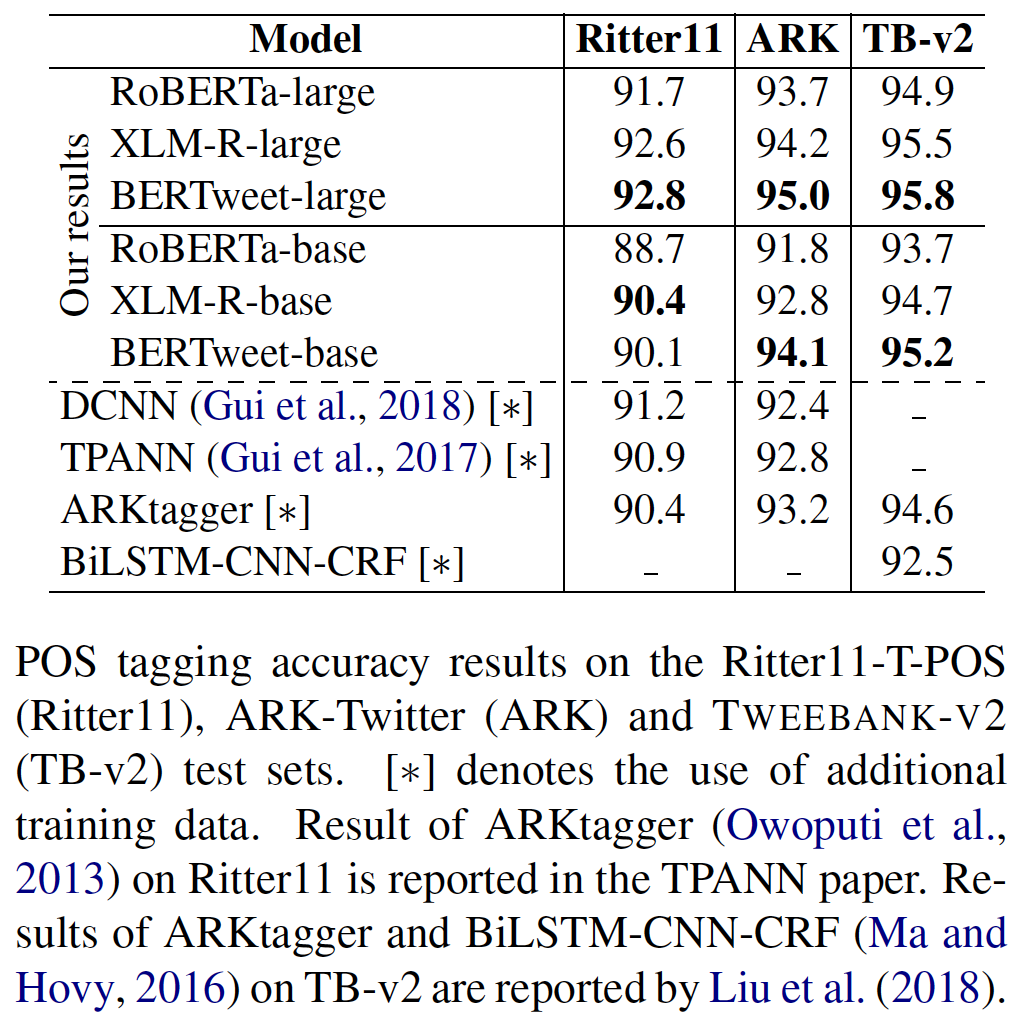

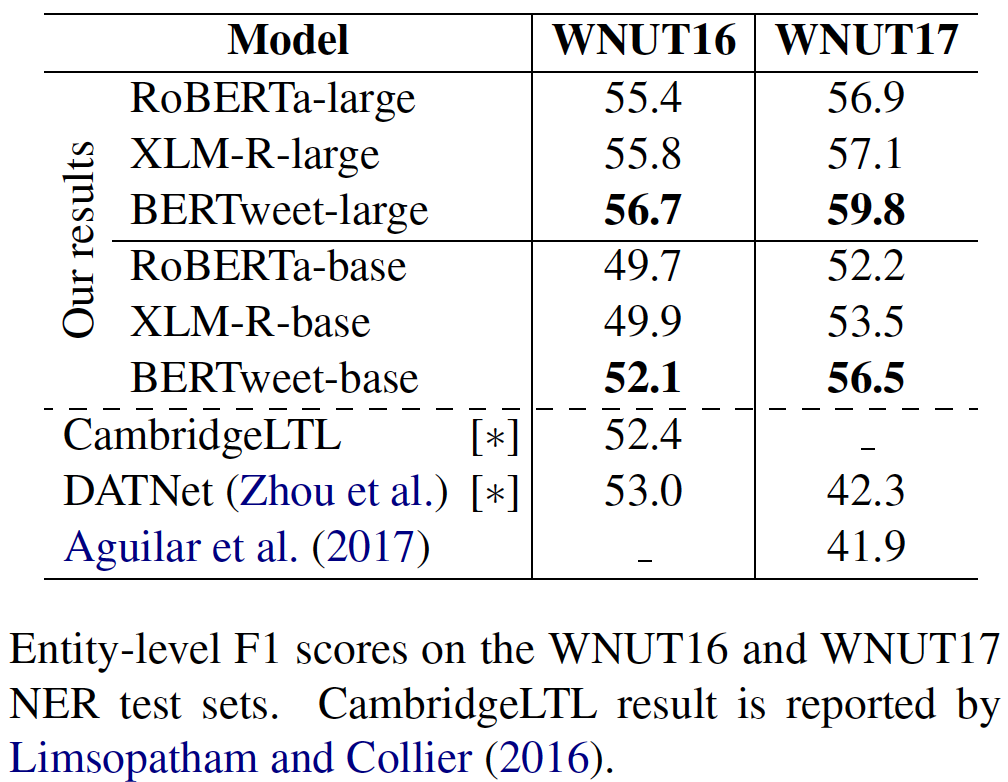

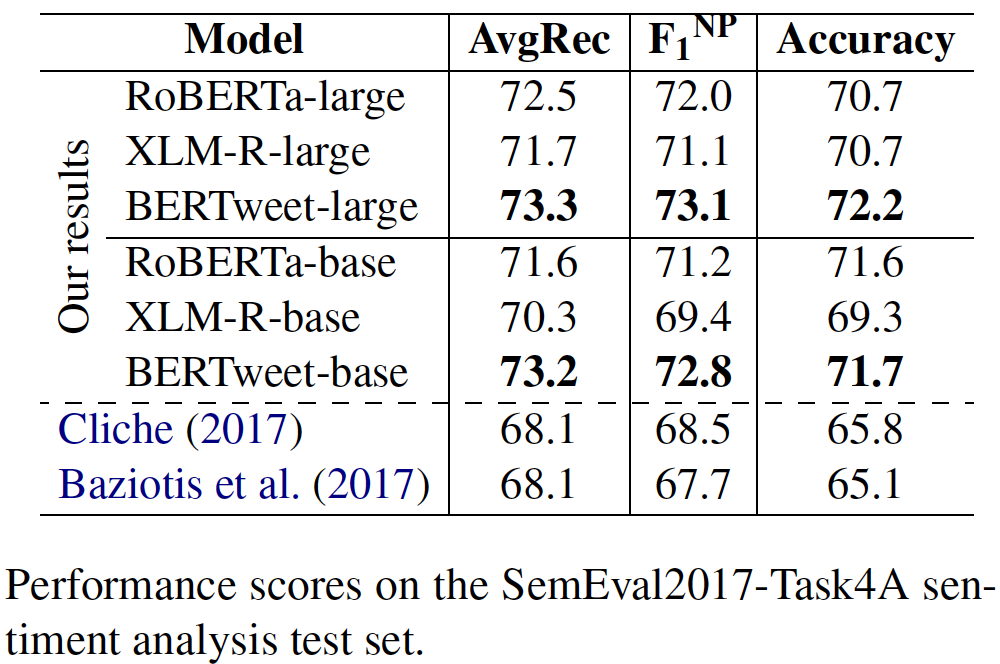

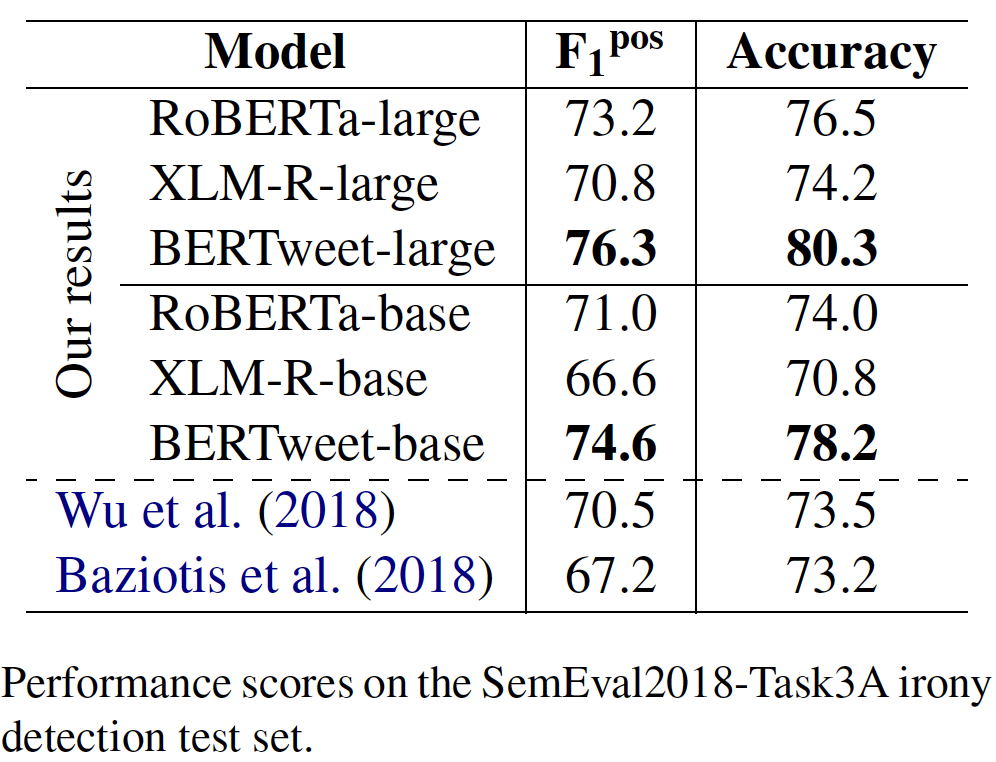

transformersでbertweetを使用しますfairseqでbertweetを使用しますBertweetは、英語のツイート用に事前に訓練された最初の公開言語モデルです。 Bertweetは、Roberta Pre-Training手順に基づいて訓練されています。トレイン前のBertweetに使用されるコーパスは、850mの英語のツイート(16Bワードトークン〜80GB)で構成されており、2012年1月から2019年8月8日までにストリーミングされた845mのツイートと、 Covid-19パンデミックに関連する5Mツイートが含まれています。 Bertweetの一般的なアーキテクチャと実験結果は、私たちの論文にあります。

@inproceedings{bertweet,

title = {{BERTweet: A pre-trained language model for English Tweets}},

author = {Dat Quoc Nguyen and Thanh Vu and Anh Tuan Nguyen},

booktitle = {Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing: System Demonstrations},

pages = {9--14},

year = {2020}

}

Bertweetが公開された結果の作成を支援するために使用されたり、他のソフトウェアに組み込まれている場合は、私たちの論文を引用してください。

transformersでbertweetを使用しますtransformersを取り付けます: pip install transformers 、またはソースからtransformersを取り付けます。transformersブランチにマージしたことに注意してください。このプルリクエストで述べたように、Bertweet用の高速トークンザーをマージするプロセスは議論に巻き込まれています。ユーザーが高速トークナイザーを利用したい場合、ユーザーは次のようにtransformersをインストールする場合があります。 git clone --single-branch --branch fast_tokenizers_BARTpho_PhoBERT_BERTweet https://github.com/datquocnguyen/transformers.git

cd transformers

pip3 install -e .

pip3 install tokenizersをインストールしたtokenizersとトークンをインストールします| モデル | #params | アーチ。 | 最大長 | トレーニング前のデータ |

|---|---|---|---|---|

vinai/bertweet-base | 135m | ベース | 128 | 850mの英語のツイート(ケース) |

vinai/bertweet-covid19-base-cased | 135m | ベース | 128 | 23M Covid-19英語のツイート(ケース) |

vinai/bertweet-covid19-base-uncased | 135m | ベース | 128 | 23M Covid-19英語のツイート(覆われている) |

vinai/bertweet-large | 355m | 大きい | 512 | 873m英語のツイート(ケース) |

vinai/bertweet-covid19-base-cased and vinai/bertweet-covid19-base-uncasedは、事前に訓練されたモデルvinai/bertweet-baseの23m Covid-19の英語のツイートをさらに事前にトレーニングすることにより結果として生じます。vinai/bertweet-largeリリースしました。 import torch

from transformers import AutoModel , AutoTokenizer

bertweet = AutoModel . from_pretrained ( "vinai/bertweet-large" )

tokenizer = AutoTokenizer . from_pretrained ( "vinai/bertweet-large" )

# INPUT TWEET IS ALREADY NORMALIZED!

line = "DHEC confirms HTTPURL via @USER :crying_face:"

input_ids = torch . tensor ([ tokenizer . encode ( line )])

with torch . no_grad ():

features = bertweet ( input_ids ) # Models outputs are now tuples

## With TensorFlow 2.0+:

# from transformers import TFAutoModel

# bertweet = TFAutoModel.from_pretrained("vinai/bertweet-large")英語のツイートのトレーニング前のコーパスにBPEを適用する前に、NLTKツールキットのTweetTokenizerを使用してこれらのツイートをトークン化し、 emojiパッケージを使用して感情アイコンをテキスト文字列に変換しました(ここでは、各アイコンは単語トークンと呼ばれます)。また、ユーザーの言及とWeb/URLリンクをそれぞれ特別なTokens @USERとHTTPURLに変換することにより、ツイートを正規化しました。したがって、Bertweetベースのダウンストリームアプリケーションに同じ前処理ステップを適用することをお勧めします。

生の入力ツイートを考えると、同じ前処理出力を取得するために、ユーザーはTweetNormalizerモジュールを使用できます。

pip3 install nltk emoji==0.6.0emojiバージョンは0.5.4または0.6.0でなければなりません。新しいemojiバージョンは、絵文字チャートの新しいバージョンに更新されているため、トレーニング前のツイートコーパスの前処理に使用されるものと一致していません。 import torch

from transformers import AutoTokenizer

from TweetNormalizer import normalizeTweet

tokenizer = AutoTokenizer . from_pretrained ( "vinai/bertweet-large" )

line = normalizeTweet ( "DHEC confirms https://postandcourier.com/health/covid19/sc-has-first-two-presumptive-cases-of-coronavirus-dhec-confirms/article_bddfe4ae-5fd3-11ea-9ce4-5f495366cee6.html?utm_medium=social&utm_source=twitter&utm_campaign=user-share… via @postandcourier ?" )

input_ids = torch . tensor ([ tokenizer . encode ( line )])fairseqでbertweetを使用しますこちらの詳細をご覧ください!

MIT License

Copyright (c) 2020-2021 VinAI

Permission is hereby granted, free of charge, to any person obtaining a copy

of this software and associated documentation files (the "Software"), to deal

in the Software without restriction, including without limitation the rights

to use, copy, modify, merge, publish, distribute, sublicense, and/or sell

copies of the Software, and to permit persons to whom the Software is

furnished to do so, subject to the following conditions:

The above copyright notice and this permission notice shall be included in all

copies or substantial portions of the Software.

THE SOFTWARE IS PROVIDED "AS IS", WITHOUT WARRANTY OF ANY KIND, EXPRESS OR

IMPLIED, INCLUDING BUT NOT LIMITED TO THE WARRANTIES OF MERCHANTABILITY,

FITNESS FOR A PARTICULAR PURPOSE AND NONINFRINGEMENT. IN NO EVENT SHALL THE

AUTHORS OR COPYRIGHT HOLDERS BE LIABLE FOR ANY CLAIM, DAMAGES OR OTHER

LIABILITY, WHETHER IN AN ACTION OF CONTRACT, TORT OR OTHERWISE, ARISING FROM,

OUT OF OR IN CONNECTION WITH THE SOFTWARE OR THE USE OR OTHER DEALINGS IN THE

SOFTWARE.