心臓時代シリーズのための解釈可能な事前訓練された変圧器データ:論文へのリンク

このレポには、事前に訓練されたモデルECGPTとPPGPTの両方でトレーニングされたモデルファイルがあり、ArrythmiasとBeat検出のために微調整されたモデルの両方があります。また、生成、解釈可能性、および微調整されたモデルの実装のために設計されたGUIもあります。

この作業では、生成事前訓練を受けたトランス(GPT)フレームワークを定期的な心臓時系列データに適用して、2つの事前に訓練された汎用心臓モデル、つまりPPG-PTとECG-PTを作成します。モデルは、Arrythmiasのスクリーニングなど、さまざまな心臓関連タスクに微調整できます。この作業の大きなエンファシスは、事前に訓練されたモデルが完全に解釈可能であり、この解釈が微調整されたタスクに引き継がれることを示すことです。事前に訓練された変圧器は、次の方法で解釈可能です -

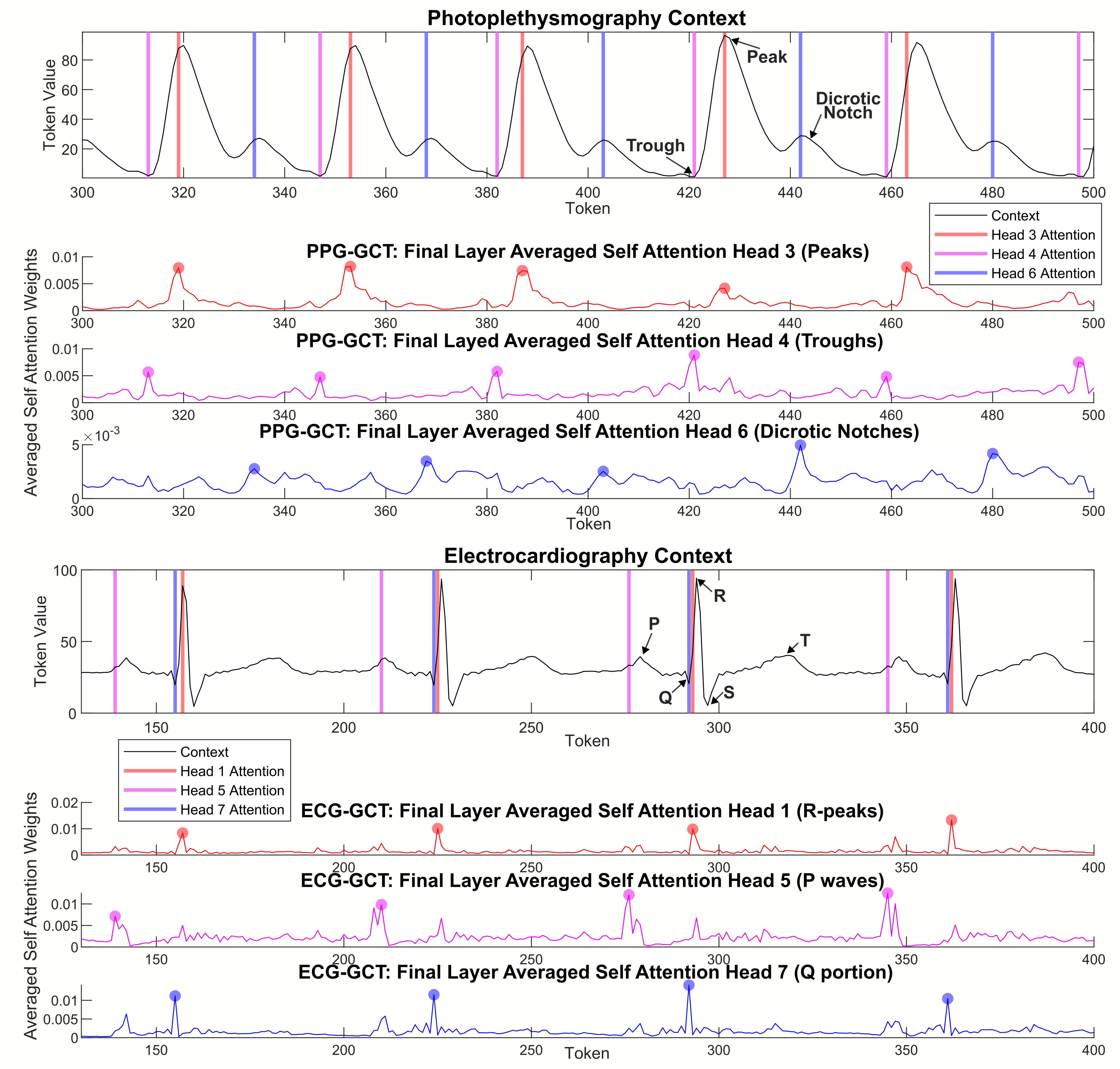

集約的な注意マップは、モデルが以前の心臓サイクルの同様のポイントに焦点を合わせて、予測を行い、より深い層で徐々に注意を広げることを示しています。

ECGおよびPPGサイクルの異なる点で発生する同じ値(同音異義語に相当)のトークンは、トランスブロックを介して他のトークンのコンテキストで更新されるため、心臓サイクルの位置に基づいて、高次元空間で個別のクラスターを形成します。

個々の注意ヘッドは、PPGの二糖ノッチやECGのP波などの特定の生理学的に関連する機能に反応します。

この作品は、Andrej Karpathyによって作成されたチュートリアルに触発されました。

heart_pt_generate.pyは、ECGまたはPPGのいずれかのコンテキストの例でロードされるPythonスクリプトであり、適切なモデルを使用して将来のタイムステップを生成します。

事前に訓練されたPytorchモデルファイルは、ZIPフォルダー( ECGPT_560K_ITERSおよびPPGPT_500K_ITERS )にあります。

例の微調整モデル定義の例は、 「heart_pt_finetune.py」で異なるレイヤーを凍結する方法とともに提供されています。