Transformadores previamente entrenados interpretables para datos de series de tiempo del corazón: enlace al documento

En este repositorio, hay archivos de modelos entrenados, tanto para los modelos previamente capacitados ECGPT como para PPGPT, como los modelos ajustados para aritmias y detección de ritmos. También hay GUI diseñadas para generación, interpretabilidad y para la implementación de los modelos ajustados.

En este trabajo, aplicamos el marco generativo de transformador previamente capacitado (GPT) a datos periódicos de la serie de tiempo cardíaco para crear dos modelos cardíacos de propósito general previamente capacitados, a saber, PPG-PT y ECG-PT. Los modelos son capaces de ser ajustados para muchas tareas diferentes relacionadas con el cardíaco, como la detección de aritmias. Un gran enfasis de este trabajo está demostrando que los modelos previamente capacitados son totalmente interpretables y que esta interpretabilidad se traslada a tareas ajustadas. Los transformadores previamente entrenados son interpretables de las siguientes maneras -

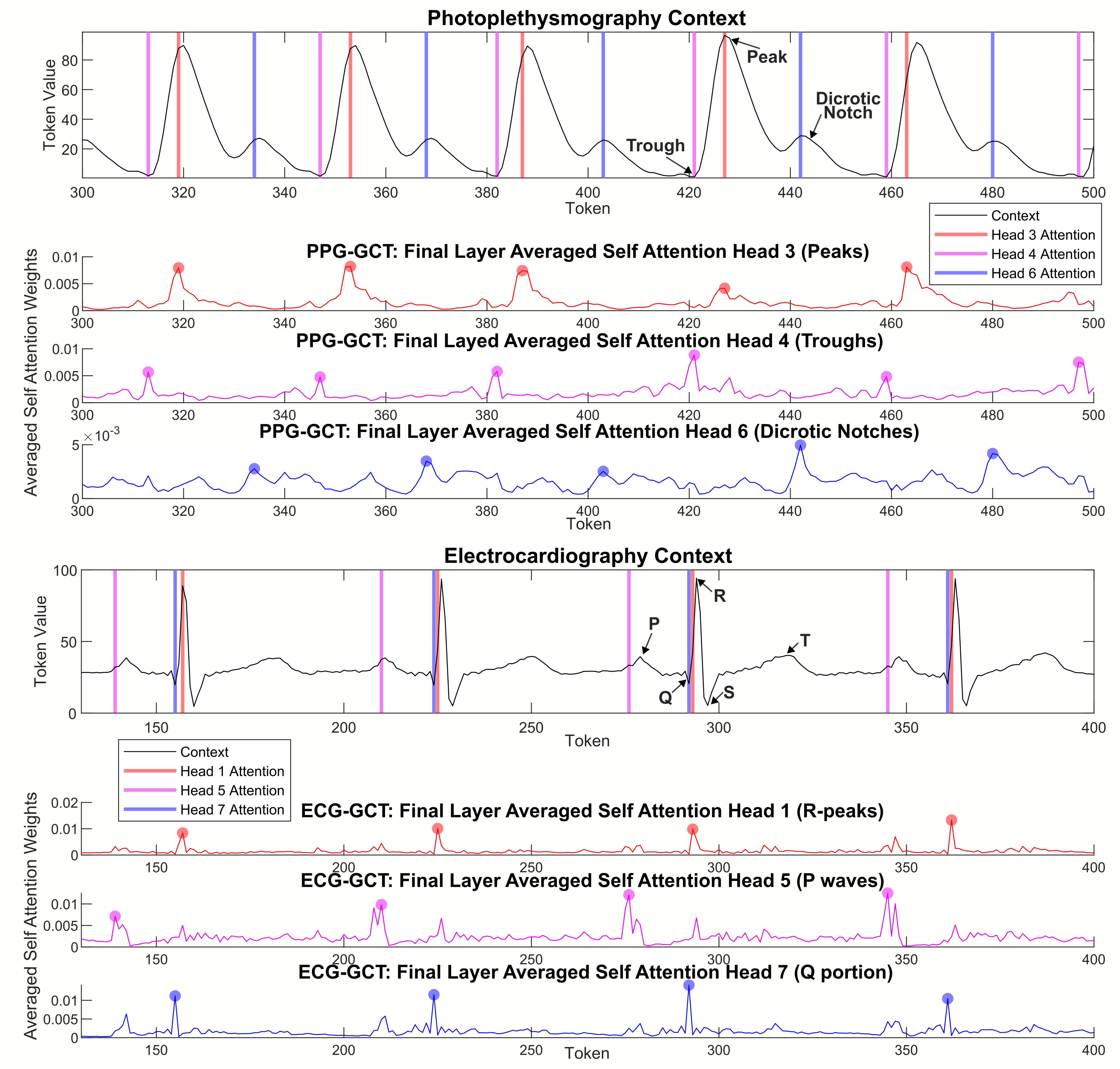

Los mapas de atención agregados muestran que el modelo se centra en puntos similares en ciclos cardíacos anteriores para hacer predicciones y ampliar gradualmente su atención en capas más profundas:

Los tokens con el mismo valor (el equivalente de series de tiempo de un homónimo ) que ocurren en diferentes puntos distintos en el ciclo ECG y PPG forman grupos separados en un espacio de alta dimensión, en función de su posición en el ciclo cardíaco, ya que se actualizan con el contexto de otros tokens a través de los bloques del transformador.

Los cabezas de atención individuales responden a características fisiológicamente relevantes específicas , como la muesca dicrótica en PPG y la onda P en ECG.

Este trabajo se inspiró en un tutorial creado por Andrej Karpathy.

Heart_pt_generate.py es un script de Python que se carga en contextos de ejemplo de ECG o PPG, y utiliza el modelo apropiado para generar pasos de tiempo futuros.

Los archivos del modelo PyTorch previamente entrenado están en carpetas ZIP ( ECGPT_560K_ITERS y PPGPT_500K_ITERS ).

Se proporciona un ejemplo de definición de modelo de ajuste fino en "heart_pt_finetune.py" , junto con cómo congelar diferentes capas.