Transformers pré-formés interprétables pour les données de séries chronologiques cardiaques: lien vers l'article

Dans ce dépôt, il existe des fichiers de modèle formés, à la fois pour les modèles pré-formés ECGPT et PPGPT, et les modèles affinés pour les arrythmias et la détection de battements. Il existe également des GUIS conçus pour la génération, l'interprétabilité et pour la mise en œuvre des modèles affinés.

Dans ce travail, nous appliquons le cadre génératif du transformateur pré-formé (GPT) aux données périodiques des séries chronologiques cardiaques pour créer deux modèles cardiaques à usage général pré-formé, à savoir PPG-PT et ECG-PT. Les modèles sont capables d'être affinés pour de nombreuses tâches cardiaques différentes telles que le dépistage des arrythmias. Une grande éphasie de ce travail est de montrer que les modèles pré-formés sont entièrement interprétables et que cette interprétabilité se comporte dans des tâches de réglage fin. Les transformateurs pré-formés sont interprétables de la manière suivante -

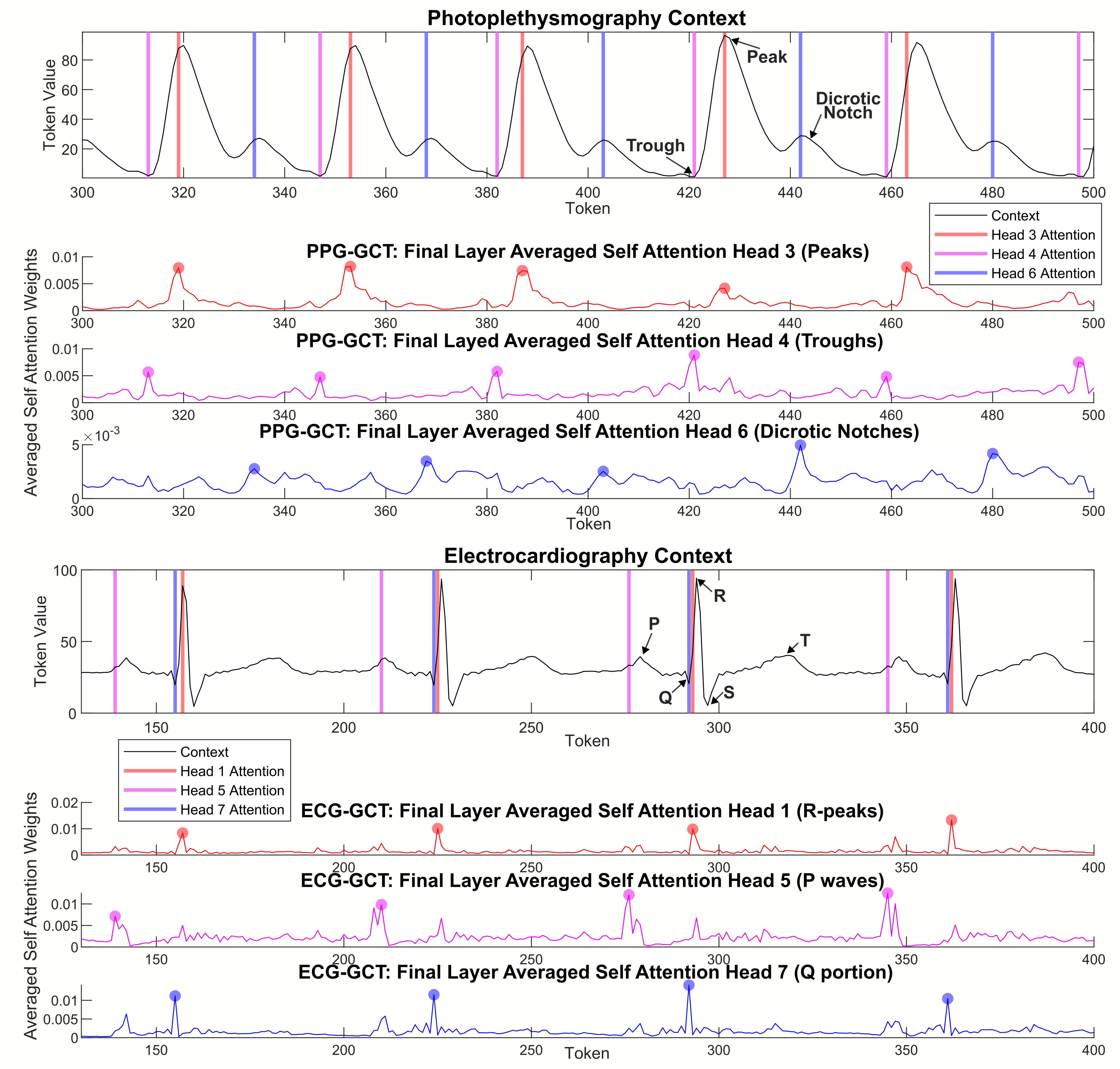

Les cartes d'attention agrégées montrent que le modèle se concentre sur des points similaires dans les cycles cardiaques précédents afin de faire des prédictions et élargit progressivement son attention dans des couches plus profondes:

Les jetons avec la même valeur (l'équivalent de séries chronologiques d'un homonyme ) qui se produisent à différents points distincts du cycle ECG et PPG forment des clusters séparés dans un espace de grande dimension, en fonction de leur position dans le cycle cardiaque, car ils sont mis à jour avec le contexte d'autres jetons via les blocs de transformateur.

Les têtes d'attention individuelles réagissent à des caractéristiques physiologiquement pertinentes spécifiques , telles que l'encoche dicrotique dans PPG et la P-Wave dans ECG.

Ce travail a été inspiré par un tutoriel créé par Andrej Karpathy.

Heart_pt_generate.py est un script python qui se charge dans des exemples de contextes d'ECG ou de PPG, et utilise le modèle approprié pour générer des pas de temps futurs.

Les fichiers de modèle Pytorch pré-formés sont dans les dossiers ZIP ( ECGPT_560K_ITERS et PPGPT_500K_ITERS ).

Un exemple de définition de modèle de réglage fin adapté est fourni dans "heart_pt_finetune.py" , ainsi que comment congeler différentes couches.