Le 24 février 2024, une percée importante a été faite dans le domaine de l'intelligence artificielle. Le modèle d'inférence à l'échelle moyenne Tiny-R1-32B-Preview développé conjointement par l'équipe 360 Intelligent Brain et l'Université de Pékin a été officiellement publié. Avec son seul volume de paramètres de 5%, ce modèle innovant aborde avec succès les performances en toute santé de Deepseek-R1-671B, ouvrant de nouvelles possibilités pour le domaine du raisonnement efficace.

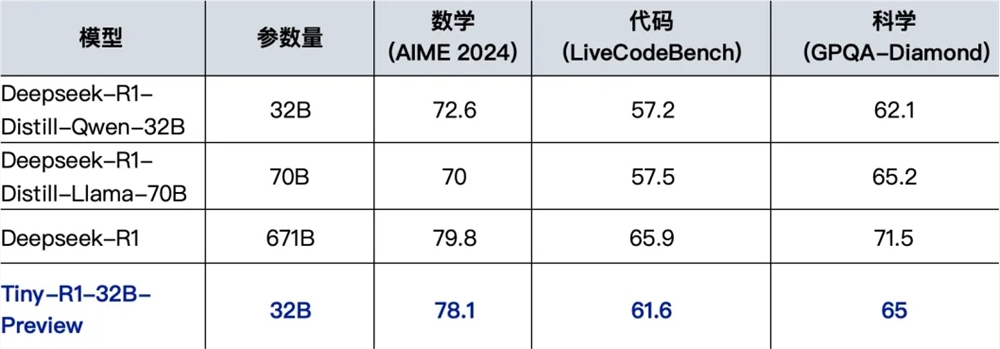

Dans les tests de performances, Tiny-R1-32B-Preview a montré des performances impressionnantes. Surtout dans le domaine des mathématiques, le modèle a obtenu un excellent score de 78,1 dans la revue AIME2024, qui est à seulement 1,7 points du score de 79,8 du modèle R1 d'origine, et est également considérablement en avance sur le score 70,0 du Deepseek-R1-Distill-Llama-70b. Dans les domaines de la programmation et de la science, le modèle a également bien fonctionné, atteignant 61,6 et 65,0 points dans les tests Livecodebench et GPQA-Diamond, respectivement, dépassant le modèle 70b open source 70b actuel. Cette série de réalisations prouve non seulement les excellentes performances de la prévision Tiny-R1-32B, mais obtient également une amélioration significative de l'efficacité en réduisant considérablement les coûts d'inférence.

Derrière ce résultat révolutionnaire se trouve la stratégie innovante de l'équipe de recherche "diviser et convergente l'intégration". Cette stratégie génère d'abord des données de terrain massives basées sur Deepseek-R1 et forme des modèles professionnels dans les trois domaines verticaux des mathématiques, de la programmation et de la science. Par la suite, l'équipe de recherche a utilisé l'outil Mergekit de l'équipe ARCEE pour l'intégration intelligente, réussi à franchir la limite de performance d'un seul modèle et à réaliser une optimisation équilibrée des multiples tâches. Ce chemin technique innovant améliore non seulement considérablement les performances globales du modèle, mais fournit également de nouvelles idées et orientations pour le développement futur de modèles d'inférence.

L'équipe 360 intelligente du cerveau et l'équipe conjointe de R&D de l'Université de Pékin ont particulièrement souligné que le succès de Tiny-R1-32B-Preview est inséparable du fort soutien de la communauté open source. Ce modèle bénéficie entièrement de la technologie de distillation Deepseek-R1, de la formation incrémentielle Deepseek-R1-Distill-32B et de la technologie de fusion de modèle avancée. L'accumulation de ces réalisations techniques a jeté une base solide pour le développement de modèles.

Pour promouvoir l'inclusivité technologique, l'équipe de R&D promet de divulguer un entrepôt complet du modèle, y compris des rapports techniques détaillés, des codes de formation et certains ensembles de données. À l'heure actuelle, l'entrepôt de modèles a été officiellement lancé sur la plate-forme de visage étreint, et l'adresse d'accès est https://huggingface.co/qihoo360/tinyr1-32b-preview. Cette initiative ouverte fournira des ressources précieuses à la communauté de la recherche sur l'intelligence artificielle et promenera le développement ultérieur de technologies connexes.