Am 24. Februar 2024 wurde im Bereich der künstlichen Intelligenz ein wichtiger Durchbruch erzielt. Das mittelgroße Inferenzmodell Tiny-R1-32B-Präview wurde gemeinsam vom 360 intelligenten Gehirnteam und der Peking University entwickelt. Dieses innovative Modell nähert sich mit nur einem Parametervolumen von 5% der vollständigen Leistung von Deepseek-R1-671B erfolgreich und eröffnet neue Möglichkeiten für das Gebiet des effizienten Denkens.

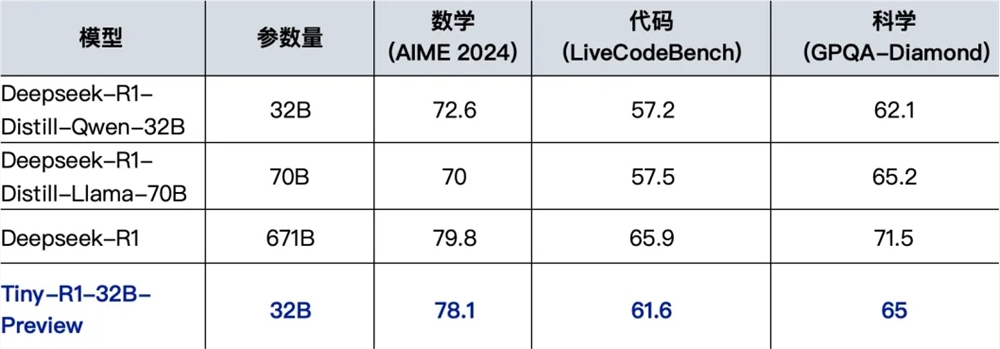

Bei Leistungstests zeigte Tiny-R1-32B-Präview eine beeindruckende Leistung. Insbesondere auf dem Gebiet der Mathematik erzielte das Modell im Aime2024-Überblick eine hervorragende Punktzahl von 78,1, was nur 1,7 Punkte von der 79,8-Punktzahl des ursprünglichen R1-Modells entfernt ist und ebenfalls erheblich vor der 70,0-Punktzahl des Deepseek-R1-Distill-Llama-70b liegt. In den Bereichen Programme und Wissenschaft erzielte das Modell auch gut und erzielte 61,6 und 65,0 Punkte in LiveCodebench- und GPQA-Diamond-Tests, wobei das aktuell beste Open Source 70B-Modell übertrifft. Diese Serie von Errungenschaften beweist nicht nur die hervorragende Leistung von Tiny-R1-32B-Präview, sondern erreicht auch eine signifikante Verbesserung der Effizienz, indem die Inferenzkosten erheblich gesenkt werden.

Hinter diesem Durchbruch steht die innovative Strategie "Dividing und Converging-Integration" des Forschungsteams. Diese Strategie generiert zunächst massive Felddaten basierend auf Deepseek-R1 und schult professionelle Modelle in den drei vertikalen Bereichen Mathematik, Programmierung und Wissenschaft. Anschließend verwendete das Forschungsteam das Mergekit-Tool des ARCEE-Teams zur intelligenten Integration, wobei die Leistungsgrenze eines einzelnen Modells erfolgreich durchbrach und eine ausgewogene Optimierung von Multitasks erreicht hat. Dieser innovative technische Weg verbessert nicht nur die Gesamtleistung des Modells erheblich, sondern bietet auch neue Ideen und Anweisungen für die zukünftige Entwicklung von Inferenzmodellen.

Das 360 intelligente Gehirnteam und das gemeinsame F & E-Team der Peking University betonten besonders, dass der Erfolg von Tiny-R1-32B-Präview mit der starken Unterstützung der Open-Source-Community untrennbar miteinander verbunden ist. Dieses Modell profitiert vollständig von der Destillationstechnologie von Deepseek-R1, Deepseek-R1-Distill-32b inkrementell und fortschrittlicher Modellfusionstechnologie. Die Akkumulation dieser technischen Errungenschaften hat eine solide Grundlage für die Entwicklung von Modellen gelegt.

Um die Inklusivität der Technologie zu fördern, verspricht das F & E -Team, ein vollständiges Modelllager zu offenbaren, einschließlich detaillierter technischer Berichte, Schulungscodes und einigen Datensätzen. Gegenwärtig wurde das Modelllager offiziell auf der umarmenden Face-Plattform gestartet, und die Zugangsadresse lautet https://huggingface.co/qihoo360/tinyr1-32b-preview. Diese offene Initiative wird der Forschungsgemeinschaft der künstlichen Intelligenz -Forschungsgemeinschaft wertvolle Ressourcen zur Verfügung stellen und die Weiterentwicklung verwandter Technologien fördern.