Jugando con el habla a texto y el texto de Android; Configurar una palabra de atención que no sea OK Google e intentar coincidir con el texto convertido con una ontología dada

Bueno, uno de nuestros clientes quería que un asistente virtual sea de manos libres para manejar pedidos como 'Enviarme un montón de Product-X la próxima semana', 'Enviar lo mismo que la semana pasada' o '¿Dónde mis cosas?' Algo así como Amazon's Echo o Google Home

Nuestra idea era crear un objeto impreso en 3D que ocultara una Raspberry Pi dentro que manejaría las interacciones de voz y eventualmente realizaría llamadas de descanso a los servicios de CRM o lo que sea y luego volver a traducir el texto al habla.

Como primer prototipo, configuramos una aplicación de Android que haría todo esto, dado que la API de Android proporciona ambos discursos para enviar un mensaje de texto al habla, hay un altavoz y un micrófono ya integrado y no tendríamos que lidiar con cosas de hardware desde el principio.

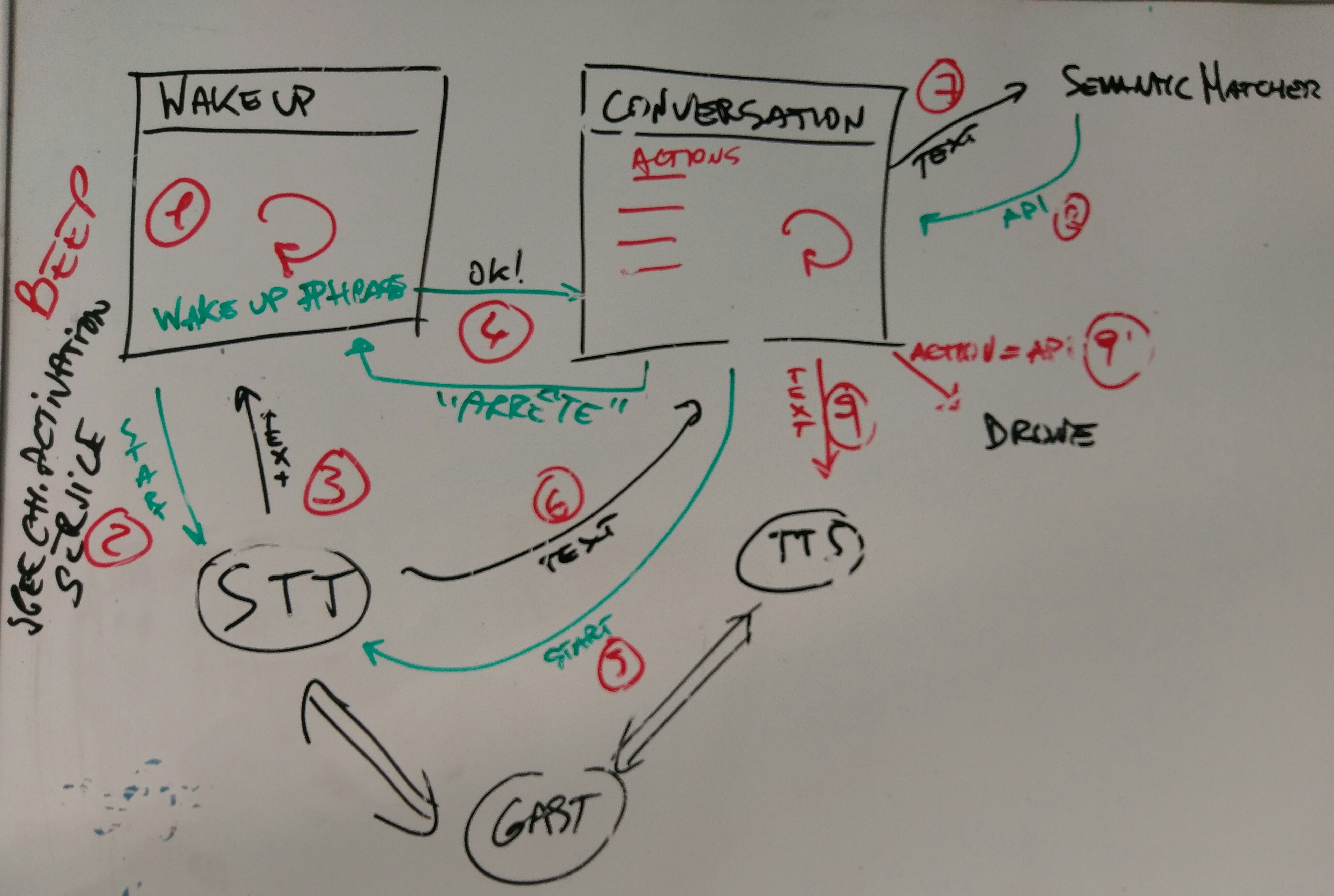

Por lo tanto, hemos creado una aplicación Android que tiene 2 pasos/acciones/pantallas: primero un receptor infinito de palabras de atención (a la "Ok Google") y segundo, un receptor de comando que coincide con el texto reconocido con un conjunto de acciones dadas.

Para nuestro pequeño prototipo, nos preparamos para enviar comandos a un pequeño dron en forma de "¡Hey Robot -> Do un salto de longitud!/¡Avance un poco/gire a la derecha y gire!"

Las acciones se definieron a través de un archivo de ontología, creado a través del proyecto de ontología de Stanford 'protegido'

Una vez que el texto se reconoce a través de la API del habla de Android, (muy básicamente) buscamos acciones en la ontología que a su vez responde con un método API. ¡El método API se ejecuta y nuestra implementación actual hace que nuestro dron se mueva!

Bueno, hay un montón de cosas que nos gustaría hacer: