Jouer avec la parole d'Android et le texte et le texte-parole; Configuration d'un mot de réveil autre que OK Google, et essayant de faire correspondre le texte converti en une ontologie donnée

Eh bien, l'un de nos clients voulait un assistant virtuel mains libres pour gérer les commandes comme «Envoyez-moi un tas de produit-X la semaine prochaine», «Envoyez la même semaine que la semaine dernière» ou «où mes affaires ?! Un peu comme l'écho d'Amazon ou Google Home

Notre idée était de créer un objet imprimé en 3D qui masquerait un Pi à Raspberry à l'intérieur qui gérerait les interactions vocales et finirait par faire des appels de repos aux services CRM ou quoi que ce soit, puis de rétradasser le texte à la parole.

En tant que premier prototype, nous avons mis en place une application Android qui ferait tout cela, étant donné que l'API d'Android fournit à la fois un discours pour envoyer un texte à un discours hors de la boîte, il y a un haut-parleur et un microphone déjà intégré et nous n'aurions pas à faire face à des trucs matériels depuis le début.

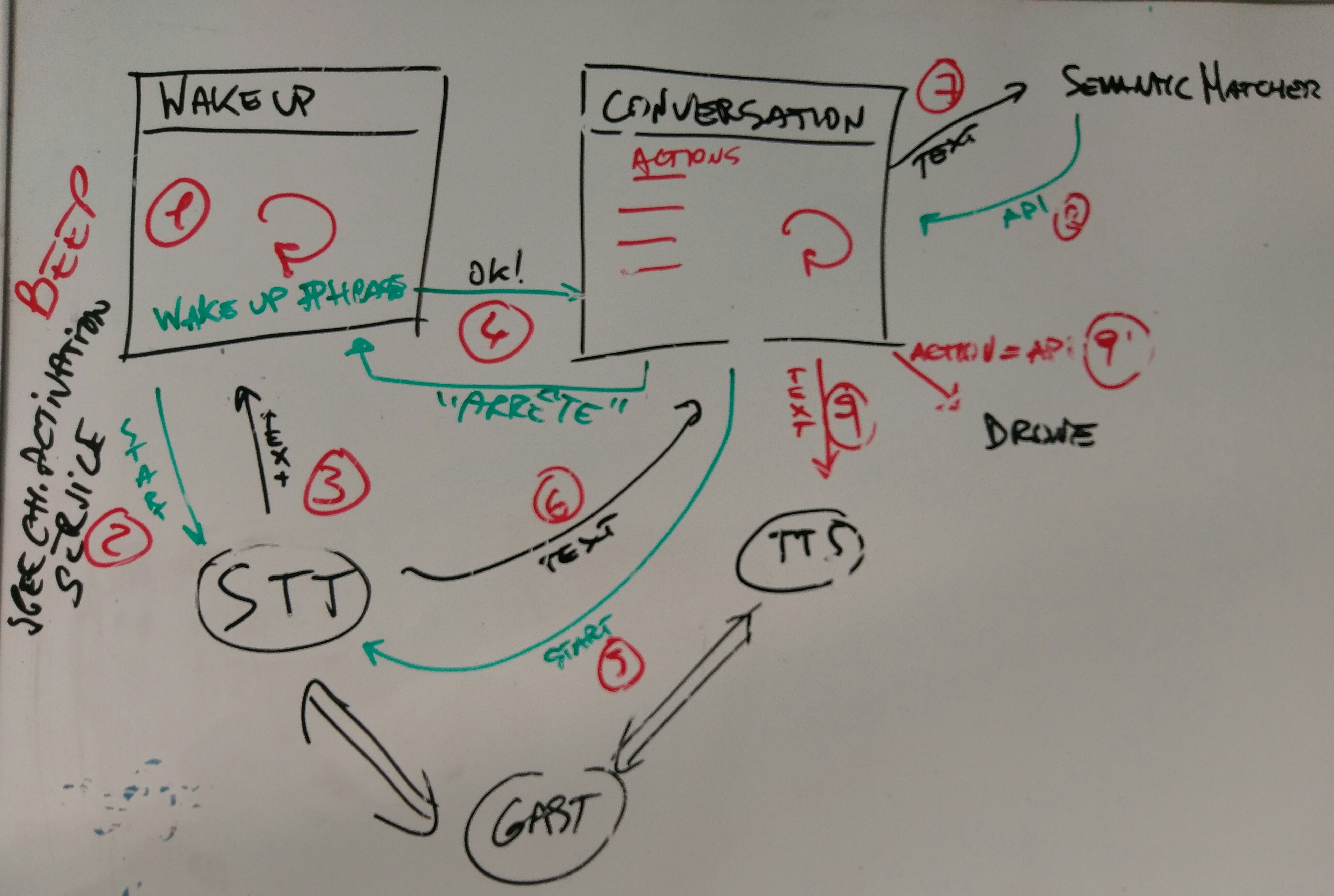

Ainsi, nous avons créé une application Android qui a 2 étapes / actions / écrans: d'abord un récepteur de mot de réveil infini (LA "OK Google") et deuxièmement, un récepteur de commandes qui correspond au texte reconnu à un ensemble d'actions données.

Pour notre petit prototype, nous sommes partis pour envoyer des commandes à un petit drone sous la forme de "Hey Robot -> Faites un saut en longueur! / Avancez un peu / tournez à droite et tournez!"

Les actions ont été définies via un fichier d'ontologie, créé via le projet d'ontologie de Stanford «Protege»

Une fois le texte reconnu via l'API de la parole d'Android, nous recherchons (très) les actions dans l'ontologie qui répond à son tour avec une méthode d'API. La méthode API est ensuite exécutée et notre implémentation actuelle fait bouger notre drone!

Eh bien, il y a un tas de choses que nous aimerions faire: