Ich aktualisiere diese Codebasis regelmäßig. Bitte senden Sie ein Problem, wenn Sie Fragen haben.

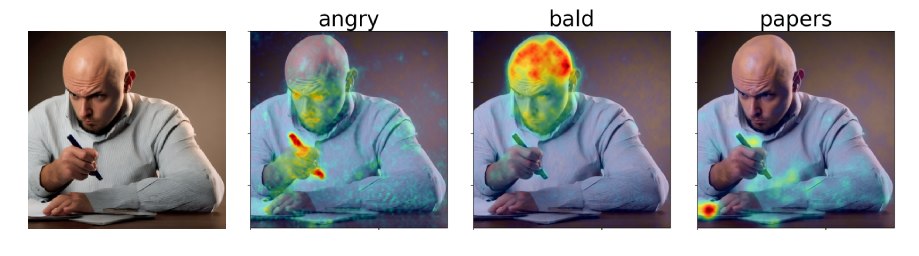

In unserem Artikel schlagen wir Diffusions-Attributionskarten (DAAM) vor, einen aufmerksamkeitsbasierten Ansatz zur Interpretation der stabilen Diffusion. Schauen Sie sich unsere Demo an: https://huggingface.co/spaces/tetrisd/diffusion-attentive-attribution-maps. Siehe unsere Dokumentation, die von Github -Seiten gehostet wird, und unser Colab Notebook, das für v0.1.0 aktualisiert wurde.

Installieren Sie zuerst Pytorch für Ihre Plattform. Installieren Sie DAAM mit pip install daam , es sei denn, Sie möchten eine bearbeitbare Version der Bibliothek. In diesem Fall können git clone https://github.com/castorini/daam && pip install -e daam . Melden Sie sich schließlich mit huggingface-cli login an, um viele stabile Diffusionsmodelle zu erhalten-Sie müssen ein Token auf Huggingface.co erhalten.

Führen Sie einfach daam-demo in einer Shell aus und navigieren Sie zu http: // localhost: 8080. Die gleiche Demo wie die auf Umarmungsflächen wird angezeigt.

DAAM verfügt über ein einfaches Generationskript für Menschen, die es schnell ausprobieren möchten. Versuchen Sie zu rennen

$ mkdir -p daam-test && cd daam-test

$ daam " A dog running across the field. "

$ ls

a.heat_map.png field.heat_map.png generation.pt output.png seed.txt

dog.heat_map.png running.heat_map.png prompt.txt Ihr aktuelles Arbeitsverzeichnis enthält nun das generierte Bild als output.png und eine Daam -Karte für jedes Wort sowie einige Hilfsdaten. Sie können weitere Optionen für daam sehen, indem Sie daam -h ausführen. Um stabile Diffusion XL als Backend zu verwenden, laufen Sie daam --model xl-base-1.0 "Dog jumping" .

DAAM wie folgt importieren und verwenden:

from daam import trace , set_seed

from diffusers import DiffusionPipeline

from matplotlib import pyplot as plt

import torch

model_id = 'stabilityai/stable-diffusion-xl-base-1.0'

device = 'cuda'

pipe = DiffusionPipeline . from_pretrained ( model_id , use_auth_token = True , torch_dtype = torch . float16 , use_safetensors = True , variant = 'fp16' )

pipe = pipe . to ( device )

prompt = 'A dog runs across the field'

gen = set_seed ( 0 ) # for reproducibility

with torch . no_grad ():

with trace ( pipe ) as tc :

out = pipe ( prompt , num_inference_steps = 50 , generator = gen )

heat_map = tc . compute_global_heat_map ()

heat_map = heat_map . compute_word_heat_map ( 'dog' )

heat_map . plot_overlay ( out . images [ 0 ])

plt . show ()Sie können die Daam -Karten auch ziemlich leicht serialisieren und deserialisieren:

from daam import GenerationExperiment , trace

with trace ( pipe ) as tc :

pipe ( 'A dog and a cat' )

exp = tc . to_experiment ( 'experiment-dir' )

exp . save () # experiment-dir now contains all the data and heat maps

exp = GenerationExperiment . load ( 'experiment-dir' ) # load the experiment Wir werden weiterhin Dokumente hinzufügen. In der Zwischenzeit lesen Sie die GenerationExperiment , GlobalHeatMap und DiffusionHeatMapHooker -Klassen sowie die daam/run/*.py -Beispielskripte. Sie können den Coco-Gen-Datensatz unter http://ralphtang.com/coco-gen.tar.gz herunterladen. Wenn Sie auf den Link auf Ihrem Browser klicken, kopieren Sie ihn und fügen Sie ihn in eine neue Registerkarte ein oder verwenden Sie ein CLI -Dienstprogramm wie wget .

DAAM-I2I, eine Erweiterung von Daam auf Bild-zu-Image-Zuordnung.

Furkans Video zum einfachen Einstieg mit Daam.

1LittleCoders Video für eine Codedemonstration und ein Colab -Notizbuch einer älteren Version von DAAM.

@inproceedings{tang2023daam,

title = "What the {DAAM}: Interpreting Stable Diffusion Using Cross Attention",

author = "Tang, Raphael and

Liu, Linqing and

Pandey, Akshat and

Jiang, Zhiying and

Yang, Gefei and

Kumar, Karun and

Stenetorp, Pontus and

Lin, Jimmy and

Ture, Ferhan",

booktitle = "Proceedings of the 61st Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers)",

year = "2023",

url = "https://aclanthology.org/2023.acl-long.310",

}