人工智能领域迎来了一项重大突破,Cohere 公司的非营利研究实验室近日发布了名为Aya Vision 的多模态AI 模型。这一创新成果在行业内引起了广泛关注,被Cohere 誉为当前最先进的技术之一。

Aya Vision 展现了卓越的多功能性能,能够处理包括图像说明生成、照片相关问题解答、文本翻译以及23种主要语言的摘要创作等复杂任务。为了促进全球科研发展,Cohere 通过WhatsApp 平台免费提供这一技术,使世界各地的研究人员都能便捷地接触和利用这一前沿成果。

Cohere 在官方博客中强调,尽管人工智能技术取得了显着进步,但在多语言处理和多模态任务方面仍存在明显差距。 Aya Vision 的研发正是为了突破这一技术瓶颈,推动人工智能在跨语言和跨模态领域的进一步发展。

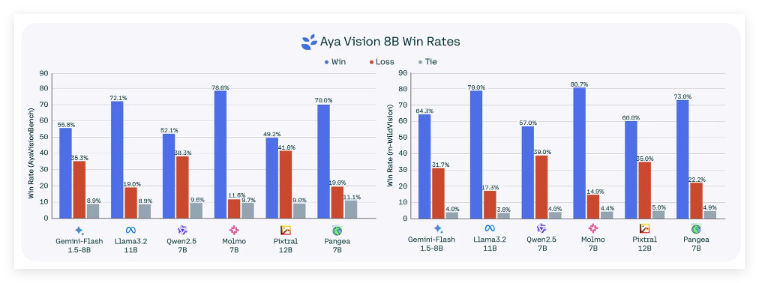

该模型提供两个版本:Aya Vision32B 和Aya Vision8B。其中,Aya Vision32B 在多项视觉理解基准测试中表现优异,甚至超越了体量更大的竞争模型,包括Meta 的Llama-3.290B Vision。而Aya Vision8B 同样表现出色,在某些评估中优于体量为其十倍的模型。

这两个模型已在AI 开发平台Hugging Face 上发布,采用Creative Commons4.0 许可证,用户需遵守Cohere 的可接受使用条款,且仅限于非商业用途。

在训练方法上,Cohere 采用了创新的"多样化"英语数据集,通过翻译和合成标注技术进行模型训练。这种合成标注技术由AI 生成,虽然存在一定局限性,但已被包括OpenAI 在内的多家领先机构采用,显示出其在提升模型性能方面的潜力。

Cohere 表示,采用合成标注技术不仅提高了训练效率,还显着减少了资源消耗,体现了公司在技术创新和资源优化方面的双重优势。

为了支持更深入的研究,Cohere 还推出了全新的基准评估工具AyaVisionBench。该工具专门用于评估模型在视觉与语言结合任务中的表现,如图像差异识别和屏幕截图转代码等复杂功能。

在当前人工智能行业面临"评估危机"的背景下,AyaVisionBench 的推出为模型评估提供了一个更全面、更具挑战性的框架,有望推动行业评估标准的革新。

官方博客:https://cohere.com/blog/aya-vision