人工知能の分野は主要なブレークスルーに導かれ、Cohereの非営利研究所は最近、AYA VisionというマルチモーダルAIモデルをリリースしました。この革新的な成果は、業界で広範な注目を集めており、現在最も高度なテクノロジーの1つとしてCohereに歓迎されています。

AYA Visionは、23の主要言語での画像説明の生成、写真関連の質問、テキスト翻訳、抽象的な作成など、複雑なタスクを処理できる優れた汎用性を示しています。グローバルな科学研究を促進するために、CohereはWhatsAppプラットフォームを通じてこのテクノロジーを無料で提供し、世界中の研究者がこの最先端の成果に簡単にアクセスして利用できるようにします。

彼の公式ブログでは、AIテクノロジーの大幅な進歩にもかかわらず、多言語処理とマルチモーダルタスクには依然として大きなギャップがあるとCohereは強調しています。 AYA Visionの研究開発は、この技術的なボトルネックを突破し、横断的およびクロスモダリティの分野における人工知能のさらなる発展を促進することです。

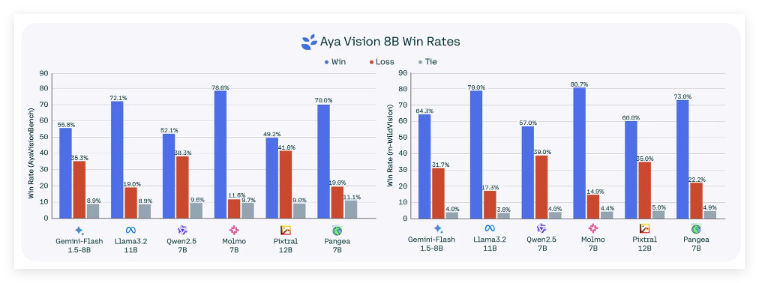

このモデルには、AYA Vision32BとAYA Vision8Bの2つのバージョンがあります。その中で、AYA Vision32Bはいくつかの視覚的理解ベンチマークでうまく機能し、MetaのLlama-3.290Bビジョンを含むより大きな競争モデルを超えています。 AYA Vision8Bもうまく機能し、一部の評価ではそのサイズの10倍のモデルを上回るモデルを上回りました。

これらの2つのモデルは、AI開発プラットフォームでフェイスを抱きしめてリリースされており、Creative Commons4.0の下でライセンスされており、ユーザーはCohereの許容可能な利用規約の対象となり、非営利的な使用に限定されています。

トレーニング方法に関しては、Cohereeは革新的な「多様化された」英語データセットを採用して、翻訳および合成注釈技術を通じてモデルをトレーニングします。この合成注釈技術はAIによって生成されます。特定の制限がありますが、Openaiを含む多くの主要な機関によって採用されており、モデルのパフォーマンスの向上における可能性があります。

Cohereは、合成注釈技術を使用すると、トレーニング効率が向上するだけでなく、技術革新とリソースの最適化における同社の二重の利点を反映して、資源消費を大幅に削減すると述べました。

より詳細な研究をサポートするために、Cohereは新しいベンチマーク評価ツールであるAyavisionBenchも発売しました。このツールは、画像の違い認識やスクリーンショット間の複雑な機能などの視覚的および言語結合タスクにおけるモデルのパフォーマンスを評価するように設計されています。

人工知能業界における現在の「評価危機」を背景に、Ayavisionbenchの立ち上げは、業界評価基準のイノベーションを促進することが期待されるモデル評価のためのより包括的で挑戦的なフレームワークを提供します。

公式ブログ:https://cohere.com/blog/aya-vision