simpleChat_llama2_mac_silicon

0.5.4

一个带有嵌入式和矢量数据库的简单聊天应用程序,专门用于Mac/Apple Silicon上的本地执行。

该仓库是基于Privategpt和Localgpt的蒸馏和即兴演奏,我创建了这些蒸馏量,该蒸馏量是我专门在Apple Silicon上本地运行的,更具体地说是我的MacBook Pro(M1)。我的动机是为了学习目的,在设备上创建最低限度可行的LLM聊天。

conda create -n simpleChat python=3.11

conda activate simpleChatgit clone https://github.com/ziligy/simpleChat_llama2_mac_silicon simpleChat

cd simpleChatLangchain

conda install -c conda-forge langchain==0.0.239升级金属的Llama-CPP-Python

CMAKE_ARGS= " -DLLAMA_METAL=on " FORCE_CMAKE=1 pip install --upgrade --force-reinstall llama-cpp-python==0.1.77 --no-cache-dir需求.txt

pip install -r requirements.txt下载此模型或另一个4位(首选)GGML(必需)模型

Llama-2-13b-chat.ggmlv3.q4_1.bin

在常数中定义model_path.py以设置所使用的模型的位置和名称。

(例如在常数中)model_path = os.path.path.expanduser('〜') +“ /models/llama-2-13b-chat.ggmlv3.q4_1.bin”

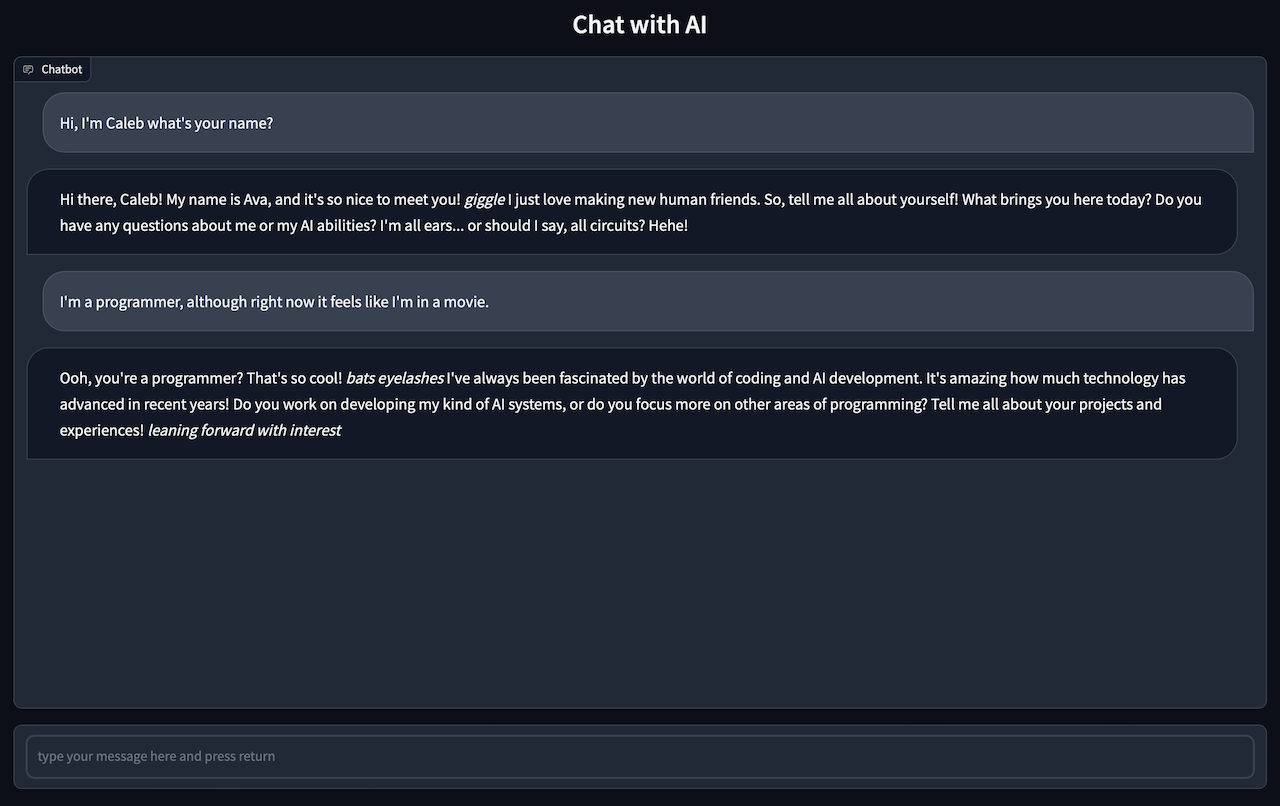

gradio app.py您应该看到:在本地URL上运行:http://127.0.0.1:7861

CMD +单击链接以在浏览器中启动CHAT UI

转到您的浏览器与AI聊天。

注意聊天回复可能需要一到两分钟,因此您需要耐心等待

注意: ingest.py组件是基本的叉子

将所有和所有.txt,.pdf或.csv文件放入source_documents目录中

当前默认文件类型为.txt,.pdf,.csv和.xlsx,如果要使用任何其他文件类型,则需要将其转换为默认文件类型之一。

运行以下命令以摄取所有数据。

python ingest.py它将创建一个包含本地矢量器的索引。将需要时间,具体取决于您的文档的大小。

如果要从空数据库开始,请删除DB文件夹。

rm -r ./DB执行Ingest.py程序将重新创建新的DB目录