Mac/Apple Silicon에서 로컬 실행을 위해 내장 및 벡터 데이터베이스가 포함 된 간단한 채팅 앱.

이 repo는 PrivateGpt 및 LocalGpt를 기반으로 한 증류 및 리프로, Apple Silicon 및보다 구체적으로 MacBook Pro (M1)에서 독점적으로 실행하도록 만들었습니다. 저의 동기는 학습 목적으로 내 장치에서 완전한 로컬에서 실행되는 최소 실행 가능한 LLM 채팅을 만드는 것이 었습니다.

conda create -n simpleChat python=3.11

conda activate simpleChatgit clone https://github.com/ziligy/simpleChat_llama2_mac_silicon simpleChat

cd simpleChat랭케인

conda install -c conda-forge langchain==0.0.239금속의 Llama-CPP-Python 업그레이드

CMAKE_ARGS= " -DLLAMA_METAL=on " FORCE_CMAKE=1 pip install --upgrade --force-reinstall llama-cpp-python==0.1.77 --no-cache-dir요구 사항 .txt

pip install -r requirements.txt이 모델 또는 다른 4 비트 (선호) GGML (필수) 모델을 다운로드하십시오

llama-2-13b-chat.ggmlv3.q4_1.bin

model_path를 constants.py 에서 정의하여 사용중인 모델의 위치와 이름을 설정하십시오.

(예 : constants.py ) model_path = os.path.expanduser ( '~') + "/models/llama-2-13b-chat.ggmlv33.q4_1.bin"

gradio app.py로컬 URL에서 실행 : http://127.0.0.1:7861

CMD + 브라우저에서 채팅 UI를 시작하려면 링크를 클릭하십시오.

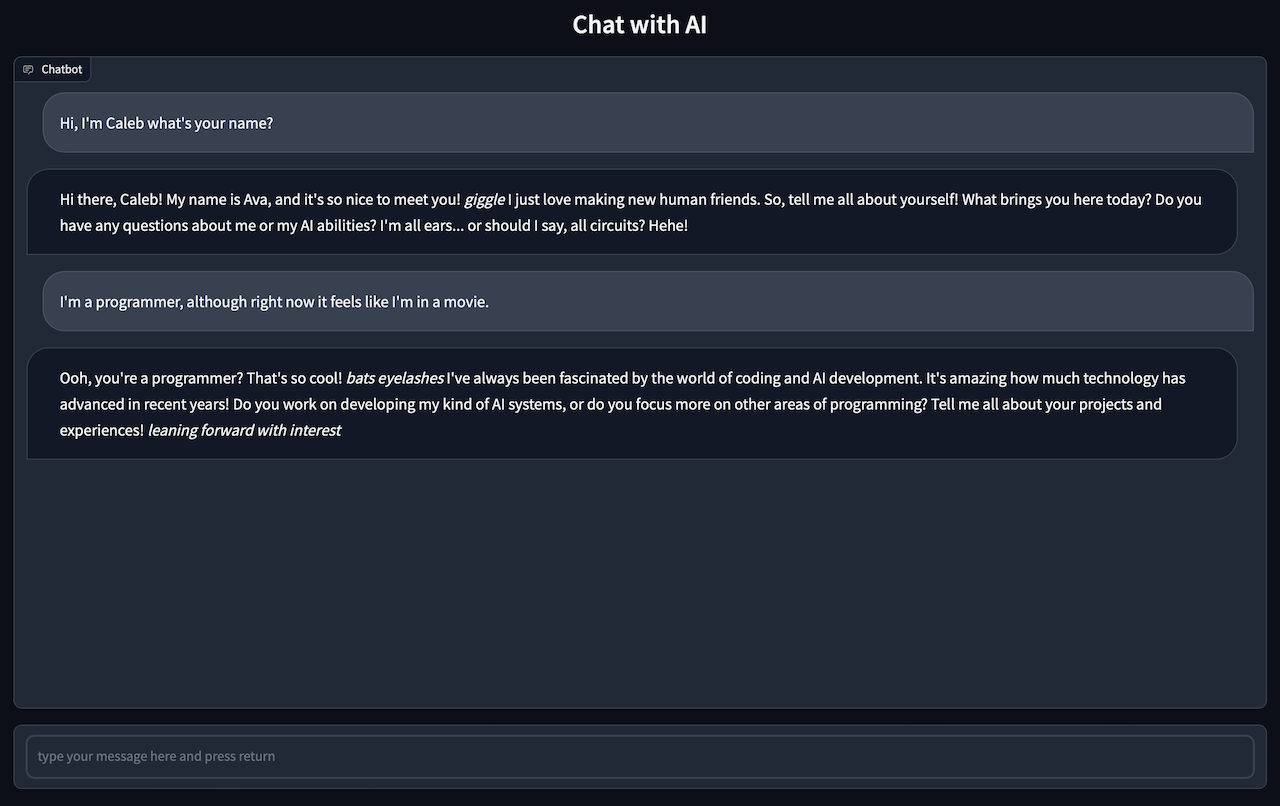

AI와 채팅하려면 브라우저로 이동하십시오.

참고 채팅 응답은 1 ~ 2 분이 걸릴 수 있으므로 인내심을 가져야합니다.

참고 : insest.py 구성 요소는 기본적으로 localgpt의 포크입니다.

.txt, .pdf 또는 .csv 파일을 모두 source_documents 디렉토리에 넣으십시오.

현재 기본 파일 유형은 .txt, .pdf, .csv 및 .xlsx입니다. 다른 파일 유형을 사용하려면 기본 파일 유형 중 하나로 변환해야합니다.

모든 데이터를 수집하려면 다음 명령을 실행하십시오.

python ingest.py로컬 벡터 스토어를 포함하는 색인을 생성합니다. 문서의 규모에 따라 시간이 걸립니다.

빈 데이터베이스에서 시작하려면 DB 폴더를 삭제하십시오.

rm -r ./DBinsest.py 프로그램 실행은 새로운 DB 디렉토리를 재현합니다.