Простое приложение для чата с встроениями и векторной базой данных, исключительно для локального выполнения на кремнии Mac/Apple.

Это репо является дистилляцией и риффом, основанным на приватетегии и локальном уровне, которые я создал, чтобы исключительно работать локально на Apple Silicon и, более конкретно MyCbook Pro (M1). Моя мотивация состояла в том, чтобы создать минимальный жизнеспособный чат LLM, работающий на моем устройстве, в целях обучения.

conda create -n simpleChat python=3.11

conda activate simpleChatgit clone https://github.com/ziligy/simpleChat_llama2_mac_silicon simpleChat

cd simpleChatЛангхейн

conda install -c conda-forge langchain==0.0.239Обновить Llama-Cppp-Python для металла

CMAKE_ARGS= " -DLLAMA_METAL=on " FORCE_CMAKE=1 pip install --upgrade --force-reinstall llama-cpp-python==0.1.77 --no-cache-dirТребования.txt

pip install -r requirements.txtЗагрузите эту модель или еще одну 4-битную (предпочтительную) модель GGML (требуется)

llama-2-13b-chat.ggmlv3.q4_1.bin

Определите model_path в constants.py , чтобы установить местоположение и имя используемой вами модели.

(Например, в constants.py ) model_path = os.path.expanduser ('~') + "/models/llama-2-13b-chat.ggmlv3.q4_1.bin"

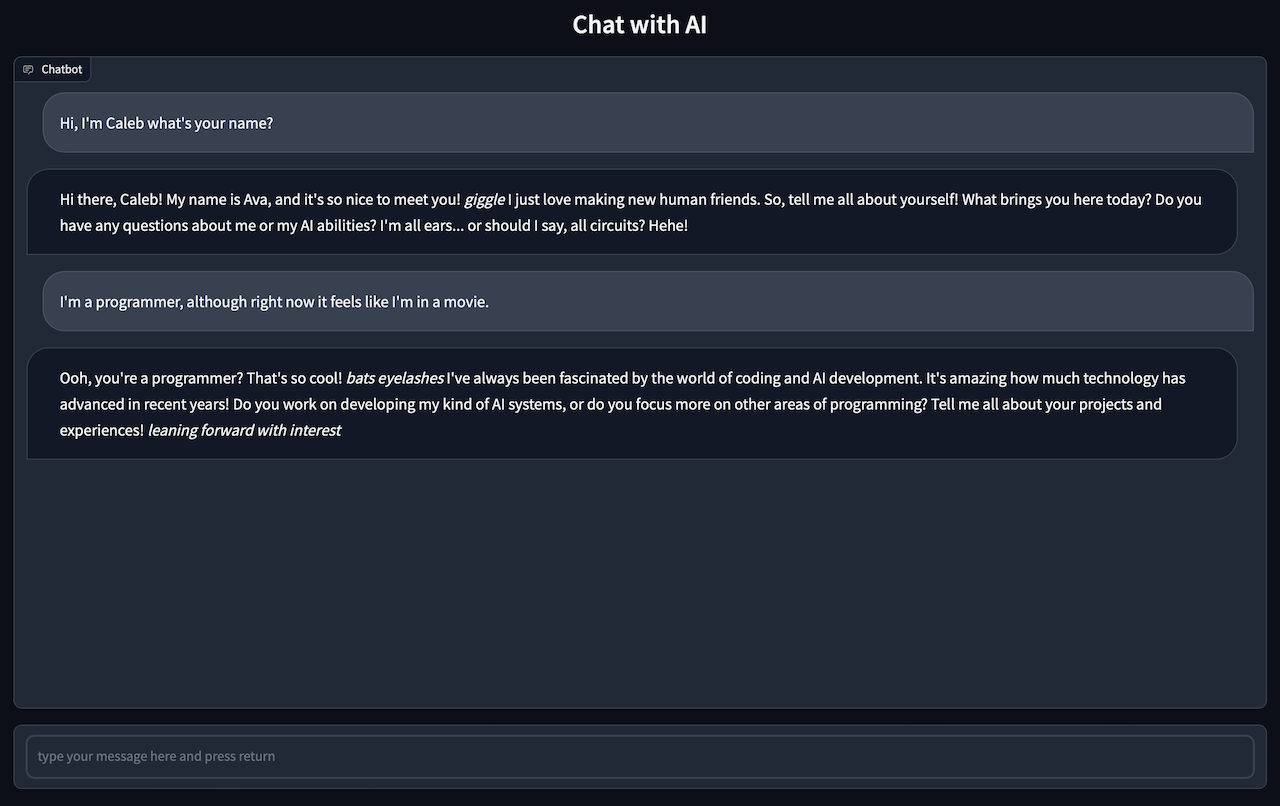

gradio app.pyВы должны увидеть: работа на локальном URL: http://127.0.0.1:7861

CMD + Нажмите на ссылку, чтобы начать пользовательский интерфейс в своем браузере

Пойдите в свой браузер, чтобы поболтать с ИИ.

Примечание Ответы в чате могут занять от одной -двух минут, поэтому вам нужно быть терпеливым

Примечание: компонент Ingent.py в основном является вилкой от LocalGPT

Вставьте все ваши файлы .txt, .pdf или .csv в каталог source_documents

Текущие типы файлов по умолчанию.

Запустите следующую команду для употребления всех данных.

python ingest.pyОн создаст индекс, содержащий локальный векторный магазин. Займет время, в зависимости от размера ваших документов.

Если вы хотите начать из пустой базы данных, удалите папку DB.

rm -r ./DBВыполнение программы Inting.py будет воссоздать свежий каталог DB