تطبيق دردشة بسيط مع تضمينات وقاعدة بيانات المتجهات ، حصريًا للتنفيذ المحلي على سيليكون Mac/Apple.

هذا الريبو هو تقطير و riff يعتمد على PrivateD و LocalGPT الذي أنشأته لتشغيله حصريًا على سيليكون Apple وخاصةً MacBook Pro (M1). كان الدافع الخاص بي هو إنشاء الحد الأدنى لدردشة LLM القابلة للحياة تعمل بشكل كامل على جهازي ، لأغراض التعلم.

conda create -n simpleChat python=3.11

conda activate simpleChatgit clone https://github.com/ziligy/simpleChat_llama2_mac_silicon simpleChat

cd simpleChatلانجشين

conda install -c conda-forge langchain==0.0.239ترقية Llama-CPP-Python للمعادن

CMAKE_ARGS= " -DLLAMA_METAL=on " FORCE_CMAKE=1 pip install --upgrade --force-reinstall llama-cpp-python==0.1.77 --no-cache-dirالمتطلبات

pip install -r requirements.txtقم بتنزيل هذا النموذج أو نموذج GGML (مطلوب) 4 بت (مطلوب)

llama-2-13b-chat.ggmlv3.q4_1.bin

حدد model_path في constants.py لتعيين موقع واسم النموذج الذي تستخدمه.

(على سبيل المثال في Constants.py ) model_path = os.path.expanduser ('~') + "/models/llama-2-13b-ghat.ggmlv3.q4_1.bin"

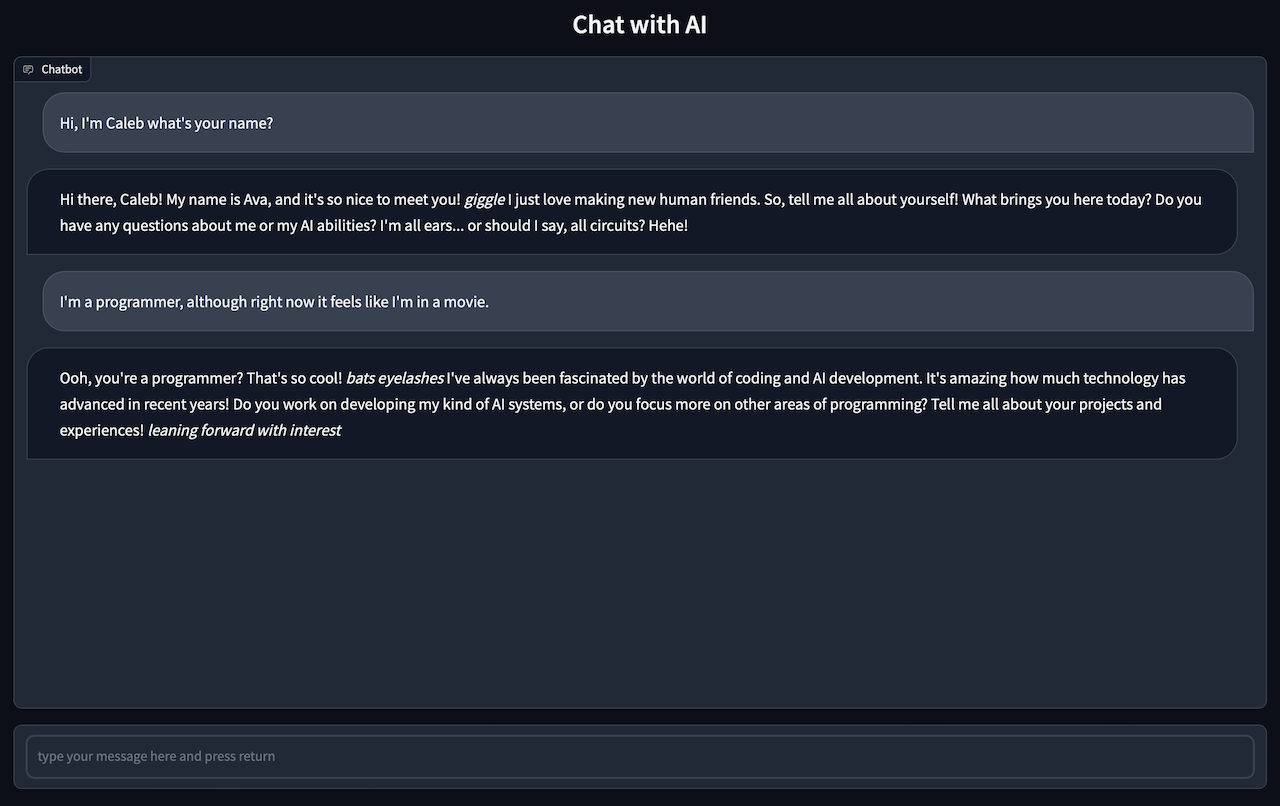

gradio app.pyيجب أن ترى: الجري على عنوان URL المحلي: http://127.0.0.1:7861

CMD + انقر على الرابط لبدء واجهة المستخدم في المتصفح الخاص بك

انتقل إلى متصفحك للدردشة مع الذكاء الاصطناعي.

ملاحظة قد تستغرق ردود الدردشة من دقيقة إلى دقيقتين ، لذلك ستحتاج إلى التحلي بالصبر

ملاحظة: مكون Incest.py هو شوكة من LocalGpt

ضع أي وجميع ملفات .txt أو .pdf أو .csv في دليل Source_Documents

أنواع الملفات الافتراضية الحالية هي .txt و .pdf و .csv و .xlsx ، إذا كنت ترغب في استخدام أي نوع ملف آخر ، فستحتاج إلى تحويله إلى أحد أنواع الملفات الافتراضية.

قم بتشغيل الأمر التالي لتلوين جميع البيانات.

python ingest.pyسيقوم بإنشاء فهرس يحتوي على ناقل المحلي. سوف يستغرق بعض الوقت ، اعتمادًا على حجم مستنداتك.

إذا كنت ترغب في البدء من قاعدة بيانات فارغة ، فاحذف مجلد DB.

rm -r ./DBسيقوم تنفيذ برنامج Ingest.py بإعادة إنشاء دليل DB جديد