通过此项目,您可以使用AI来生成音乐曲目和视频剪辑。提供一些有关您想要音乐和视频的信息,代码将完成其余的信息。

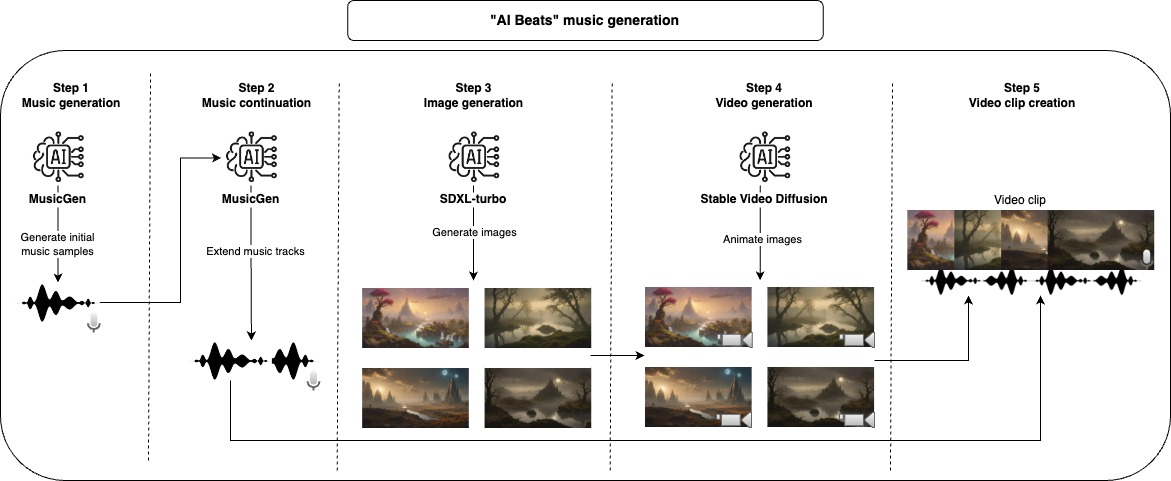

首先,我们使用生成模型来创建音乐样本,此处使用的默认模型只能生成最高30秒的音乐,因此,我们采取了另一个步骤来扩展音乐。在使用音频零件完成后,我们可以生成视频,首先,我们从稳定的扩散模型开始,以生成图像,然后使用另一个生成模型给它一些运动和动画。为了撰写最终的视频剪辑,我们将每个生成的音乐都与尽可能多的动画图像结合在一起,以匹配音乐的长度。

所有这些步骤都将生成中间文件,您可以检查并手动删除您不喜欢改善结果的内容。

使用此存储库的建议方法是与Docker一起使用,但是您也可以使用自定义VENV,只需确保安装所有依赖项即可。

注意:确保更新设备参数以最大化性能,但请注意,某些模型可能对所有设备选项(CPU,CUDA,MPS)不起作用。

project_dir: beats

project_name: lofi

seed: 42

music:

prompt: "lo-fi music with a relaxing slow melody"

model_id: facebook/musicgen-small

device: cpu

n_music: 5

music_duration: 60

initial_music_tokens: 1050

max_continuation_duration: 20

prompt_music_duration: 10

image:

prompt: "Mystical Landscape"

prompt_modifiers:

- "concept art, HQ, 4k"

- "epic scene, cinematic, sci fi cinematic look, intense dramatic scene"

- "digital art, hyperrealistic, fantasy, dark art"

- "digital art, hyperrealistic, sense of comsmic wonder"

- "mystical and ethereal atmosphere, photo taken with a wide-angle lens"

model_id: stabilityai/sdxl-turbo

device: mps

n_images: 5

inference_steps: 3

height: 576

width: 1024

video:

model_id: stabilityai/stable-video-diffusion-img2vid

device: cpu

n_continuations: 2

loop_video: true

video_fps: 6

decode_chunk_size: 8

motion_bucket_id: 127

noise_aug_strength: 0.1

audio_clip:

n_music_loops: 1

构建Docker图像

make build将绒毛和格式应用于代码(仅需要开发)

make lint运行整个管道以创建音乐视频

make ai_beats运行音乐生成步骤

make music运行音乐延续步骤

make music_continuation运行图像生成步骤

make image运行视频生成步骤

make video运行音频剪辑创建步骤

make audio_clip为了开发,请确保安装requirements-dev.txt并运行make lint以维护编码样式。

我在MacBook Pro M2上开发并测试了大部分项目,我无法运行的唯一步骤是视频创建步骤,因为我使用了Google COLAB(带有V100或A100 GPU)。某些模型在MPS上无法运行,但无论如何它们都可以在合理的时间内运行。

默认情况下,此处使用的模型具有特定的许可证,如果您想使用相同的型号,请确保检查其许可证。对于Music Generation MusicGEN及其CC-BY-NC 4.0许可证,用于图像生成SDXL-Turbo及其许可证-SDXL1.0许可证以及稳定的视频扩散及其稳定的视频扩散NC NC社区许可证的视频生成许可证。