С помощью этого проекта вы можете использовать ИИ для генерации музыкальных треков и видеоклипов. Предоставьте некоторую информацию о том, как вы хотели бы музыку и видео, код сделает все остальное.

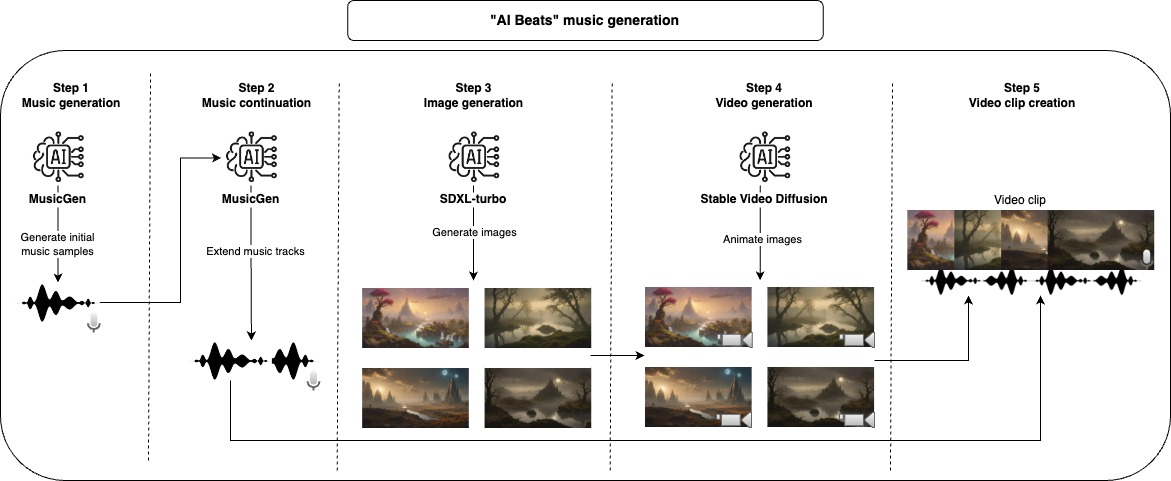

Во -первых, мы используем генеративную модель для создания образцов музыки, модель по умолчанию, используемая здесь, может генерировать только максимум 30 секунд музыки, по этой причине мы делаем еще один шаг, чтобы расширить музыку. Закончив аудиопарию, мы можем сгенерировать видео, сначала мы начинаем с стабильной диффузионной модели для генерации изображений, а затем мы используем другую генеративную модель, чтобы дать ей немного движения и анимации. Чтобы составить конечный видеоклип, мы принимаем каждую сгенерированную музыку и объединяем столько анимационных изображений, сколько необходимо, чтобы соответствовать длине музыки.

Все эти шаги будут генерировать промежуточные файлы, которые вы можете проверить, и вручную удалить то, что вам не нравится, чтобы улучшить результаты.

Рекомендуемый подход для использования этого репозитория с Docker, но вы также можете использовать пользовательский Venv, просто убедитесь, что установите все зависимости.

ПРИМЕЧАНИЕ. Обязательно обновите Param устройства, чтобы максимизировать производительность, но обратите внимание, что некоторые модели могут не работать для всех параметров устройства (ЦП, CUDA, MPS).

project_dir: beats

project_name: lofi

seed: 42

music:

prompt: "lo-fi music with a relaxing slow melody"

model_id: facebook/musicgen-small

device: cpu

n_music: 5

music_duration: 60

initial_music_tokens: 1050

max_continuation_duration: 20

prompt_music_duration: 10

image:

prompt: "Mystical Landscape"

prompt_modifiers:

- "concept art, HQ, 4k"

- "epic scene, cinematic, sci fi cinematic look, intense dramatic scene"

- "digital art, hyperrealistic, fantasy, dark art"

- "digital art, hyperrealistic, sense of comsmic wonder"

- "mystical and ethereal atmosphere, photo taken with a wide-angle lens"

model_id: stabilityai/sdxl-turbo

device: mps

n_images: 5

inference_steps: 3

height: 576

width: 1024

video:

model_id: stabilityai/stable-video-diffusion-img2vid

device: cpu

n_continuations: 2

loop_video: true

video_fps: 6

decode_chunk_size: 8

motion_bucket_id: 127

noise_aug_strength: 0.1

audio_clip:

n_music_loops: 1

Создайте изображение Docker

make buildПрименить ворс и форматирование к коду (необходимо только для разработки)

make lintЗапустите весь конвейер, чтобы создать музыкальное видео

make ai_beatsЗапустите шаг поколения музыки

make musicЗапустите этап продолжения музыки

make music_continuationЗапустите шаг генерации изображений

make imageЗапустите шаг генерации видео

make videoЗапустите шаг создания звука

make audio_clip Для разработки обязательно установите requirements-dev.txt и запустить make lint для поддержания стиля кодирования.

Я разработал и протестировал большую часть этого проекта на моем MacBook Pro M2, единственном шаге, который я не смог запустить, был шаг создания видео, для этого я использовал Google Colab (с V100 или A100 GPU). Некоторые из моделей не были выполнены на MPS , но они все равно работают в разумное время.

Модели, используемые по умолчанию здесь, имеют конкретные лицензии, которые могут не подходить для всех вариантов использования, если вы хотите использовать одни и те же модели, обязательно проверяйте их лицензии. Для Music Generation MusicGen и его лицензии CC-BY-NC 4.0, для генерации изображений SDXL-Turbo и ее лицензии SDXL1.0, а также стабильную диффузию видео и ее стабильная лицензия сообщества по производству видеороликов NC для получения видео.