Mit diesem Projekt können Sie mit AI Musik -Tracks und Videoclips generieren. Geben Sie einige Informationen darüber an, wie Sie Musik und Videos wünschen, der Code wird den Rest erledigen.

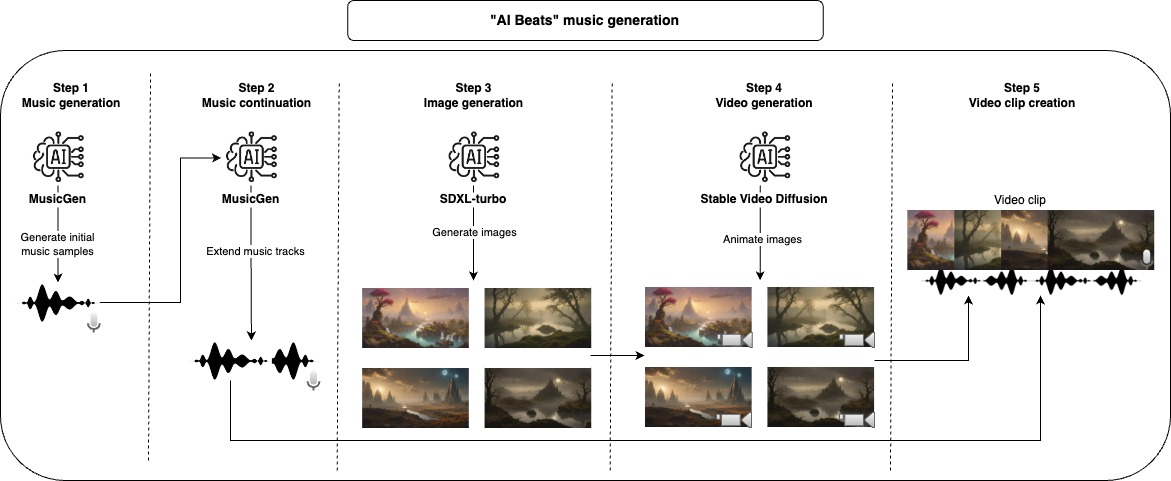

Zunächst verwenden wir ein generatives Modell, um Musikmuster zu erstellen. Nach dem Abschluss des Audio -Teils können wir das Video erstellen. Zuerst beginnen wir mit einem stabilen Diffusionsmodell, um Bilder zu generieren, und dann verwenden wir ein anderes generatives Modell, um ihm ein wenig Bewegung und Animation zu verleihen. Um den endgültigen Videoclip zu komponieren, nehmen wir jede erzeugte Musik und schließen sich mit so vielen animierten Bildern zusammen, um die Länge der Musik zu entsprechen.

Alle diese Schritte generieren Zwischendateien, die Sie inspizieren und manuell entfernen können, was Sie nicht gerne verbessern möchten.

Der empfohlene Ansatz zur Verwendung dieses Repositorys ist bei Docker. Sie können jedoch auch ein benutzerdefiniertes Gebiet verwenden. Stellen Sie einfach sicher, dass Sie alle Abhängigkeiten installieren.

Hinweis: Stellen Sie sicher, dass Sie den Geräteparam maximieren, um die Leistung zu maximieren. Beachten Sie jedoch, dass einige Modelle möglicherweise nicht für alle Geräteoptionen (CPU, CUDA, MPS) funktionieren.

project_dir: beats

project_name: lofi

seed: 42

music:

prompt: "lo-fi music with a relaxing slow melody"

model_id: facebook/musicgen-small

device: cpu

n_music: 5

music_duration: 60

initial_music_tokens: 1050

max_continuation_duration: 20

prompt_music_duration: 10

image:

prompt: "Mystical Landscape"

prompt_modifiers:

- "concept art, HQ, 4k"

- "epic scene, cinematic, sci fi cinematic look, intense dramatic scene"

- "digital art, hyperrealistic, fantasy, dark art"

- "digital art, hyperrealistic, sense of comsmic wonder"

- "mystical and ethereal atmosphere, photo taken with a wide-angle lens"

model_id: stabilityai/sdxl-turbo

device: mps

n_images: 5

inference_steps: 3

height: 576

width: 1024

video:

model_id: stabilityai/stable-video-diffusion-img2vid

device: cpu

n_continuations: 2

loop_video: true

video_fps: 6

decode_chunk_size: 8

motion_bucket_id: 127

noise_aug_strength: 0.1

audio_clip:

n_music_loops: 1

Erstellen Sie das Docker -Bild

make buildWenden Sie Lint und Formatierung auf den Code an (nur für die Entwicklung benötigt)

make lintFühren Sie die gesamte Pipeline aus, um das Musikvideo zu erstellen

make ai_beatsFühren Sie den Schritt der Musikgenerierung aus

make musicFühren Sie den Musikverstärkungsschritt aus

make music_continuationFühren Sie den Bildgenerierungsschritt aus

make imageFühren Sie den Videogenerierungsschritt aus

make videoFühren Sie den Schritt für die Erstellung von Audioclips aus

make audio_clip Für die Entwicklung stellen Sie sicher, dass requirements-dev.txt und make lint installieren, um den Codierungsstil aufrechtzuerhalten.

Ich habe den größten Teil dieses Projekts auf meinem MacBook Pro M2 entwickelt und getestet. Der einzige Schritt, den ich nicht ausführen konnte, war der Schritt der Videoerstellung, da ich Google Colab (mit V100 oder A100 GPU) verwendet habe. Einige der Modelle waren auf MPS nicht ausgeführt, aber sie läuft sowieso in einer angemessenen Zeit.

Die hier standardmäßig verwendeten Modelle haben spezifische Lizenzen, die möglicherweise nicht für alle Anwendungsfälle geeignet sind, wenn Sie dieselben Modelle verwenden möchten, stellen Sie sicher, dass sie ihre Lizenzen überprüfen. Für Musikgeneration MusicGen und seine CC-by-NC 4.0-Lizenz für die Bildgenerierung SDXL-Turbo und seine Lizenz-SDXL1.0-Lizenz sowie stabile Videodiffusion und deren stabile Videodiffusion NC Community-Lizenz für die Videogeneration.