รูปแบบการสังเคราะห์เสียงล่าสุดของเซซามี "โมเดลการสนทนาการสนทนา" (CSM) เพิ่งจุดประกายการสนทนาที่ร้อนแรงบนแพลตฟอร์ม X และเป็นที่รู้จักกันในชื่อ "โมเดลเสียงที่เป็นเหมือนคนที่พูดจริง" ด้วยความสามารถในการแสดงออกทางอารมณ์และการแสดงออกทางอารมณ์ของมันไม่เพียง แต่ทำให้ผู้ใช้ "ไม่สามารถแยกแยะ" ความแตกต่างจากมนุษย์ได้อีกต่อไป แต่ยังอ้างว่าประสบความสำเร็จในการข้าม ด้วยการแพร่กระจายของวิดีโอสาธิตและความคิดเห็นของผู้ใช้ CSM กำลังกลายเป็นเกณฑ์มาตรฐานใหม่สำหรับเทคโนโลยีเสียง AI อย่างรวดเร็ว

ข้าม "Underworld Valley": การพัฒนาเทคโนโลยีของ CSM

"เอฟเฟกต์ Underworld Valley" หมายถึงความไม่สะดวกของความรู้สึกไม่สบายของมนุษย์เมื่อเสียงหรือภาพสังเคราะห์เทียมใกล้เคียงกับมนุษย์จริง แต่ยังมีความแตกต่างเล็กน้อย งาเกี่ยวข้องกับปัญหานี้ผ่านโมเดล CSM X ผู้ใช้ @IMXIAOHU โพสต์เมื่อวันที่ 1 มีนาคม: "พี่น้องโมเดลเสียงใหม่เอี่ยมนี้น่าทึ่งและไม่สามารถแยกแยะได้อีกต่อไป!" เขาชี้ให้เห็นว่า CSM มีประสิทธิภาพที่ยอดเยี่ยมในด้านบุคลิกภาพความทรงจำความสามารถในการแสดงออกและความเหมาะสมตามบริบทเกือบกำจัดความรู้สึกเชิงกลของผู้ช่วยเสียงแบบดั้งเดิม

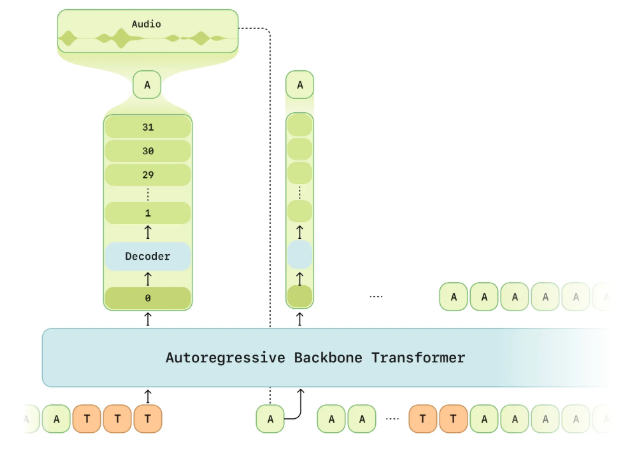

ทีมงานงาระบุไว้ในบทความการวิจัยอย่างเป็นทางการว่าเป้าหมายของ CSM คือการบรรลุ "การปรากฏตัวของเสียง" - ทำให้การโต้ตอบด้วยเสียงไม่เพียง แต่จริงและน่าเชื่อถือ แต่ยังเข้าใจและให้คุณค่า การพัฒนานี้เกิดจากองค์ประกอบหลัก: ความฉลาดทางอารมณ์ (การตีความและการตอบสนองต่ออารมณ์), หน่วยความจำบริบท (การปรับผลลัพธ์ตามประวัติบทสนทนา) และเทคโนโลยีการสร้างเสียงที่มีความเที่ยงตรงสูง ในระหว่างการสาธิต CSM แสดงให้เห็นถึงโทนสีธรรมชาติและอารมณ์ด้านอารมณ์ในการสนทนาที่ยาวนานเป็นพิเศษและผู้ใช้ไม่สามารถแยกแยะได้ว่าเป็น AI โดยไม่ทราบ

ประสบการณ์ผู้ใช้ที่สมจริง

ความคิดเห็นของผู้ใช้บนแพลตฟอร์ม X ยืนยันประสิทธิภาพที่น่าทึ่งของ CSM เพิ่มเติม @Imxiaohu แบ่งปันการสาธิตบทสนทนาที่ยาวนานในโพสต์ครอบคลุมฉากและสถานการณ์ที่หลากหลายและคร่ำครวญ: "เสียงและอารมณ์นั้นอยู่ใกล้กับมนุษย์มากในการแสดงออกบางอย่างฮ่าฮ่าฮ่าฮ่า" เขากล่าวว่าในกรณีที่ไม่มีคำแนะนำผลลัพธ์ของโมเดลนี้ทำให้ยากที่จะแยกแยะระหว่างความจริงและเท็จ ผู้ใช้อีกคน @leeoxiang กล่าวเมื่อวันที่ 1 มีนาคมว่าเขาฝึกฝนการพูดภาษาอังกฤษกับ CSM เป็นเวลาครึ่งชั่วโมงและแทบจะไม่มีความล่าช้าเลย เขาบอกว่า

ความกระตือรือร้นของชุมชนไม่ได้ จำกัด อยู่ที่การสรรเสริญ ผู้ใช้หลายคนชี้ให้เห็นว่าความคล่องแคล่วบทสนทนาของ CSM และการแสดงออกทางอารมณ์ได้ผ่านโมเดลกระแสหลักที่มีอยู่เช่นโหมด Voice ของ OpenAI @OP7418 แนะนำให้นักวิจัยให้ความสนใจกับบทความทางเทคนิคของงาเมื่อวันที่ 28 กุมภาพันธ์และเน้นระบบการประเมินความถูกต้องด้วยเสียงที่เป็นเอกลักษณ์ซึ่งแสดงให้เห็นถึงความเข้มงวดทางเทคนิคของแบบจำลอง

ยังคงมีพื้นที่สำหรับการปรับปรุง: แผนการในอนาคตของงา

แม้จะมีการแสดงที่น่าตกใจของ CSM งาก็ยอมรับอย่างเป็นทางการว่านี่ไม่ใช่จุดจบ @Imxiaohu อ้างถึงคำแถลงอย่างเป็นทางการและกล่าวว่า "นี่ไม่ใช่สิ่งที่สมบูรณ์แบบที่สุดยังมีพื้นที่สำหรับการปรับปรุงมากมาย!" ในปัจจุบัน CSM รองรับหลายภาษาเช่นภาษาอังกฤษ แต่เมื่อ @leeoxiang ชี้ให้เห็นว่าภาษาจีนยังไม่ได้รับการสนับสนุน นอกจากนี้ผู้ใช้บางคนพบในการทดสอบว่าประสิทธิภาพของโมเดลในบริบทเฉพาะ (เช่นการสลับภาษาต่างประเทศหรือการร้องเพลงเพลง) ยังคงมีที่ว่างสำหรับการปรับปรุง

งาได้สัญญาว่าจะโอเพ่นซอร์สผลการวิจัยบางอย่างและหน้า GitHub (Sesameailabs/CSM) แสดงให้เห็นว่า CSM จะได้รับใบอนุญาตภายใต้ Apache2.0 การเคลื่อนไหวครั้งนี้ได้กระตุ้นความคาดหวังจากชุมชนนักพัฒนาและหลายคนหวังว่าจะส่งเสริมการพัฒนาของ AI เสียงผ่านการวิจัยเชิงลึกเกี่ยวกับสถาปัตยกรรม

ผลกระทบของอุตสาหกรรมและโอกาส

การเปิดตัวของ CSM ไม่เพียง แต่เป็นการตอบสนองทางเทคนิคต่อ“ เอฟเฟกต์ Unortal Valley” แต่ยังกำหนดมาตรฐานใหม่สำหรับการโต้ตอบด้วยเสียง AI เมื่อเทียบกับ Grok, Claude และรุ่นอื่น ๆ CSM มีข้อได้เปรียบที่โดดเด่นโดยเฉพาะอย่างยิ่งในเวลาจริงเวลาแฝงต่ำและการแสดงออกทางอารมณ์ x ผู้ใช้ @ablegpt กล่าวเมื่อวันที่ 2 มีนาคม: "หากคุณกำลังศึกษาเสียง AI ขอแนะนำให้อ่านบทความนี้" สิ่งนี้สะท้อนให้เห็นถึงความสำคัญที่สร้างแรงบันดาลใจของ CSM ต่อวงกลมเทคโนโลยี

ด้วยการวางแผนงาเพื่อขยายการสนับสนุนภาษาและเพิ่มประสิทธิภาพโมเดล CSM คาดว่าจะเปล่งประกายในด้านต่าง ๆ เช่นการศึกษาความบันเทิงและสหายเสมือนจริง การตัดสินจากการตอบสนองที่กระตือรือร้นใน X โมเดลเสียง "พี่น้องคิดว่ามันน่าทึ่ง" กำลังนิยามใหม่วิธีที่ผู้คนโต้ตอบกับ AI ด้วยบทสนทนาที่สมจริง ในอนาคตมันสามารถกำจัด "Vanny Valley" ได้อย่างสมบูรณ์และกลายเป็น "พันธมิตรดิจิทัล" ที่แท้จริงได้หรือไม่? คำตอบอาจอยู่ในการทำซ้ำของงาครั้งต่อไป

ที่อยู่ทดลองใช้: https://www.sesame.com/research/crossing_the_uncanny_valley_of_voice#demo