Le dernier modèle de synthèse vocale de Sesame "Conversational Speech Model" (CSM) a récemment déclenché une discussion animée sur la plate-forme X et est connue sous le nom de "un modèle vocal qui est comme une vraie personne qui parle". Avec sa nature étonnante et sa capacité d'expression émotionnelle, ce modèle fait non seulement des utilisateurs "ne peuvent plus distinguer" ses différences des humains, mais prétend également avoir réussi à traverser "l'effet de la vallée étrange" dans le domaine de la voix. Avec la propagation des vidéos de démonstration et des commentaires des utilisateurs, CSM devient rapidement une nouvelle référence pour la technologie vocale de l'IA.

Traverser la "vallée des enfers": percée technologique de CSM

L'effet de «l'effet de la vallée des enfers» fait référence à l'inconvénient de l'inconfort humain lorsque la voix ou l'image synthétisée artificiellement est proche des vrais humains, mais il existe encore des différences subtiles. Sesame traite de front ce problème via son modèle CSM. L'utilisateur x @imxiaohu a posté le 1er mars: "Brothers, ce tout nouveau modèle vocal est incroyable et ne peut plus être distingué!" Il a souligné que CSM a une excellente performance dans la personnalité, la mémoire, la capacité d'expression et la pertinence contextuelle, éliminant presque le sentiment mécanique des assistants vocaux traditionnels.

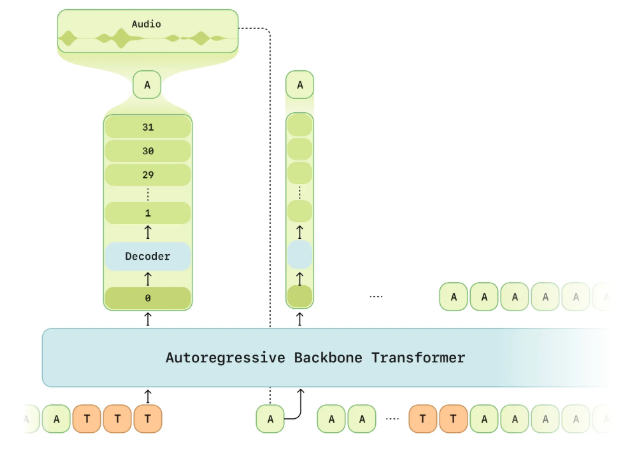

L'équipe de Sesame a déclaré dans un article de recherche officiel que l'objectif de CSM est de réaliser une "présence vocale" - faisant des interactions vocales non seulement vraies et dignes de confiance, mais aussi comprendre et apprécié. Cette percée est due à ses composantes centrales: intelligence émotionnelle (interprétation et réponse aux émotions), mémoire de contexte (ajustant la sortie basée sur l'historique du dialogue) et une technologie de génération de voix à haute fidélité. Au cours de la démonstration, le CSM a montré un ton naturel et un côté émotionnel dans la conversation ultra-longue, et les utilisateurs n'ont même pas pu le distinguer en IA sans le savoir.

Expérience utilisateur réaliste

Les commentaires des utilisateurs sur la plate-forme X confirment en outre les performances incroyables de CSM. @imxiaohu a partagé une démonstration de dialogue super longue dans le post, couvrant une variété de scènes et de scénarios, et a déploré: "Le ton et l'émotion sont très, très proches des humains dans certaines expressions, hahahaha." Il a mentionné qu'en l'absence d'indices, la sortie de ce modèle a rendu difficile la distinction entre vrai et faux. Un autre utilisateur @leeoxiang a déclaré le 1er mars qu'il avait pratiqué parler anglais avec CSM pendant une demi-heure, et presque aucun délai n'était ressenti. Il a dit que "son costume se fait très bien et qu'il y aura un ton", et que sa capacité à parler activement est également impressionnante.

L'enthousiasme de la communauté ne se limite pas aux éloges. De nombreux utilisateurs soulignent que la maîtrise du dialogue de CSM et l'expression émotionnelle ont dépassé les modèles grand public existants tels que le mode vocal Chatgpt d'OpenAI. @ OP7418 a recommandé aux chercheurs de prêter attention aux articles techniques de Sesame le 28 février et à souligner son système unique d'évaluation de l'authenticité vocale, montrant la rigueur technique du modèle.

Toujours place à l'amélioration: les plans futurs de Sesame

Malgré la performance choquante de CSM, Sesame a officiellement admis que ce n'était pas la fin. @imxiaohu a cité la déclaration officielle et a dit: "Ce n'est pas le plus parfait, il y a encore beaucoup de place à amélioration!" À l'heure actuelle, CSM prend en charge plusieurs langues telles que l'anglais, mais comme l'a souligné @LeeOxiang, le chinois n'est pas encore pris en charge. De plus, certains utilisateurs ont trouvé dans le test que les performances du modèle dans des contextes spécifiques (tels que la commutation de langue étrangère ou le chant de musique) ont toujours la place à l'amélioration.

Sesame a promis d'open source certains de ses résultats de recherche, et sa page GitHub (SesameAilabs / CSM) montre que CSM sera sous licence dans l'APACHE2.0. Cette décision a suscité des attentes de la communauté des développeurs, et de nombreuses personnes espèrent promouvoir davantage le développement de l'IA de la voix grâce à des recherches approfondies sur son architecture.

Impact et perspectives de l'industrie

Les débuts de CSM ne sont pas seulement une réponse technique à «l'effet de vallée sans oralité», mais établit également une nouvelle norme pour l'interaction vocale de l'IA. Par rapport à Grok, Claude et d'autres modèles, CSM présente des avantages particulièrement exceptionnels dans la latence en temps réel, faible et expression émotionnelle. X User @ablegpt a déclaré le 2 mars: "Si vous étudiez la voix de l'IA, il est fortement recommandé de lire cet article." Cela reflète la signification inspirante du CSM pour le cercle technologique.

Avec la planification de sésame pour étendre le soutien linguistique et optimiser les modèles, CSM devrait briller dans des domaines tels que l'éducation, le divertissement et les compagnons virtuels. À en juger par la réponse enthousiaste sur X, ce modèle de voix "Brothers pense que c'est incroyable" redéfinit la façon dont les gens interagissent avec l'IA avec un dialogue réaliste. À l'avenir, peut-il éliminer complètement la "vallée étrange" et devenir un véritable "partenaire numérique"? La réponse peut être dans la prochaine itération du sésame.

Adresse d'essai: https://www.sesame.com/research/crossing_the_uncanny_valley_of_voice#demo