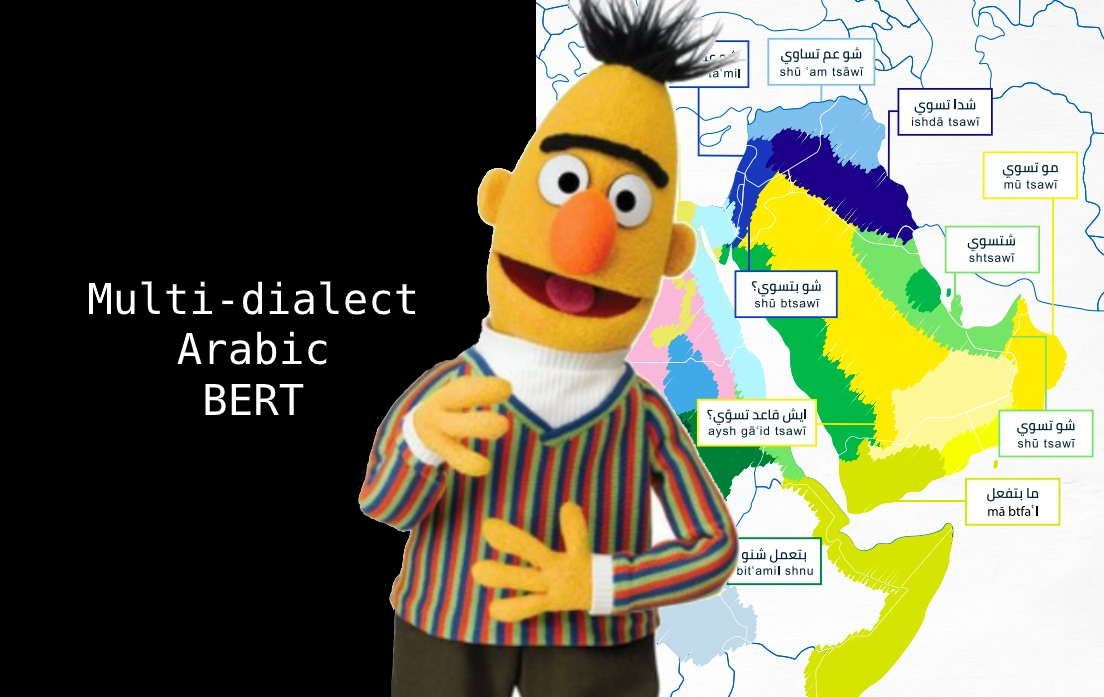

Multi dialect Arabic BERT

1.0.0

นี่คือพื้นที่เก็บข้อมูลของแบบจำลองอาหรับเบิร์ตแบบหลายจุด

โดย Mawdoo3-ai

แทนที่จะฝึกอบรมแบบจำลองอาหรับเบิร์ตแบบหลายจุดเริ่มต้นจากศูนย์เราเริ่มต้นน้ำหนักของแบบจำลองโดยใช้ภาษาอาหรับ-เบิร์ตและฝึกฝนในทวีตอาหรับ 10M จากข้อมูลที่ไม่ได้ใช้งานของงานภาษาอาหรับที่มีความเหมาะสม (NADI) ที่ใช้ร่วมกัน

@misc{talafha2020multidialect,

title={Multi-Dialect Arabic BERT for Country-Level Dialect Identification},

author={Bashar Talafha and Mohammad Ali and Muhy Eddin Za'ter and Haitham Seelawi and Ibraheem Tuffaha and Mostafa Samir and Wael Farhan and Hussein T. Al-Natsheh},

year={2020},

eprint={2007.05612},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

น้ำหนักรุ่นสามารถโหลดได้โดยใช้ไลบรารี transformers โดย HuggingFace

from transformers import AutoTokenizer , AutoModel

tokenizer = AutoTokenizer . from_pretrained ( "bashar-talafha/multi-dialect-bert-base-arabic" )

model = AutoModel . from_pretrained ( "bashar-talafha/multi-dialect-bert-base-arabic" ) ตัวอย่างการใช้ pipeline :

from transformers import pipeline

fill_mask = pipeline (

"fill-mask" ,

model = "bashar-talafha/multi-dialect-bert-base-arabic " ,

tokenizer = "bashar-talafha/multi-dialect-bert-base-arabic "

)

fill_mask ( " سافر الرحالة من مطار [MASK] " ) [{'sequence': '[CLS] سافر الرحالة من مطار الكويت [SEP]', 'score': 0.08296813815832138, 'token': 3226},

{'sequence': '[CLS] سافر الرحالة من مطار دبي [SEP]', 'score': 0.05123933032155037, 'token': 4747},

{'sequence': '[CLS] سافر الرحالة من مطار مسقط [SEP]', 'score': 0.046838656067848206, 'token': 13205},

{'sequence': '[CLS] سافر الرحالة من مطار القاهرة [SEP]', 'score': 0.03234650194644928, 'token': 4003},

{'sequence': '[CLS] سافر الرحالة من مطار الرياض [SEP]', 'score': 0.02606341242790222, 'token': 2200}]

| พารามิเตอร์ | ค่า |

|---|---|

| สถาปัตยกรรม | bertformaskedlm |

| hidden_size | 768 |

| max_position_embeddings | 512 |

| num_attention_heads | 12 |

| num_hidden_layers | 12 |

| คำศัพท์ | 32000 |

| hidden_size | 768 |

| จำนวนพารามิเตอร์ทั้งหมด | 110m |