Non-autoregressive Expressive TTS : โครงการนี้มีจุดมุ่งหมายเพื่อให้รากฐานที่สำคัญสำหรับการวิจัยในอนาคตและการประยุกต์ใช้ TTs ที่ไม่ได้เป็นแบบไม่ได้รวมถึง Emotional TTS และ Conversational TTS สำหรับชุดข้อมูลชุดข้อมูล AI วิดีโอ AIHUB Multimodal AI และฐานข้อมูล IEMOCAP จะถูกเลือกสำหรับเกาหลีและภาษาอังกฤษตามลำดับ

หมายเหตุ : หากคุณมีความสนใจใน GST-tacotron หรือ vae-tacotron เช่นโมเดล TTS แบบโวหารที่แสดงออก แต่ภายใต้การถอดรหัสที่ไม่ใช่แบบออตอเรติกคุณอาจสนใจ Styler [Demo, Code]

Annotated Data Processing : โครงการนี้ให้ความกระจ่างเกี่ยวกับวิธีการจัดการชุดข้อมูลใหม่แม้จะมีภาษาที่แตกต่างกันสำหรับการฝึกอบรม TTS ทางอารมณ์ที่ไม่เป็นอิสระ

English and Korean TTS : นอกเหนือจากภาษาอังกฤษโครงการนี้ยังให้มุมมองที่กว้างขวางเกี่ยวกับการรักษาเกาหลีสำหรับ TTS ที่ไม่ใช่ผู้เรียนที่ต้องพิจารณาการประมวลผลข้อมูลเพิ่มเติมภายใต้คุณสมบัติเฉพาะภาษา (เช่นการฝึกอบรมการบังคับใช้ภาษามอนทรีออลด้วยภาษาและชุดข้อมูลของคุณเอง) โปรดดู text/

Adopting Own Language : สำหรับผู้ที่มีความสนใจในการปรับภาษาอื่น ๆ โปรดดูที่ส่วน "การฝึกอบรมด้วยชุดข้อมูลของคุณเอง (ภาษาเอง)" ของสาขาหมวดหมู่

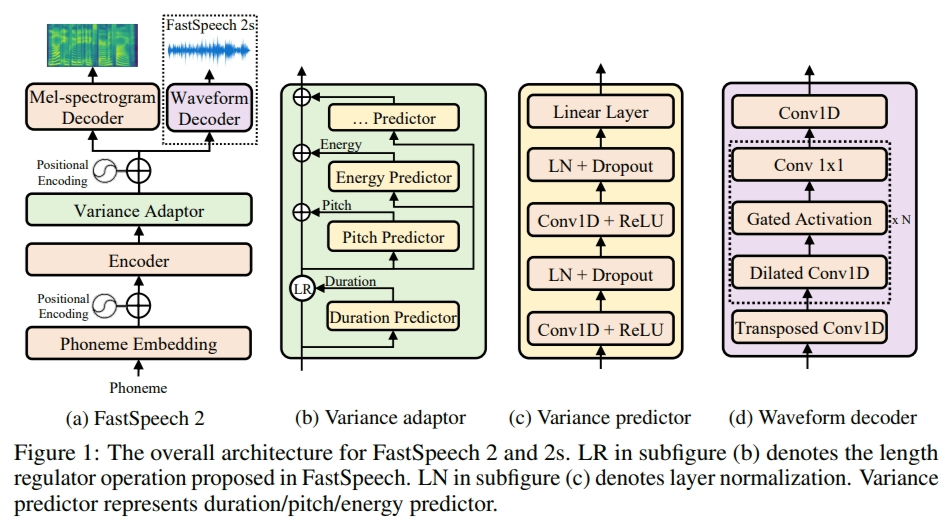

ในโครงการนี้ FastSpeech2 ได้รับการดัดแปลงเป็นเฟรมเวิร์ก TTS หลายลำโพงที่ไม่ได้เป็นฐานแบบอัตโนมัติดังนั้นจึงเป็นประโยชน์ในการอ่านกระดาษและรหัสก่อน (ดูสาขา FastSpeech2)

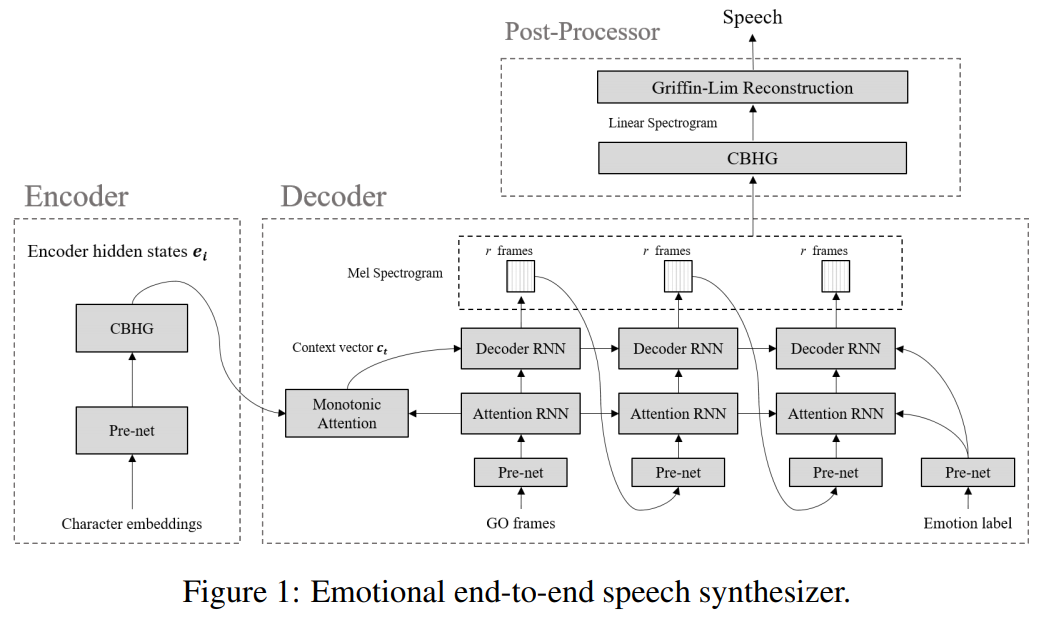

Emotional TTS : การติดตามสาขามีการใช้งานของกระบวนทัศน์พื้นฐานที่ถูกสังเคราะห์โดยการสังเคราะห์การพูดของระบบประสาทแบบ end-to-end ทางอารมณ์

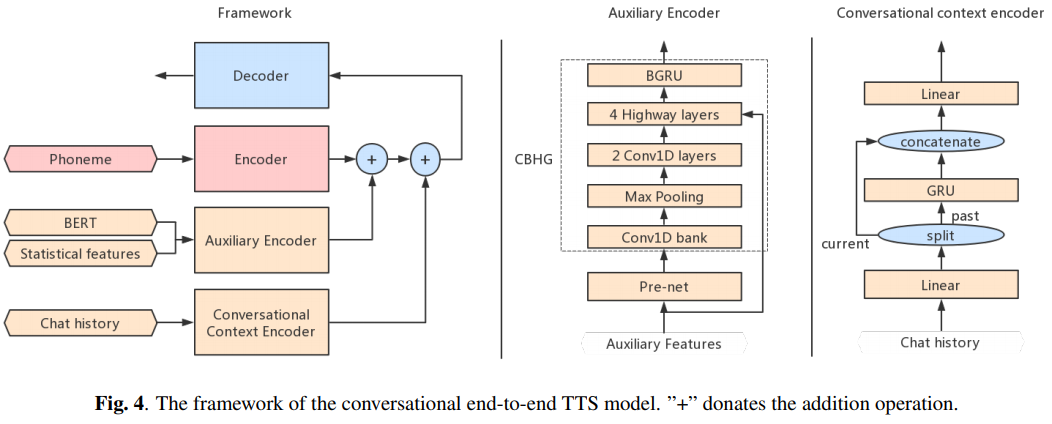

Conversational TTS : สาขาต่อไปนี้มีการใช้งาน TTS แบบ end-to-end การสนทนาสำหรับตัวแทนเสียง

หากคุณต้องการใช้หรืออ้างถึงการใช้งานนี้โปรดอ้างอิง repo

@misc{lee2021expressive_fastspeech2,

author = {Lee, Keon},

title = {Expressive-FastSpeech2},

year = {2021},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = { u rl{https://github.com/keonlee9420/Expressive-FastSpeech2}}

}