С быстрой разработкой мультимодальных крупных языковых моделей (MLLMS), задачи, связанные с изображением и видео, открыли беспрецедентные прорывы, особенно в областях визуальных вопросов и ответов, повествовательного поколения и интерактивного редактирования. Однако, несмотря на значительный прогресс в этих технологиях, достижение мелкозернистого понимания видеоконтента остается сложной проблемой. Эта задача включает в себя не только сегментацию и отслеживание уровня пикселей с описаниями языка, но и сложные задачи, такие как визуальные вопросы и ответы по конкретным подсказкам видео.

Хотя текущие современные модели восприятия видео хорошо работают в задачах сегментации и отслеживания, они все еще неадекватны в понимании открытого языка и диалога. Видео MLLM, хотя и хорошо выполняют видео по пониманию и вопросам вопросов и ответов, все еще не могут выполнять задачи восприятия и визуальные сигналы. Это ограничение ограничивает их использование в более широком диапазоне сценариев.

Существующие решения в основном разделены на две категории: мультимодальные крупные языковые модели (MLLMS) и системы эталонного сегментации. Первоначально MLLMS сосредоточился на улучшении методов мультимодального слияния и экстракторов функций, и постепенно превратился в структуру для настройки инструкций на LLM, таких как Llava. Недавно исследователи пытались объединить изображения, видео и анализ с несколькими изображениями в одну структуру, такие как Llava-Onevision. В то же время система эталона сегментации также претерпела преобразование от основных модулей слияния в интегрированную сегментацию и отслеживание. Тем не менее, эти решения по -прежнему имеют недостатки в комплексной интеграции возможностей восприятия и понимания языка.

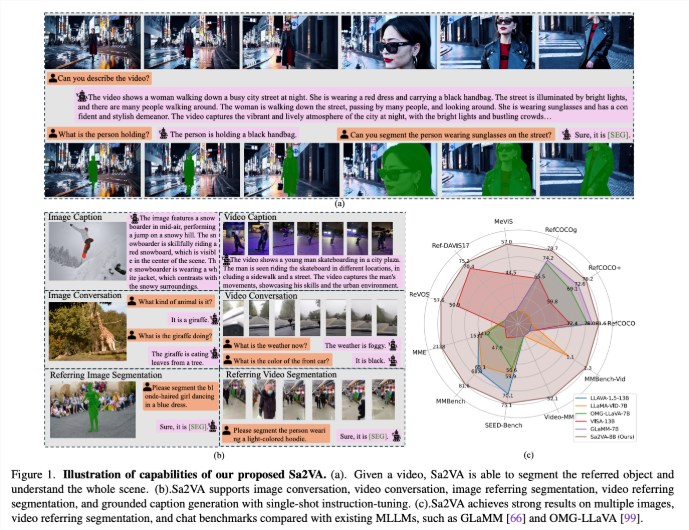

Исследователи из UC Merced, Bytedance Seed Team, Университета Ухан и Пекинского университета предложили SA2VA, новаторской унифицированной модели, предназначенной для достижения интенсивного базового понимания изображений и видео. Эта модель преодолевает ограничения существующих мультимодальных крупных языковых моделей, минимизируя единовременную настройку инструкций и поддерживая широкий спектр изображений и видео задач.

SA2VA инновационно интегрирует SAM-2 с Llava, чтобы объединить текст, изображения и видео в общее пространство токенов LLM. Кроме того, исследователи запустили обширный набор данных автоматического аннотации под названием Ref-SAV, который содержит выражения объектов в более чем 72K сложных видео сценариях, и 2K-проверенные видео объекты для обеспечения надежных возможностей для сравнения.

Архитектура SA2VA в основном состоит из двух частей: модель, похожая на Llava и SAM-2, и принимает новый дизайн развязки. Компонент, похожий на Llava, включает в себя визуальный энкодер, который обрабатывает изображения и видео, слой визуальной проекции и LLM для прогнозирования токена текста. Система принимает уникальный метод развязки, который позволяет SAM-2 работать рядом с предварительно обученной моделью LLAVA без прямой обмены токенов, тем самым поддерживая вычислительную эффективность и позволяя подключить плагин и отключить с различным предварительно обученным подключением MLLMS.

Результаты исследований показывают, что SA2VA достиг современных результатов в задаче сегментации цитирования, при этом ее модель SA2VA-8B имела показатели CIO на RefCoco, RefCoco+ и RefCocog, соответственно, превзошли предыдущие системы, такие как Glamm-7B. С точки зрения возможностей диалога, SA2VA достигли отличных результатов 2128, 81,6 и 75,1 на MME, MMBench и Seed-Bench соответственно.

Кроме того, производительность SA2VA в видео-тестах значительно превзошла предыдущее состояние-визу-13B, демонстрируя ее эффективность и эффективность в задачах понимания изображения и видео.

Бумага: https://arxiv.org/abs/2501.04001

Модель: https://huggingface.co/collections/bytedance/sa2va-model-zoo-677e3084d71b5f108d00e093

Ключевые моменты:

SA2VA-это новая унифицированная структура ИИ, которая достигает глубокого понимания изображений и видео и преодолевает ограничения существующих мультимодальных моделей.

Модель достигла современных результатов в нескольких критериях, таких как возможности сегментации цитирования и диалога, демонстрируя выдающуюся производительность.

Дизайн SA2VA эффективно интегрирует возможности визуального и языка с помощью метода развязки, поддерживая широкий спектр изображений и видео задач.