Avec le développement rapide de modèles multimodaux de grande langue (MLLM), les tâches d'image et de vidéo ont inauguré des percées sans précédent, en particulier dans les domaines des questions et réponses visuelles, de la génération narrative et de l'édition interactive. Cependant, malgré des progrès significatifs dans ces technologies, la compréhension du contenu vidéo à grain fin reste un problème difficile à résoudre. Ce défi implique non seulement la segmentation et le suivi au niveau des pixels avec des descriptions de langage, mais aussi des tâches complexes telles que les questions et réponses visuelles sur des invites vidéo spécifiques.

Bien que les modèles de perception vidéo actuels de pointe fonctionnent bien dans les tâches de segmentation et de suivi, elles sont toujours inadéquates dans la compréhension du langage ouvert et les capacités de dialogue. Les MLLM vidéo, bien que bien performantes dans la compréhension vidéo et les tâches de questions-réponses, ne sont toujours pas en mesure de gérer les tâches et les indices visuels perceptuels. Cette limitation limite leur utilisation dans une gamme plus large de scénarios.

Les solutions existantes sont principalement divisées en deux catégories: les modèles de langage grand multimodal (MLLM) et les systèmes de segmentation de référence. Les MLLM se sont initialement concentrés sur l'amélioration des méthodes de fusion multimodales et des extracteurs de fonctionnalités, et se sont progressivement développés en un cadre de réglage des instructions sur les LLM, tels que LLAVA. Récemment, les chercheurs ont essayé d'unifier les images, les vidéos et l'analyse multi-images dans un seul cadre, comme Llava OneVision. Dans le même temps, le système de segmentation de référence a également subi une transformation des modules de fusion de base à la segmentation et au suivi intégrés. Cependant, ces solutions ont encore des lacunes dans l'intégration complète des capacités de perception et de compréhension du langage.

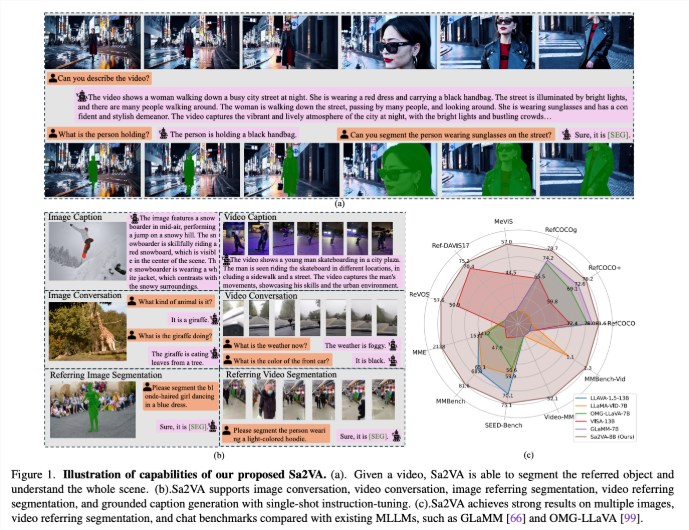

Des chercheurs de UC Merced, de l'équipe de semences de Bytedance, de l'Université de Wuhan et de l'Université de Peking ont proposé SA2VA, un modèle unifié révolutionnaire conçu pour obtenir une compréhension de base intensive des images et des vidéos. Ce modèle surmonte les limites des modèles de langage multimodal existants en minimisant le réglage ponctuel et en soutenant un large éventail de tâches d'image et de vidéo.

SA2VA intègre SAM-2 avec LLAVA pour unifier du texte, des images et des vidéos dans un espace de jeton LLM partagé. En outre, les chercheurs ont lancé un ensemble de données d'annotation automatique approfondie appelé Ref-SAV, qui contient des expressions d'objets dans plus de 72k scénarios vidéo complexes, et 2k objets vidéo vérifiés manuellement pour garantir des capacités d'analyse comparative robustes.

L'architecture de SA2VA est principalement composée de deux parties: un modèle similaire à Llava et Sam-2, et adopte un nouveau design de découplage. Le composant de type LLAVA comprend un encodeur visuel qui traite les images et les vidéos, une couche de projection visuelle et un LLM pour la prédiction de jeton de texte. Le système adopte une méthode de découplage unique qui permet à SAM-2 de fonctionner à côté du modèle LLAVA pré-formé sans échange de jetons direct, conservant ainsi l'efficacité de calcul et permettant le plug-in et le débranchement avec divers MLLMS pré-formés.

Les résultats de la recherche montrent que SA2VA a obtenu des résultats de pointe dans la tâche de segmentation de citation, son modèle SA2VA-8B ayant des scores CIOU sur RefCoco, Refcoco + et Refcocog, respectivement, dépassant les systèmes précédents tels que GLAMM-7B. En termes de capacités de dialogue, SA2VA a obtenu d'excellents résultats des 2128, 81,6 et 75,1 sur MME, MMBENCH et BEM-BENCH respectivement.

De plus, les performances de SA2VA dans les références vidéo ont considérablement dépassé l'état précédent - Visa-13B de l'art, montrant son efficacité et son efficacité dans les tâches de compréhension de l'image et de la vidéo.

Papier: https://arxiv.org/abs/2501.04001

Modèle: https://huggingface.co/collections/bytedance/sa2va-model-zoo-677e3084d71b5f108d00e093

Points clés:

SA2VA est un nouveau cadre d'IA unifié qui permet une compréhension approfondie des images et des vidéos et surmonte les limites des modèles multimodaux existants.

Le modèle a obtenu des résultats de pointe dans plusieurs repères tels que la segmentation des citations et les capacités de dialogue, montrant des performances exceptionnelles.

La conception de SA2VA intègre efficacement les capacités de compréhension visuelle et du langage grâce à une méthode de découplage, soutenant un large éventail de tâches d'image et de vidéo.