Mit der schnellen Entwicklung multimodaler Großsprachenmodelle (MLLMS) haben sich Bild und Video-bezogene Aufgaben bei beispiellosen Durchbrüchen eingeleitet, insbesondere in den Bereichen visueller Fragen und Antworten, Erzählgenerierung und interaktiver Bearbeitung. Trotz erheblicher Fortschritte bei diesen Technologien bleibt das Erreichen von feinkörnigem Video-Inhaltsverständnis ein schwieriges Problem zu lösen. Diese Herausforderung beinhaltet nicht nur die Segmentierung und Verfolgung von Pixel-Ebenen mit Sprachbeschreibungen, sondern auch komplexe Aufgaben wie visuelle Q & A auf bestimmten Videoaufforderungen.

Obwohl die aktuellen hochmodernen Video-Wahrnehmungsmodelle in der Segmentierung und der Verfolgung von Aufgaben gut abschneiden, sind sie immer noch in Bezug auf das Verständnis für offene Sprache und die Dialogfunktionen unzureichend. Video -Mllms, obwohl sie in Videoverständnis und Q & A -Aufgaben gut abschneiden, können immer noch nicht wahrnehmende Aufgaben und visuelle Hinweise erledigen. Diese Einschränkung begrenzt ihre Verwendung in einer breiteren Reihe von Szenarien.

Die vorhandenen Lösungen sind hauptsächlich in zwei Kategorien unterteilt: multimodale Großsprachenmodelle (MLLMS) und Referenzsegmentierungssysteme. MLLMS konzentrierte sich zunächst auf die Verbesserung multimodaler Fusionsmethoden und Feature -Extraktoren und entwickelte sich allmählich zu einem Rahmen für die Anleitungsabstimmung auf LLMs wie LLAVA. In letzter Zeit haben Forscher versucht, Bilder, Videos und Multi-Image-Analysen in ein einzelnes Framework wie Llava-Onevision zu vereinen. Gleichzeitig hat das Referenzsegmentierungssystem auch eine Transformation von grundlegenden Fusionsmodulen zu integrierter Segmentierung und Verfolgung durchlaufen. Diese Lösungen haben jedoch noch Mängel bei der umfassenden Integration von Wahrnehmungs- und Sprachverständnisfunktionen.

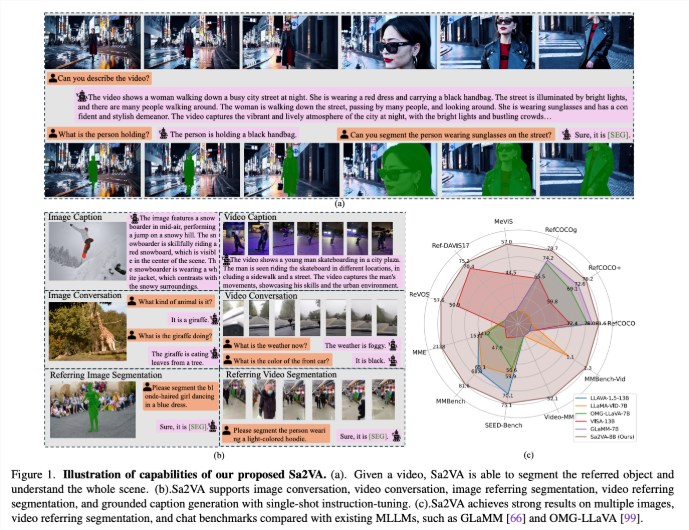

Forscher von UC Merced, Bytedance Seed Team, der Wuhan University und der Peking University haben SA2VA vorgeschlagen, ein bahnbrechendes einheitliches Modell, das ein intensives grundlegendes Verständnis von Bildern und Videos erreicht hat. Dieses Modell überwindet die Einschränkungen vorhandener multimodaler großer Sprachmodelle, indem es die einmalige Anweisungen minimiert und eine breite Palette von Bild- und Videoaufgaben unterstützt.

SA2VA integriert SAM-2 innovativ in LLAVA, um Text, Bilder und Video in einen gemeinsam genutzten LLM-Token-Raum zu vereinen. Darüber hinaus haben die Forscher einen umfangreichen automatischen Annotationsdatensatz namens Ref-Sav auf den Markt gebracht, das Objektausdrücke in mehr als 72.000-komplexen Videoszenarien enthält, und 2K manuell überprüfte Videoobjekte, um robuste Benchmarking-Funktionen sicherzustellen.

Die Architektur von SA2VA besteht hauptsächlich aus zwei Teilen: einem Modell ähnlich wie Llava und SAM-2 und nimmt ein neuartiges Entkopplungsdesign an. Die LLAVA-ähnliche Komponente enthält einen visuellen Encoder, der Bilder und Videos, eine visuelle Projektionsschicht und ein LLM für die Vorhersage von Text Token verarbeitet. Das System verwendet eine einzigartige Entkopplungsmethode, mit der SAM-2 neben dem vorgeborenen LLAVA-Modell ohne direkten Token-Austausch arbeiten kann, wodurch die Recheneffizienz beibehalten wird und Plug-In und Stecker mit verschiedenen vorgebreiteten MLLMS-Verbindungen ermöglicht werden kann.

Die Forschungsergebnisse zeigen, dass SA2VA in der Aufgabe des Zitierungssegmentierungsgebnisses auf dem neuesten Stand der Technik erreicht wurde. Das SA2VA-8B-Modell enthielt CIOU-Werte für Refcoco, Refcoco+ und Refcocog, was frühere Systeme wie Glamm-7b übertrifft. In Bezug auf die Dialogfähigkeiten erzielte SA2VA hervorragende Ergebnisse von 2128, 81,6 und 75,1 auf MME, MMBench und Saatgut.

Darüber hinaus übertraf die Leistung von SA2VA in Video-Benchmarks erheblich den vorherigen Zustand-von Visa-13b-und zeigt seine Effizienz und Effektivität bei den Aufgaben des Bild- und Videoverständnisses.

Papier: https://arxiv.org/abs/2501.04001

Modell: https://huggingface.co/Collections/Bytedance/Sa2va-model-zoo-677e3084d71b5f108d00e093

Schlüsselpunkte:

SA2VA ist ein neuartiges Unified AI-Framework, das ein umfassendes Verständnis von Bildern und Videos erzielt und die Einschränkungen vorhandener multimodaler Modelle überwindet.

Das Modell hat hochmoderne Ergebnisse in mehreren Benchmarks wie Zitiersegmentierung und Dialogfähigkeiten erzielt, die eine herausragende Leistung zeigen.

Das Design von SA2VA integriert effektiv visuelle und sprachliche Verständnisfunktionen durch eine Entkopplungsmethode und unterstützt eine Vielzahl von Bild- und Videoaufgaben.