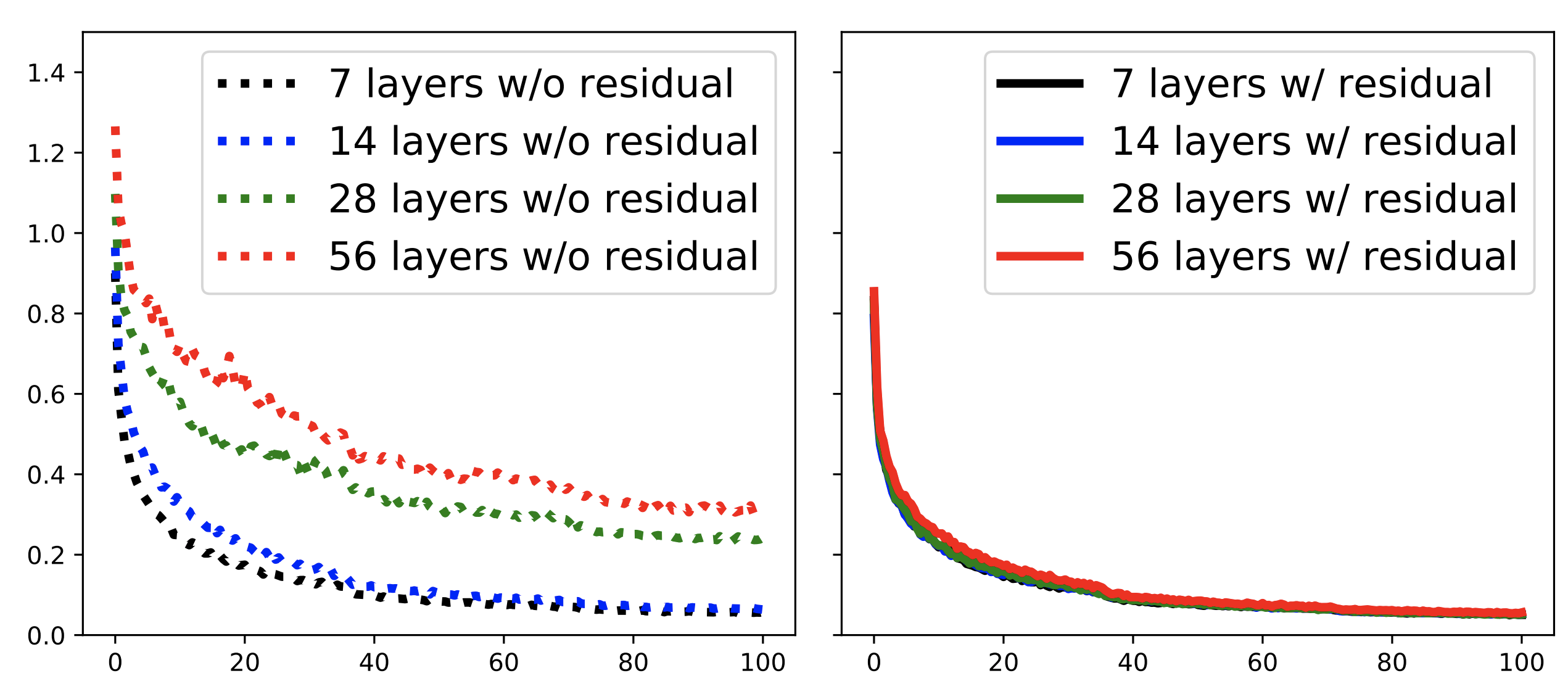

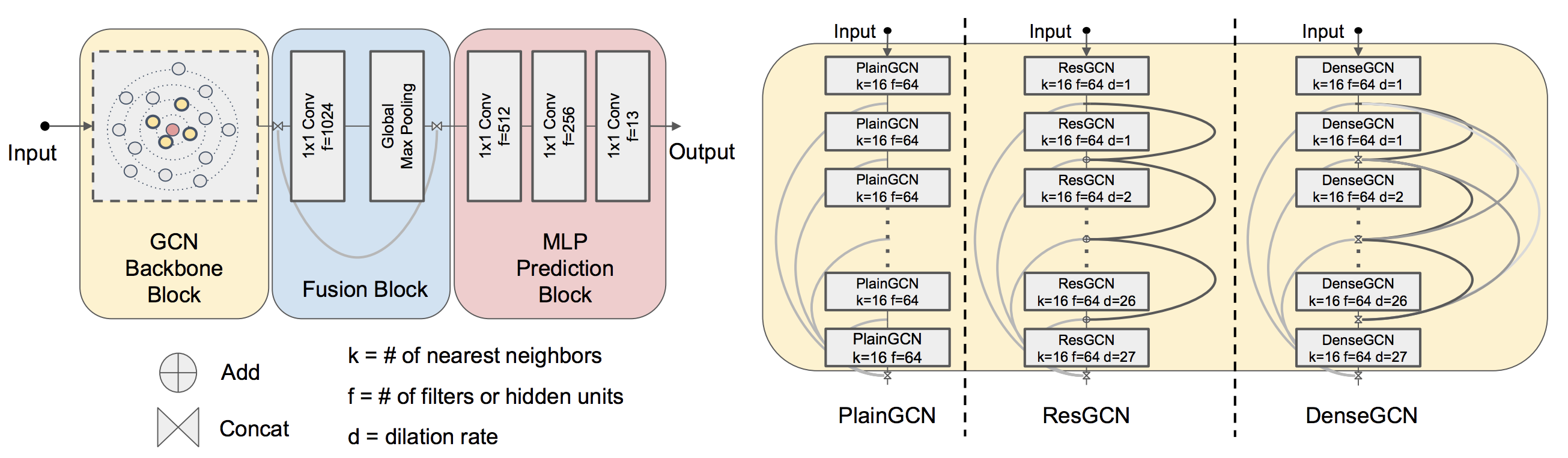

В этой работе мы представляем новые способы успешной тренировки очень глубоких GCN. Мы заимствуем концепции из CNN, в основном остаточные/плотные соединения и расширенные свертывания и адаптируем их к архитектурам GCN. Благодаря обширным экспериментам мы показываем положительный эффект этих глубоких рамок GCN.

[Project] [Paper] [слайды] [код tensorflow] [код pytorch]

Мы проводим обширные эксперименты, чтобы показать, как различные компоненты (#layers, #filters, #nearest соседи, дилатация и т. Д.) DeepGCNs эффект. Мы также проводим исследования абляции по различным типам глубоких GCN (MRGCN, EDGECONV, GRAPHSAGE и GIN).

Пожалуйста, посмотрите детали в Readme.md каждой задачи внутри папки examples . Там можно найти всю информацию о коде, данных и предварительных моделях.

examples/ogb_eff/ogbn_arxiv_dglУстановите Enviloment с помощью Runing:

source deepgcn_env_install.sh

.

├── misc # Misc images

├── utils # Common useful modules

├── gcn_lib # gcn library

│ ├── dense # gcn library for dense data (B x C x N x 1)

│ └── sparse # gcn library for sparse data (N x C)

├── eff_gcn_modules # modules for mem efficient gnns

├── examples

│ ├── modelnet_cls # code for point clouds classification on ModelNet40

│ ├── sem_seg_dense # code for point clouds semantic segmentation on S3DIS (data type: dense)

│ ├── sem_seg_sparse # code for point clouds semantic segmentation on S3DIS (data type: sparse)

│ ├── part_sem_seg # code for part segmentation on PartNet

│ ├── ppi # code for node classification on PPI dataset

│ └── ogb # code for node/graph property prediction on OGB datasets

│ └── ogb_eff # code for node/graph property prediction on OGB datasets with memory efficient GNNs

└── ...

Пожалуйста, цитируйте нашу газету, если вы найдете что -нибудь полезное,

@InProceedings{li2019deepgcns,

title={DeepGCNs: Can GCNs Go as Deep as CNNs?},

author={Guohao Li and Matthias Müller and Ali Thabet and Bernard Ghanem},

booktitle={The IEEE International Conference on Computer Vision (ICCV)},

year={2019}

}

@article{li2021deepgcns_pami,

title={Deepgcns: Making gcns go as deep as cnns},

author={Li, Guohao and M{"u}ller, Matthias and Qian, Guocheng and Perez, Itzel Carolina Delgadillo and Abualshour, Abdulellah and Thabet, Ali Kassem and Ghanem, Bernard},

journal={IEEE Transactions on Pattern Analysis and Machine Intelligence},

year={2021},

publisher={IEEE}

}

@misc{li2020deepergcn,

title={DeeperGCN: All You Need to Train Deeper GCNs},

author={Guohao Li and Chenxin Xiong and Ali Thabet and Bernard Ghanem},

year={2020},

eprint={2006.07739},

archivePrefix={arXiv},

primaryClass={cs.LG}

}

@InProceedings{li2021gnn1000,

title={Training Graph Neural Networks with 1000 layers},

author={Guohao Li and Matthias Müller and Bernard Ghanem and Vladlen Koltun},

booktitle={International Conference on Machine Learning (ICML)},

year={2021}

}

MIT Лицензия

Для получения дополнительной информации, пожалуйста, свяжитесь с Гохао Ли, Матиасом Мюллером, Гучэном Цянь.