Разработал сценарий скребки веб -царапины в Python с использованием селена и красивых библиотек супов для извлечения информации обо всех соединениях LinkedIn пользователя, преобразовал собранные данные и выполнил базовый анализ данных на синтезированных данных. Затем разработал панель панели веб -приложения с использованием Dash Framework, чтобы представить результаты анализа. Как можно увидеть выше, проект разделен на 3 части:

Использовал библиотеки Selenium и Beautiful Soup для выполнения веб -царапины для извлечения информации из профилей пользователей LinkedIn. Используется 3 метода: вход в систему, Connections_scraper и Profile_scraper. Они были разделены на 3 DataFrames: Connections_data, образование и опыт.

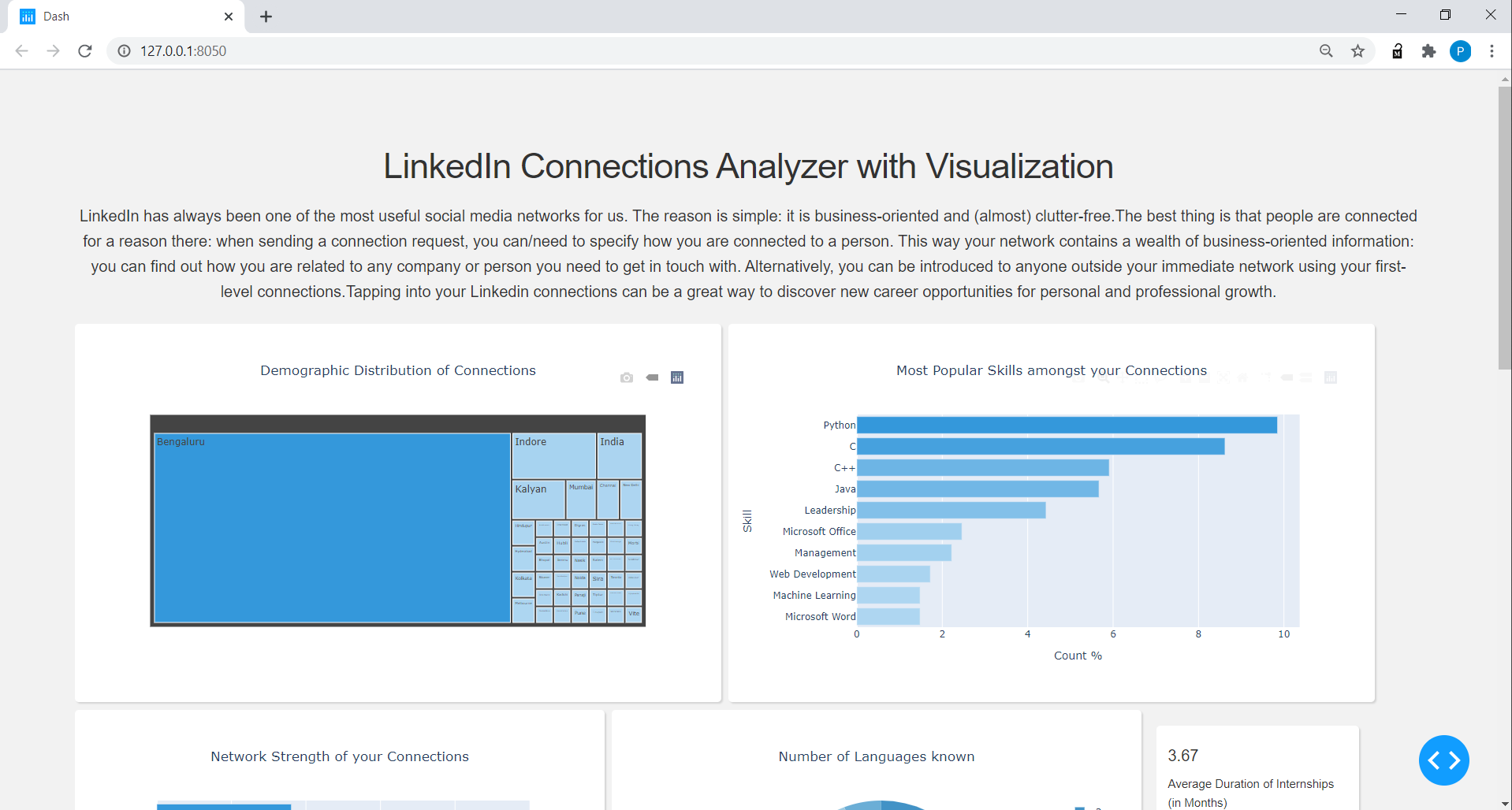

Connections_data: извлеченное имя, заголовок, местоположение, профиль, количество соединений, количество проектов, количество известных языков и главные навыки для Connections_data.

Образование: извлеченный институт, степень и год обучения.

Опыт: извлеченный профиль, позиция, компания, продолжительность опыта DataFrame.

Собранные данные были в необработанной форме и должны были быть очищены и трансформированы, чтобы их анализировали и получили информацию. Есть 3 DataFrames, а именно: Connections_data, опыт и образование.

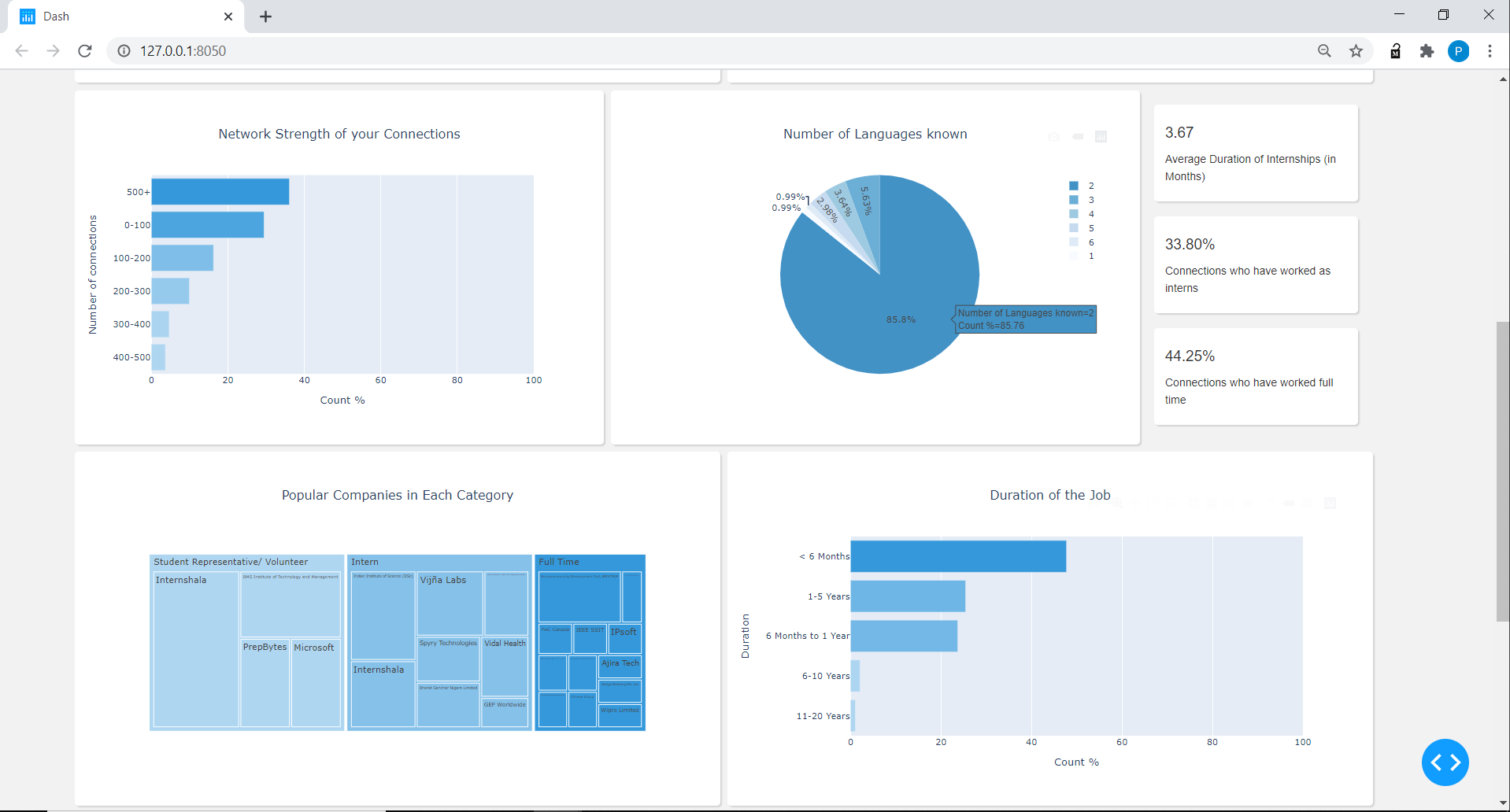

Для DataFrame Connections_data очистил столбец местоположения, чтобы просто отобразить название города без слов, таких как «область», разделенное количество соединений на 6 категорий диапазона, таких как 0-100, 100-200, ... до 500+, количество языков, количество проектов и создал словарь для топ-трех навыков с представленными предложениями каждого из соединений, а затем, наконец, подсчитывая число людей для каждого квара.

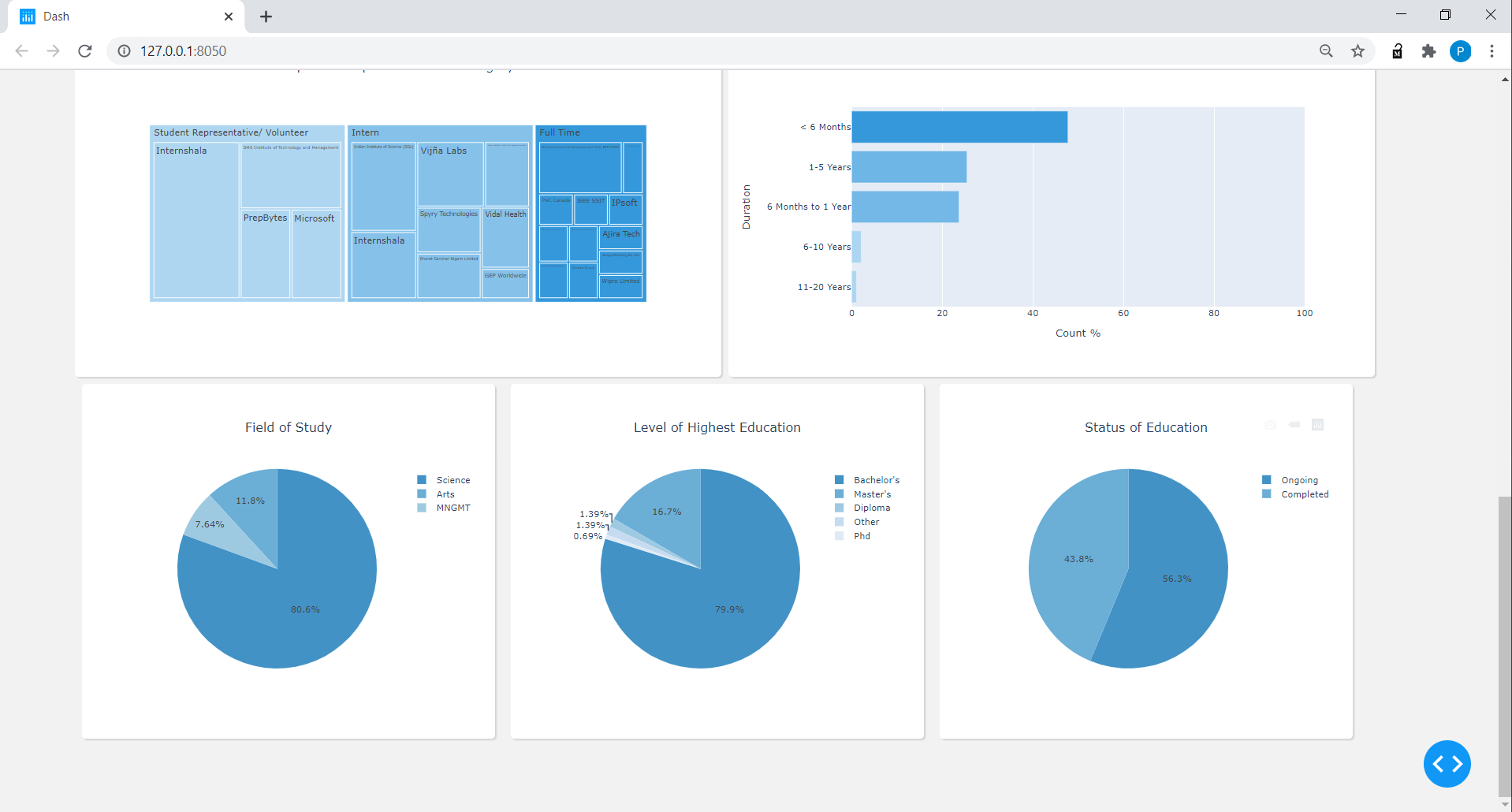

Для образования DataFrame, на основе имени Института и степени классифицировал область исследования по 3 категориям (в настоящее время для простоты): наука, управление и искусство, обнаружили статус образования на основе диапазона года, предоставленного в профиле для конкретного уровня образования. Также выяснил высочайший уровень образования для связей, основанных на словах «бакалавриата», «Мастера» и т. Д., Данные в области образования в профиле.

Для опыта DataFrame разделил столбец по позиции на 3 категории: полный рабочий день, стажеры, представители студентов или добровольцы, создали 6 категорий в рамках столбца продолжительности, начиная с <от 6 месяцев до 20+ лет.

Dash - самая загруженная, надежная структура для создания веб -приложений ML и Data Science. Приложения для полного стека, которые обычно требуют переднего класса, бэкэнд и команды разработчиков, теперь могут быть построены и развернуты в часах учеными для данных с DASH. С помощью открытого исходного кода Dash приложения Dash работают на вашем локальном ноутбуке или рабочей станции, но не могут быть легко доступны другим в вашей организации. Чтобы узнать больше и понять Дэш, посетите https://plotly.com/dash/

Графическая библиотека Python's Python создает интерактивные графики качества публикации. Модуль plotly.Express (обычно импортируемый как PX) содержит функции, которые могут создавать целые цифры одновременно, и называется как Plotly Express или PX. Plotly Express является встроенной частью библиотеки сюжета и является рекомендуемой отправной точкой для создания наиболее распространенных цифр. Чтобы узнать больше о сюжете, посетите https://plotly.com/python/

Поскольку это первый раз, когда мы использовали Dash, приборная панель выглядит довольно просто (состоящая из интерактивных барных диаграмм и круговых диаграмм с плитками и картами деревьев), но в то же время очень информативно. Мы планируем включить больше изменений в отношении тонкостей на уровне или области обучения/работы позже.

Примечание. Важно иметь папку активов в той же папке, в которой вы реализуете свое приложение, поскольку это необходимо для целей хриптиза.